如何快速掌握从CPU到NPU的算子迁移与性能调优方法?

在大模型与深度学习规模化应用的背景下,NPU(神经网络处理单元)凭借并行计算优势成为模型推理 / 训练的核心硬件,但 CPU 与 NPU 在架构设计、指令集、内存模型上的本质差异(如图 1),导致算子迁移面临兼容性适配、性能瓶颈定位等关键挑战。据昇腾社区数据显示,未优化的算子迁移后性能损耗可达 30%-70%,而科学的迁移流程与调优策略能使 NPU 算力利用率提升至 80% 以上。本文聚焦 “快速

前言

在大模型与深度学习规模化应用的背景下,NPU(神经网络处理单元)凭借并行计算优势成为模型推理 / 训练的核心硬件,但 CPU 与 NPU 在架构设计、指令集、内存模型上的本质差异(如图 1),导致算子迁移面临兼容性适配、性能瓶颈定位等关键挑战。据昇腾社区数据显示,未优化的算子迁移后性能损耗可达 30%-70%,而科学的迁移流程与调优策略能使 NPU 算力利用率提升至 80% 以上。本文聚焦 “快速落地” 需求,整合行业成熟工具链与实操案例,帮助开发者高效完成算子迁移与性能调优。

**

图 1:CPU 与 NPU 核心特性差异示意图

一、算子迁移核心原理与前提准备

1. 迁移本质:硬件特性与算子逻辑的适配

NPU 的核心优势在于并行计算密集型任务(如卷积、矩阵乘),其硬件架构(如昇腾 3D Cube 引擎、寒武纪思元芯片的张量计算单元)对规整数据访问、低分支逻辑更友好,而 CPU 擅长串行复杂控制流处理。迁移的核心是解决三大矛盾:

- 指令集差异:CPU 的 x86/ARM 指令与 NPU 专用指令(如 CubeMatMul、HMMA)的映射;

- 内存模型差异:CPU 的虚拟内存管理 vs NPU 的显式内存同步(如 DMABUF/ION 分配);

- 计算范式差异:CPU 的串行执行 vs NPU 的多核心 / 多线程并行调度。

2. 迁移前准备工作

|

准备环节 |

具体操作 |

工具推荐 |

|

环境搭建 |

安装 NPU 驱动、框架插件(如 torch_npu、MindSpore)、厂商工具链(CANN、HiAI) |

昇腾 MindStudio、寒武纪 Neuware |

|

算子扫描 |

提取模型中所有算子,识别不支持算子与依赖关系 |

PyTorch torch.jit.export_opnames、昇腾 mschecker |

|

兼容性评估 |

标记控制流算子(如 NMS)、动态 Shape 操作、自定义 Kernel |

昇腾 Compatibility Checker、ONNX Runtime 兼容性测试 |

二、算子迁移三步法(快速落地流程)

1. 第一步:算子分类与替换策略

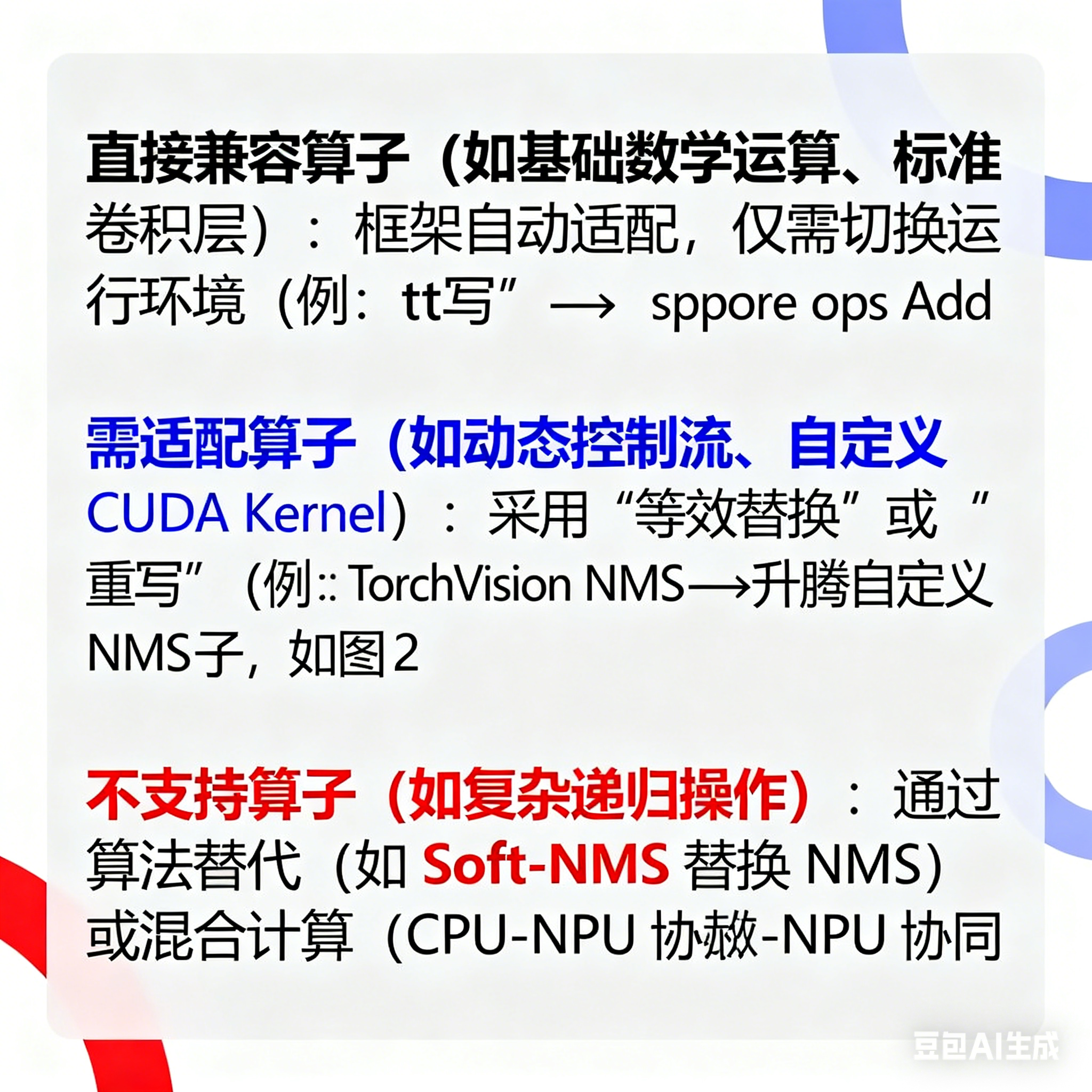

根据兼容性评估结果,将算子分为三类并采用对应迁移方案:

- 直接兼容算子(如基础数学运算、标准卷积层):框架自动适配,仅需切换运行环境(例:torch.add → mindspore.ops.Add);

- 需适配算子(如动态控制流、自定义 CUDA Kernel):采用 “等效替换” 或 “重写”(例:TorchVision NMS → 昇腾自定义 NMS 算子,如图 2);

- 不支持算子(如复杂递归操作):通过算法替代(如 Soft-NMS 替换 NMS)或混合计算(CPU-NPU 协同)。

**

图 2:不支持算子的迁移替换流程示意图

2. 第二步:模型转换与算子注册

- 模型格式转换:将 CPU 训练的模型(.pt/.pb)转换为 NPU 支持的格式(如 OM、ONNX),工具示例:

# 昇腾Model Converter转换TensorFlow模型

model_convert_tool --framework=1 --model_file=tf_model.pb --output_file=model.om --soc_version=Ascend310

- 自定义算子注册:通过厂商提供的接口(如昇腾 TBE、HiAI Foundation Kit)编写算子代码并注册,示例代码片段:

// 昇腾TBE自定义加法算子核心逻辑

HIAI_StatusT AddOperator(const HIAI_RIOperator* op, HIAI_RITensor** output_tensors) {

HIAI_RITensor* input0 = op->input_tensors(0);

HIAI_RITensor* input1 = op->input_tensors(1);

HIAI_RITensor* output = hiaiRITensorCreate(op->output_descs(0));

for (int i=0; i<input0->shape.size; ++i) {

output->data(i) = input0->data(i) + input1->data(i);

}

*output_tensors = &output;

return HIAI_OK;

}

3. 第三步:精度验证与问题修复

迁移后需确保模型精度无显著下降:

- 精度指标:对比 CPU 与 NPU 的输出误差(相对误差≤1e-5 为可接受);

- 常见问题修复:

-

- 数值偏差:启用 NPU 高精度模式,关键算子后插入 FP32 强制转换;

-

- 动态 Shape 报错:使用昇腾npu_compile模式将动态图编译为静态图;

-

- 内存同步错误:添加显式 cache flush 指令(如昇腾aclrtSynchronizeStream)。

三、性能调优核心方法与工具链实操

1. 性能瓶颈定位:三大核心维度

NPU 算子性能瓶颈主要源于计算、存储、并行调度三大维度(如图 3),需通过专业工具精准识别:

- 计算瓶颈:指令执行效率低(如非对齐维度计算);

- 存储瓶颈:内存访问不规整、Cache 命中率低;

- 并行瓶颈:核心负载不均、数据分片不合理。

**

图 3:NPU 算子性能瓶颈三维分析模型

2. 主流调优工具链使用指南(以昇腾 MindStudio 为例)

昇腾 MindStudio 的 msProf op 工具提供 “上板调优 + 仿真调优” 双模式,覆盖全流程瓶颈定位:

|

工具功能 |

核心作用 |

实操步骤 |

|

计算内存热力图 |

识别全局资源负载瓶颈 |

1. 执行msprof op --aic-metrics=Default --application=xxx;2. 导入 MindStudio Insight 查看负载分布 |

|

Roofline 瓶颈分析图 |

快速判断瓶颈类型(计算 / 存储) |

自动生成理论性能极限曲线,对比实际性能落点 |

|

Cache 热力图 |

优化 L2Cache 命中率 |

定位 Cache 未命中热点,调整数据访问顺序 |

|

代码热点图 |

识别耗时函数 |

映射源码与指令集耗时,优化热点代码(如循环展开) |

调优流程示例(CrossEntropy 算子优化):

- 上板采集性能数据,发现 scalar 运算占比 87.86%(瓶颈);

- 仿真调优定位到第 109 行 OneHot 循环操作;

- 用 Ascend C Duplicate API 替换 for 循环,减少 scalar 运算;

- 迭代测试,算子耗时从 45.42us 降至 12.8us(性能提升 71.8%)。

3. 关键调优策略(可直接落地)

- 计算优化:适配 NPU 硬件特性(如昇腾 3D Cube 引擎偏好 16×16×256 矩阵块);

- 内存优化:使用连续数据排布、批量数据传输,减少 PCIe 带宽占用;

- 并行优化:基于 NPU 核心数合理分片(如昇腾 910 32 核心对应 32 路数据分片);

- 指令优化:替换低效 API(如 SetValue→Duplicate)、启用指令融合。

四、典型场景与避坑指南

1. 常见迁移场景解决方案

|

场景 |

问题描述 |

解决方案 |

|

控制流算子(NMS) |

回退 CPU 执行,延迟高 |

替换为厂商定制算子(昇腾 acl_nms) |

|

动态 Shape |

静态图框架不兼容 |

启用npu_compile模式或固定输入维度 |

|

自定义 CUDA Kernel |

无 NPU 等效实现 |

用 TBE/HiAI 重写算子核心逻辑 |

|

多卡并行 |

通信开销大 |

替换为 NPU 专用集合通信库(HCCL→NCCL) |

2. 避坑要点

- 避免直接移植 CPU 算子逻辑:需重构为 NPU 友好的并行计算模式;

- 重视数据格式转换:CPU 的 NHWC 格式需转为 NPU 偏好的 NCHW 格式;

- 拒绝盲目优化:先通过工具定位瓶颈,再针对性调整(如 Cache 命中率低则优化内存访问,而非盲目增加并行度);

- 优先使用厂商工具链:减少手动编码成本(如 MindStudio 自动生成算子框架代码)。

总结

CPU 到 NPU 的算子迁移与性能调优的核心逻辑是 “先适配,后优化”:迁移阶段需解决硬件兼容性问题,通过 “分类替换 - 模型转换 - 精度验证” 快速落地;调优阶段需依托专业工具链定位瓶颈,从计算、内存、并行、指令四个维度系统性优化。关键在于充分利用 NPU 并行计算优势,规避 CPU-NPU 架构差异带来的性能损耗。

实践中,建议优先采用厂商提供的工具链(如昇腾 MindStudio、寒武纪 Neuware)和预制算子库,减少自定义开发成本;同时通过典型案例(如 NMS、CrossEntropy)积累经验,形成可复用的优化模板。随着 NPU 生态的完善,自动化迁移工具(如昇腾 AutoML)正逐步降低门槛,但掌握核心优化原理仍是应对复杂场景的关键。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)