【2025年昇腾CANN训练营第二季】源码精读:Ops-Math库基础算子高性能实现模式解析

通过对ops-math库中add算子的解析,可以归纳出高性能Ascend C算子开发的几个核心模式:基于SPMD的并行化、利用流水线与双缓冲实现计算访存重叠、以及面向硬件特性的精细内存管理与数据分块。实践建议如下模式复用:在开发自定义算子时,可优先借鉴ops-math中已验证的流水线框架、双缓冲实现和内存管理范式,将主要精力集中于核心计算逻辑的差异部分。对比学习:建议将add算子与mulexp等其

昇腾训练营报名链接: https://www.hiascend.com/developer/activities/cann20252#cann-camp-2502-intro

训练营简介:2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

一、引言:通过源码分析深入理解高性能算子开发

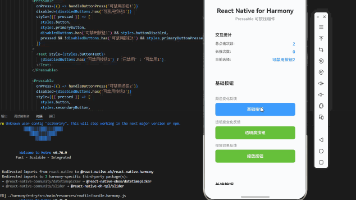

在掌握昇腾Ascend C基础编程模型后,深入研读官方提供的优质源码是提升开发能力的关键路径。CANN社区开源的 ops-math 数学基础算子库,为开发者提供了符合工业级标准、经过充分性能优化的基础算子实现。本文将以该库中基础的 add 算子为例,系统解析其为实现昇腾AI处理器极致性能所采用的设计模式与关键技术,为开发者编写高性能自定义算子提供参考。

二、Ops-Math库的核心研读价值

ops-math 库作为构建复杂神经网络模型的基础,其源码具有多方面的学习价值,主要体现为以下三个层面:

| 价值维度 | 具体体现 | 对开发者的意义 |

|---|---|---|

| 性能优化范本 | 系统运用了双缓冲、流水线并行、矢量计算等针对达芬奇架构的优化技术。 | 为开发高性能算子提供了可复现的优化模式和实践模板。 |

| 工程实践标杆 | 代码结构清晰,模块化程度高,接口定义规范,并包含完整的错误处理机制。 | 展示了生产级算子代码应具备的可靠性、可维护性和可读性。 |

| 硬件架构映射 | 代码逻辑直接反映了AI Core、多级存储系统等硬件单元的工作机制。 | 帮助开发者将抽象的硬件架构知识转化为具体的编程实践。 |

三、Add算子高性能实现关键技术解析

以下将分层剖析 ops-math/kernel/add 算子实现中所蕴含的核心技术。

3.1 并行计算模型:SPMD模式的实现

add 算子的核函数严格遵循SPMD(单程序多数据)并行模型,这是发挥AI处理器多核能力的基础。

extern "C" __global__ __aicore__ void add_custom(GM_ADDR x, GM_ADDR y, GM_ADDR z, ...) {

// 使用 __aicore__ 函数类型限定符,指明该函数在AI Core上执行

KernelAdd op;

op.Init(x, y, z, ...); // 初始化算子对象,配置参数与内存

// 主处理循环:所有计算核心同步执行此循环,处理各自分配的数据块

while (op.Process()) {

// 各核心在此执行相同的计算逻辑,但操作的是全局数据的不同分区

}

}

技术要点:

-

并行执行:编译与运行时系统将根据数据规模,在多个AI计算核心上同时启动该核函数的多个实例。

-

数据分区:每个计算核心通过内置的索引变量(如

block_idx)隐式地确定其需处理的数据范围,实现全局数据的自动划分与负载分配。

3.2 计算与访存重叠:流水线与双缓冲机制

为避免计算单元因等待数据访存而空闲,该实现采用了流水线技术,并通过双缓冲机制实现“计算-搬运”的完全重叠。

// 概念性伪代码,展示流水线阶段

while (op.Process()) {

// 流水线阶段1 (搬运入): 将下一数据块从全局内存预取至本地缓冲区B。

// 流水线阶段2 (计算): 对当前已位于本地缓冲区A中的数据块执行加法运算。

// 流水线阶段3 (搬运出): 将上一计算结果从本地缓冲区写回至全局内存。

// 每次循环后,缓冲区A与B的角色进行交换,实现双缓冲切换。

}

机制优势:

-

隐藏访存延迟:通过将数据搬运(高延迟操作)与数学计算(核心操作)安排在不同的硬件流水线上并行执行,有效将访存延迟“隐藏”在计算时间之内。

-

稳定吞吐率:双缓冲确保了每个计算周期内,计算单元始终能立即获得已就绪的数据,消除了因数据未到位而产生的流水线气泡,从而维持稳定的高性能吞吐。

3.3 高效内存管理:分级存储与数据分块策略

高效管理芯片上的多层次存储系统是性能优化的另一个重点。

-

存储层级利用:代码通过

LocalTensor等抽象,显式地将高频访问的数据放置在速度更快的Local Memory或Unified Buffer (UB) 中,减少访问全局内存的延迟。 -

数据分块(Tiling):

tiling_custom函数负责制定分块策略,这是连接算法与硬件的关键环节。

void tiling_custom(uint32_t totalLength, uint32_t* tileNum, ...) {

// 根据总数据量和对齐要求,计算最优的数据分块数量

*tileNum = (totalLength + BLOCK_SIZE - 1) / BLOCK_SIZE;

}

设计考量:

-

负载均衡:合理划分数据块,确保所有计算核心的负载大致相当,避免部分核心提前空闲。

-

内存容量约束:分块大小必须适配AI Core上快速存储的物理容量,防止数据溢出。

-

对齐与效率:块大小通常设计为硬件处理单元宽度的整数倍,以最大化矢量计算效率并满足内存对齐要求。

四、总结与实践建议

通过对 ops-math 库中 add 算子的解析,可以归纳出高性能Ascend C算子开发的几个核心模式:基于SPMD的并行化、利用流水线与双缓冲实现计算访存重叠、以及面向硬件特性的精细内存管理与数据分块。

实践建议如下:

-

模式复用:在开发自定义算子时,可优先借鉴

ops-math中已验证的流水线框架、双缓冲实现和内存管理范式,将主要精力集中于核心计算逻辑的差异部分。 -

对比学习:建议将

add算子与mul、exp等其它基础算子的实现进行对比分析,识别其通用模式与特定优化,加深理解。 -

实验验证:在训练营或开发环境中,尝试编译并运行

ops-math的样例,通过性能剖析工具观察不同优化技术对实际执行周期的影响。

深入研读优秀源码是掌握昇腾AI处理器编程精髓的有效方法。参与2025年昇腾CANN训练营第二季,结合系统课程与社区开源项目进行实践,将加速您从理论到工程实现的能力跨越。

学习官网:https://www.hiascend.com/activities 学习仓库:https://gitcode.com/cann

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)