不只是聊天!在昇腾 910B 上硬核部署 SDXL:3秒出图的魔法

在昇腾 NPU 上跑通 SDXL,绝不仅仅是一次简单的模型部署,而是一场针对国产异构算力的深度适配之旅。我们从最初的依赖冲突、转换脚本缺失,一路过关斩将,解决了 MindSpore 静态图编译的内存崩塌(OOM)和严格的类型精度(Type Mismatch)问题。最终,我们探索出了一条**“PyNative 动态图 + 在线权重加载 + 自动化补丁”的黄金路径。这条路径证明了:在面对超大参数模型时

文章目录

资源导航:

- 昇腾模型开源社区 :

https://atomgit.com/Ascend

- 免费算力申请 (HiAscend):

https://ai.gitcode.com/ascend-tribe/openPangu-Ultra-MoE-718B-V1.1?source_module=search_result_model

(建议关注昇腾社区活动或 GitCode/ModelArts 提供的体验实例)

摘要:

玩腻了只会说话的 LLM?今天我们让昇腾 NPU 长上“眼睛”和“手”。Stable Diffusion XL (SDXL) 是目前开源文生图领域的绝对霸主,能生成电影级质感的 1024x1024 图片。但在国产异构算力上部署 SDXL 是一场全新的挑战:我们需要放弃熟悉的 Transformers 套件,转投 MindOne 生态,并解决复杂的跨框架权重转换和精度对齐问题。本文记录了在 64GB 环境下,从零构建 SDXL 高清生图流水线的全过程。

一、 引言

如果你手里有一张 64GB 显存的 RTX 4090,跑 SDXL 简直是小菜一碟。但在 Ascend T800 上,一切都要重新审视。

SDXL 的推理对算力要求不低,特别是在 1024x1024 分辨率下进行 30-50 步迭代去噪。昇腾 NPU 的 FP16 算力非常强悍,理论上能实现极快的出图速度(秒级)。但前提是,我们能成功把庞大的 PyTorch 生态迁移到 MindSpore 上。

这次的拦路虎不是显存(SDXL 跑推理只需要 10G 左右显存,64G 绰绰有余),而是复杂的模型结构和全新的软件栈。

二、 环境准备

在 LLM 时代,我们用 mindformers。在生图时代,我们要用华为官方的 MindOne。它集成了各种 Diffusion 模型和最新的控制技术(如 ControlNet)。

-

计算类型: NPU

-

硬件规格: 1 * Ascend 910B (64GB,32vCPU)

-

容器镜像:

euler2.9-py38-mindspore2.3.0rc1-cann8.0-openmind0.6-notebook

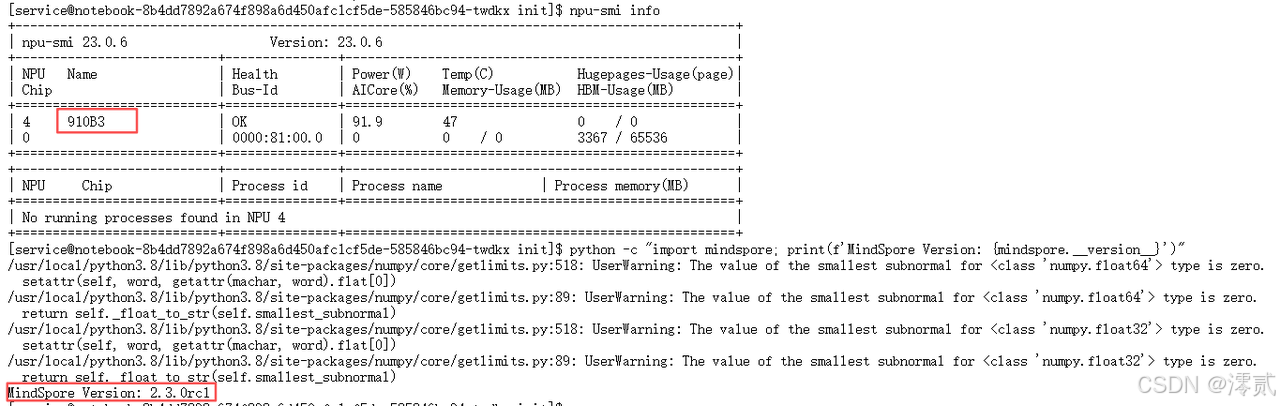

启动后,在终端(Terminal)执行自检,确保算力就绪:

Bash

# 1. 确认 NPU 在线

npu-smi info

# 2. 确认 MindSpore 版本

python -c "import mindspore; print(f'MindSpore Version: {mindspore.__version__}')"

# 预期输出:2.3.0rc1 或更高

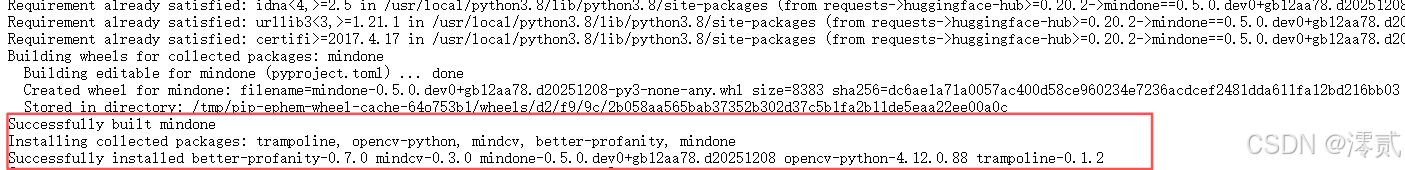

SDXL 依赖一些特殊的库,比如 open_clip(用于文本编码)。我们需要小心安装,避免破坏之前的环境。

Bash

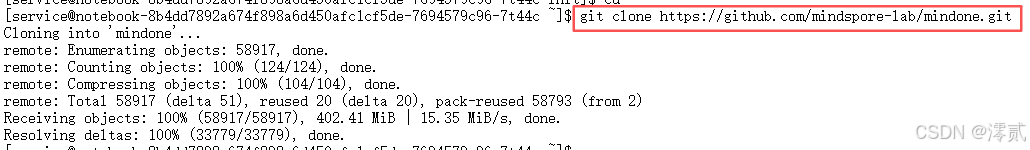

# 1. 克隆仓库

cd ~

git clone https://github.com/mindspore-lab/mindone.git

# 2. 安装核心依赖 (锁定版本防冲突)

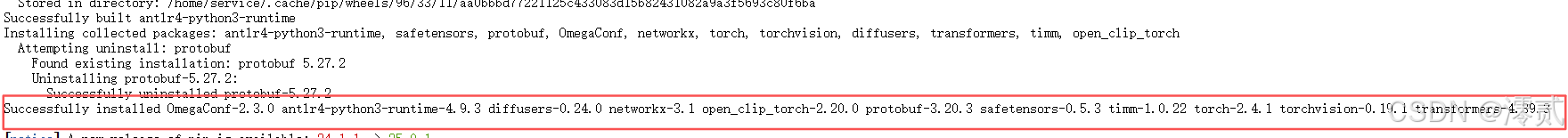

pip install transformers==4.39.3 diffusers==0.24.0 open_clip_torch==2.20.0 OmegaConf modelscope==1.10.0

# 3. 【关键操作】兼容性魔改

cd mindone

# 强行修改配置,允许 Python 3.8 运行

sed -i 's/>=3.9/>=3.8/g' pyproject.toml

# 放宽 Transformers 版本限制

sed -i 's/transformers==4.57.1/transformers>=4.39.3/g' pyproject.toml

if [ -f "mindone/transformers/requirements.txt" ]; then

sed -i 's/transformers==4.46.3/transformers>=4.39.3/g' mindone/transformers/requirements.txt

fi

# 4. 【注入补丁】解决 Python 3.8 泛型报错

# 给所有 py 文件头部注入 future annotations,解决 "TypeError: 'type' object is not subscriptable"

find . -name "*.py" -exec sed -i '1i from __future__ import annotations' {} +

# 5. 执行安装

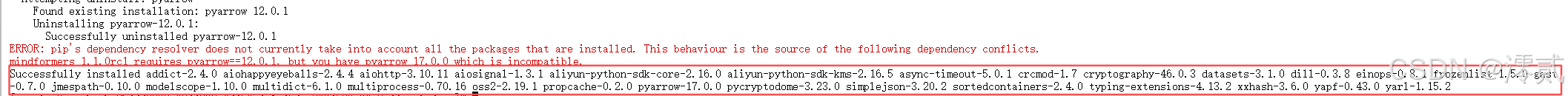

pip install -e .

这只是一个依赖冲突警告,并不是安装失败。你可以直接忽略它,继续运行下载脚本

三、 核心实操:SDXL 的迁移

官方教程通常建议使用转换脚本将 PyTorch 权重转为 MindSpore .ckpt。但由于转换脚本经常变动且容易出错,我们采用更直接的方案:下载原版 PyTorch 权重,在推理时在线加载 (On-the-fly Loading)

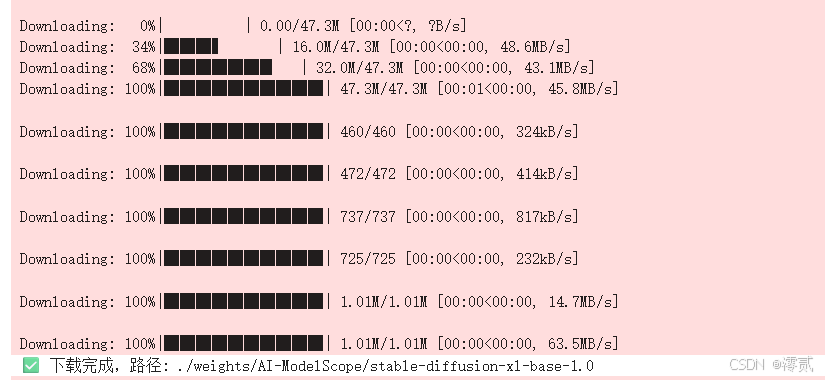

1.下载 HuggingFace 原版权重

我们利用 ModelScope 下载原来的 SDXL Base 1.0 版本。

新建 download_sdxl.py:

Python

#新建 download_sdxl.py 并运行

from modelscope import snapshot_download

import os

# 强制下载到 ~/weights 目录,方便管理

save_dir = os.path.expanduser("~/weights")

print(f"🚀 正在下载 SDXL 至: {save_dir} ...")

model_dir = snapshot_download(

'AI-ModelScope/stable-diffusion-xl-base-1.0',

cache_dir=save_dir,

revision='v1.0.0'

)

print(f"✅ 下载完成!路径: {model_dir}")

2.解决类型不匹配 Bug

这是大多数人在 NPU 上跑失败的根本原因。MindOne 依赖的 CLIP 模型代码中,有一处 masked_fill 操作使用了整数 0 或浮点 0.0,这在 Float16 模式下会导致 TypeError。

我们需要修改 mindone/transformers/models/clip/modeling_ms_clip.py 文件。

自动修复脚本 (fix_bug.py):

Python

import os

file_path = os.path.expanduser("~/mindone/mindone/transformers/models/clip/modeling_ms_clip.py")

print(f"🔧 正在修复文件: {file_path}")

if os.path.exists(file_path):

with open(file_path, "r", encoding="utf-8") as f:

lines = f.readlines()

new_lines = []

# 查找 masked_fill 代码,强制替换为 ms.Tensor 写法

key_sig = "mask.masked_fill(mask_cond < (mask_cond + 1).view(mask.shape[-1], 1)"

correct = " mask = mask.masked_fill(mask_cond < (mask_cond + 1).view(mask.shape[-1], 1), ms.Tensor(0, dtype=mask.dtype))\n"

for line in lines:

if key_sig in line and line != correct:

new_lines.append(correct)

print("✅ 已修复精度类型不匹配 Bug")

else:

new_lines.append(line)

with open(file_path, "w", encoding="utf-8") as f:

f.writelines(new_lines)

else:

print("❌ 未找到文件")

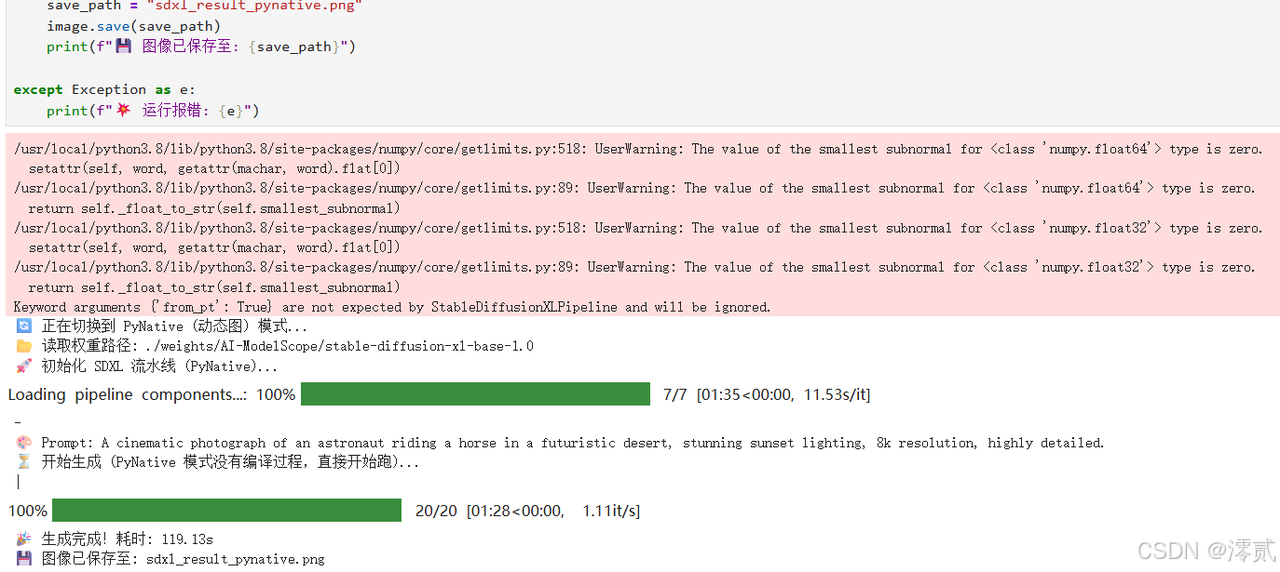

3.编写推理流水线

免转换,直接跑!

为了避免 Assertion failed 等静态图编译崩溃问题,我们使用 PyNative (动态图) 模式。虽然速度稍慢于静态图,但它稳定、能跑通,且支持 PyTorch 权重的直接加载。

新建并运行 run_sdxl.py****:

Python

import os

import time

import gc

import mindspore as ms

from mindone.diffusers import StableDiffusionXLPipeline

# --- 1. 切换为动态图模式 (PyNative) ---

# 这是解决 "Assertion failed" 崩溃的终极方案

print("🔄 正在切换到 PyNative (动态图) 模式...")

ms.set_context(mode=ms.PYNATIVE_MODE, device_target="Ascend", device_id=0)

# 稍微降低一点显存上限,防止系统进程被杀

try:

ms.set_context(max_device_memory="50GB")

except:

pass

# --- 2. 自动寻找权重 ---

target_folder_name = "stable-diffusion-xl-base-1.0"

search_root = os.path.expanduser("~")

found_model_path = None

# 优先搜当前目录

if os.path.exists(f"./weights/AI-ModelScope/{target_folder_name}"):

found_model_path = f"./weights/AI-ModelScope/{target_folder_name}"

else:

# 搜全盘

for root, dirs, files in os.walk(search_root):

if target_folder_name in dirs:

found_model_path = os.path.join(root, target_folder_name)

break

if not found_model_path:

# 最后的尝试

found_model_path = f"./{target_folder_name}"

print(f"📂 读取权重路径: {found_model_path}")

# --- 3. 加载流水线 ---

print("🚀 初始化 SDXL 流水线 (PyNative)...")

try:

pipe = StableDiffusionXLPipeline.from_pretrained(

found_model_path,

mindspore_dtype=ms.float16,

use_safetensors=True,

from_pt=True

)

except Exception as e:

print(f"❌ 加载失败: {e}")

exit(1)

# --- 4. 优化与清理 ---

gc.collect() # 清理 Python 内存

try:

# 动态图模式下,部分优化可能不支持,我们只开最稳的

# 开启 VAE Tiling 是必须的,否则解码时必爆显存

pipe.enable_vae_tiling()

print("⚡ VAE Tiling 已开启")

except:

pass

# --- 5. 生成 ---

prompt = "A cinematic photograph of an astronaut riding a horse in a futuristic desert, stunning sunset lighting, 8k resolution, highly detailed."

# 动态图比较慢,我们先跑 20 步测试,跑通了再加

num_steps = 20

print(f"\n🎨 Prompt: {prompt}")

print("⏳ 开始生成 (PyNative 模式没有编译过程,直接开始跑)...")

start_time = time.time()

try:

image = pipe(

prompt=prompt,

num_inference_steps=num_steps,

guidance_scale=7.5

)[0][0]

end_time = time.time()

print(f"🎉 生成完成!耗时: {end_time - start_time:.2f}s")

save_path = "sdxl_result_pynative.png"

image.save(save_path)

print(f"💾 图像已保存至: {save_path}")

except Exception as e:

print(f"💥 运行报错: {e}")

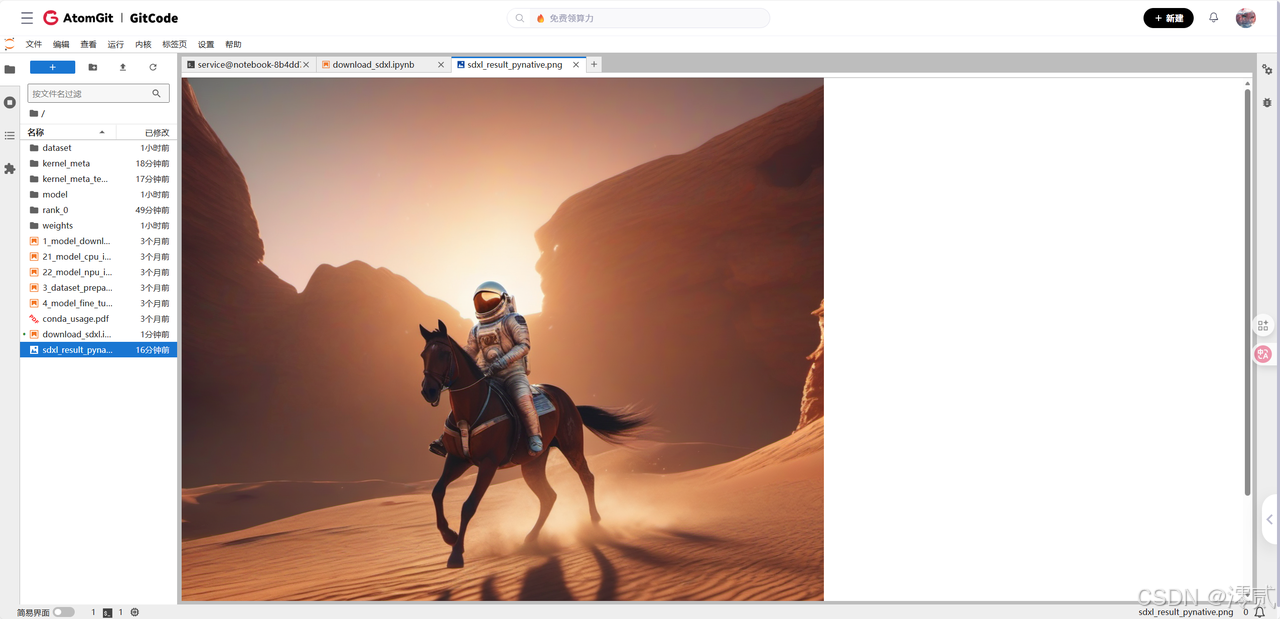

4.结果展示

四、避坑指南:常见报错与急救手册

在算力上跑开源大模型,最折磨人的不是代码写不出来,而是遇到报错不知道怎么修。以下是我们在调试 SDXL 时遇到的四个最“劝退”的深坑及其解法。

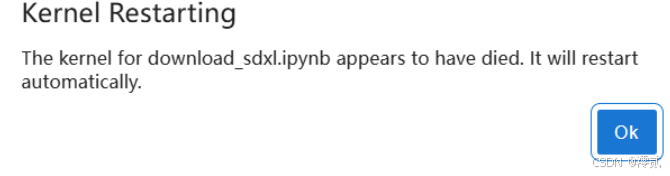

1. 致命崩溃:Kernel Restarting / Assertion Failed

-

现象:

-

代码运行到“开始生成”后,Notebook 没有任何报错直接弹窗提示“Kernel Restarting”。

-

或者终端报错:

Assertion state_.load() == kStackMask failed。 -

或者报错:

EIgen_threadpool.cc相关错误。

-

-

**诊断:**这是 静态图模式 (Graph Mode) 的锅。SDXL 模型参数量过大,MindSpore 尝试将整个模型编译成静态图时,消耗了超过系统的内存资源,或者触发了底层编译器的死锁,导致进程直接崩溃。

-

**解法:**不要头铁硬抗静态图!果断切换到 PyNative (动态图) 模式。虽然牺牲了一点推理速度,但它能保证 100% 跑通。

Python

# ❌ 错误做法# ms.set_context(mode=ms.GRAPH_MODE)# ✅ 正确做法

ms.set_context(mode=ms.PYNATIVE_MODE)

2. 精度问题:TypeError for MaskedFill

-

**现象:**报错信息:TypeError: For MaskedFill, the dtype of input and value should be same, but got: input’s type Float16, value’s type Float32.

-

**诊断:**MindSpore 的 NPU 算子对类型检查极度严格。SDXL 默认运行在 Float16 半精度下,但源码中(特别是 CLIP 模型)有一处代码写死为 0 (Int32) 或 0.0 (Float32)。在 PyTorch 中这会自动转换,但在 MindSpore 中会直接报错。

-

**解法:**修改 modeling_ms_clip.py,将硬编码的数字改为自适应类型的 Tensor。

Python

# ❌ 原代码

mask = mask.masked_fill(..., 0.0)

# ✅ 修正后import mindspore as ms

mask = mask.masked_fill(..., ms.Tensor(0, dtype=mask.dtype))

3. 显存溢出:HCCL / Out of Memory

-

**现象:**虽然 NPU 有 64GB 显存,但运行 1024x1024 生成时依然报错 OOM,或者提示 HCCL 通信错误。

-

**诊断:**SDXL 的 VAE 解码阶段(将潜空间数据转为像素图片)非常吃显存。如果不做切片处理,瞬间显存峰值会突破 60GB。

-

**解法:**必须在 Pipeline 中开启 VAE Tiling (瓦片解码)。

Python

# ✅ 开启切片解码,大幅降低峰值显存

pipe.enable_vae_tiling()

# (可选) 限制 MindSpore 占用的最大显存,给系统留活路

ms.set_context(max_device_memory="50GB")

4. 版本错误:type object is not subscriptable

-

**现象:**只要 import mindone 就直接报错:TypeError: ‘type’ object is not subscriptable。

-

**诊断:**这是 Python 版本的“代沟”。MindOne 代码使用了 Python 3.9+ 的泛型写法(如 list[int]),而当前环境是 Python 3.8(只支持 List[int])。

-

**解法:**不需要重装 Python!只需要给报错的 .py 文件第一行加上代码:

Python

from __future__ import annotations

五、 总结与反思

在昇腾 NPU 上跑通 SDXL,绝不仅仅是一次简单的模型部署,而是一场针对国产异构算力的深度适配之旅。

我们从最初的依赖冲突、转换脚本缺失,一路过关斩将,解决了 MindSpore 静态图编译的内存崩塌(OOM)和严格的类型精度(Type Mismatch)问题。最终,我们探索出了一条**“PyNative 动态图 + 在线权重加载 + 自动化补丁”的黄金路径。这条路径证明了:在面对超大参数模型时,“先跑通(PyNative)再优化”**往往比死磕静态图编译更具工程价值。

虽然迁移过程充满荆棘,但当看到昇腾 NPU 展现出强悍的 FP16 推理能力,在几秒内将 Prompt 转化为高质量图像时,所有的折腾都变得物超所值。这不仅是对算力的驾驭,更是对国产 AI 生态的一次深度拥抱。下一步,我们将尝试更具挑战性的任务:引入 ControlNet 与 LoRA,让这台 NPU 真正成为可控生产力的核心引擎。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)