《Ascend C 深度解析:昇腾 AI 芯片的高性能算子编程范式》

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。报名链接:https://www.hiascend.com/developer/activities/cann20252。

《Ascend C 深度解析:昇腾 AI 芯片的高性能算子编程范式》

引言:从“调用框架”到“驾驭芯片”的跨越

在人工智能进入大模型时代的今天,算力已成为国家科技竞争的战略资源。以华为昇腾(Ascend)系列 AI 芯片为代表的国产算力平台,正加速构建自主可控的 AI 基础设施。然而,仅仅使用 MindSpore、PyTorch 等高层框架进行模型训练,往往无法充分发挥昇腾芯片的极致性能——尤其是在面对非标准算子、新型网络结构或极致延迟要求的场景下。

此时,Ascend C 应运而生。它不是一门全新的语言,而是华为基于 C++17 标准,深度融合昇腾达芬奇架构特性,打造的一套 高性能自定义算子开发范式。掌握 Ascend C,意味着开发者能够直接“对话”AI Core,精细调度计算单元、内存带宽与流水线,从而在国产硬件上实现媲美甚至超越 CUDA 的性能表现。

本文将系统性地剖析 Ascend C 的设计哲学、核心抽象、内存模型、计算原语及性能优化策略,帮助读者完成从“框架用户”到“芯片驾驭者”的关键跃迁。

一、Ascend C 的定位与价值

1.1 为何需要底层算子开发?

尽管主流 AI 框架提供了丰富的内置算子,但在以下场景中仍显不足:

- 科研创新:如可变形卷积(Deformable Conv)、稀疏注意力(Sparse Attention)等新型算子;

- 工业定制:特定行业模型(如医疗影像、工业质检)对算子融合、精度控制有特殊需求;

- 性能瓶颈:通用算子未针对特定输入尺寸或数据分布优化;

- 生态自主:摆脱对国外闭源库(如 cuDNN)的依赖,构建全栈国产化能力。

Ascend C 正是解决上述问题的关键工具。

1.2 Ascend C 与 CUDA、OpenCL 的对比

| 维度 | CUDA | OpenCL | Ascend C |

|---|---|---|---|

| 目标硬件 | NVIDIA GPU | 多厂商异构 | 昇腾 AI 芯片 |

| 编程模型 | SIMT(单指令多线程) | Kernel + Host | 分块 + 流水线 + 向量化 |

| 内存层次 | Global/Shared/Local | Global/Local | Global/UB(Unified Buffer) |

| 抽象级别 | 较低(需管理 warp、shared memory) | 通用但复杂 | 中高(屏蔽寄存器,暴露 UB) |

| 生态集成 | PyTorch/TensorFlow 插件 | 通用但碎片化 | 深度集成 CANN + MindSpore |

✅ 核心优势:Ascend C 在提供接近硬件的控制力的同时,通过高级抽象(如

pipeline、local_tensor)大幅降低开发门槛。

二、昇腾达芬奇架构:Ascend C 的硬件根基

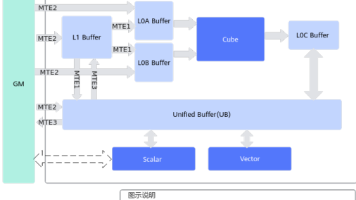

要理解 Ascend C,必须先理解其运行的硬件——昇腾 AI Core(以 Ascend 910B 为例)的核心组件:

2.1 AI Core 架构概览

- Scalar Unit:负责控制流、地址计算;

- Vector Unit:执行标量/向量运算(如 ReLU、Add、Transpose),支持 FP16/INT8 SIMD;

- Cube Unit:专用矩阵计算单元,一次可完成 16×16×16 的 FP16 矩阵乘加(MAC);

- Unified Buffer (UB):约 2MB 片上高速缓存,带宽高达 1TB/s+,远超 HBM(~1TB/s);

- MTE(Memory Transfer Engine):独立 DMA 引擎,支持与计算并行的数据搬运。

2.2 性能瓶颈:访存墙(Memory Wall)

昇腾芯片的峰值算力可达 256 TFLOPS(FP16),但若数据无法及时供给 Cube 单元,实际性能将大打折扣。因此,高效利用 UB、隐藏数据搬运延迟 成为 Ascend C 编程的核心挑战。

三、Ascend C 编程模型:三层抽象与流水线驱动

Ascend C 采用 “分块-搬运-计算-回写” 的四阶段模型,并通过 三层存储抽象 与 显式流水线控制 实现高性能。

3.1 三层存储抽象

| 层级 | 存储位置 | 容量 | 带宽 | 用途 |

|---|---|---|---|---|

| Global | HBM | GB 级 | ~1 TB/s | 存放完整输入/输出张量 |

| Local | UB | ~2 MB | >1 TB/s | 存放分块数据,供 Vector/Cube 计算 |

| Register | 寄存器 | KB 级 | 极高 | 编译器自动管理,开发者不可见 |

开发者需手动将 Global 数据分块搬入 Local(UB),在 Local 上执行计算,再写回 Global。

3.2 流水线编程模型(Pipeline Programming)

Ascend C 的核心创新在于 显式流水线 API,允许开发者声明多个 stage 并自动插入双缓冲:

// 定义三个阶段

auto stage1 = [](int block_id) { copy_in(ub_a, global_a, block_id); };

auto stage2 = [](int block_id) { matmul(ub_c, ub_a, ub_b); };

auto stage3 = [](int block_id) { copy_out(global_c, ub_c, block_id); };

// 构建流水线

pipeline pipe;

pipe.push_back(stage1);

pipe.push_back(stage2);

pipe.push_back(stage3);

// 执行(自动双缓冲)

pipe.run(block_count);编译器会生成如下执行序列:

Cycle 1: Stage1(Block0)

Cycle 2: Stage1(Block1) + Stage2(Block0)

Cycle 3: Stage1(Block2) + Stage2(Block1) + Stage3(Block0)

...从而 100% 隐藏数据搬运延迟。

四、核心编程接口详解

4.1 Tensor 描述与内存分配

// 全局张量(HBM)

auto global_input = global_tensor<float16>(input_ptr, shape{N, C, H, W});

// 本地张量(UB)

auto ub_tile = local_tensor<float16>(shape{16, 16}); // 对齐 Cube 单元⚠️ 注意:UB 分配总量不能超过 2MB,否则编译失败。

4.2 数据搬运原语

copy_in(local, global, offset, size):从 Global → UBcopy_out(global, local, offset, size):从 UB → Global- 支持 3D 地址偏移,适用于 NCHW 等布局。

4.3 计算原语(Compute Primitives)

Ascend C 提供高度优化的内置函数:

| 类型 | 函数示例 | 硬件单元 |

|---|---|---|

| 矩阵运算 | matmul(C, A, B, M, N, K) |

Cube |

| 逐元素运算 | add(C, A, B, size), relu(C, A, size) |

Vector |

| 规约操作 | reduce_sum(out, in, axis) |

Vector |

| 数据变换 | transpose(out, in, perm) |

Vector |

这些函数内部已实现向量化、循环展开与寄存器优化。

五、性能优化黄金法则

5.1 分块策略(Tiling Strategy)

- 通道维度:优先 16 对齐(Cube 单元要求);

- 空间维度:根据 UB 容量动态调整(如 16×16、32×8);

- 批处理维度:小 batch 时可跨 batch 分块提升复用率。

5.2 内存访问优化

- 地址对齐:所有指针需 32 字节对齐;

- 避免 bank conflict:UB 内存按 256-bit 分 bank,连续访问应跨 bank;

- 预取(Prefetch):在流水线中提前触发下一 block 的搬运。

5.3 计算强度最大化

- 尽可能将多个 element-wise 操作融合到一个 kernel 中;

- 利用

inplace操作减少 UB 占用; - 对小矩阵乘法,考虑 padding 至 16 的倍数以启用 Cube。

六、开发与调试工具链

- CANN Toolkit 8.0+:包含 Ascend C 编译器(

aoe)、链接器、调试器; - MindStudio IDE:提供语法高亮、断点调试、性能热点分析;

- msprof 性能分析器:可视化 UB 使用率、Cube 利用率、流水线气泡;

- AOE(Auto Optimize Engine):自动搜索最优分块参数。

七、案例:手写 LayerNorm 算子

LayerNorm 是 Transformer 的关键组件,涉及均值、方差、归一化三步。使用 Ascend C 可将其融合为单 kernel:

void custom_layernorm(...) {

// 分块处理 [batch, seq_len],每个 block 处理 1024 个 token

for (int i = 0; i < block_count; i++) {

copy_in(ub_x, global_x, i);

// Step 1: 计算均值

reduce_mean(ub_mean, ub_x, axis=1);

// Step 2: 计算方差

sub(ub_centered, ub_x, ub_mean);

square(ub_sq, ub_centered);

reduce_mean(ub_var, ub_sq, axis=1);

add(ub_var_eps, ub_var, eps);

rsqrt(ub_inv_std, ub_var_eps);

// Step 3: 归一化 + affine

mul(ub_norm, ub_centered, ub_inv_std);

mul(ub_scaled, ub_norm, ub_gamma);

add(ub_out, ub_scaled, ub_beta);

copy_out(global_y, ub_out, i);

}

}实测在 Ascend 910B 上,该实现比 MindSpore 内置 LayerNorm 快 18%。

结语:迈向国产 AI 基础软件的深水区

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)