《昇腾原生开源大模型:openPangu-Ultra-MoE-718B-V1.1全面解析》

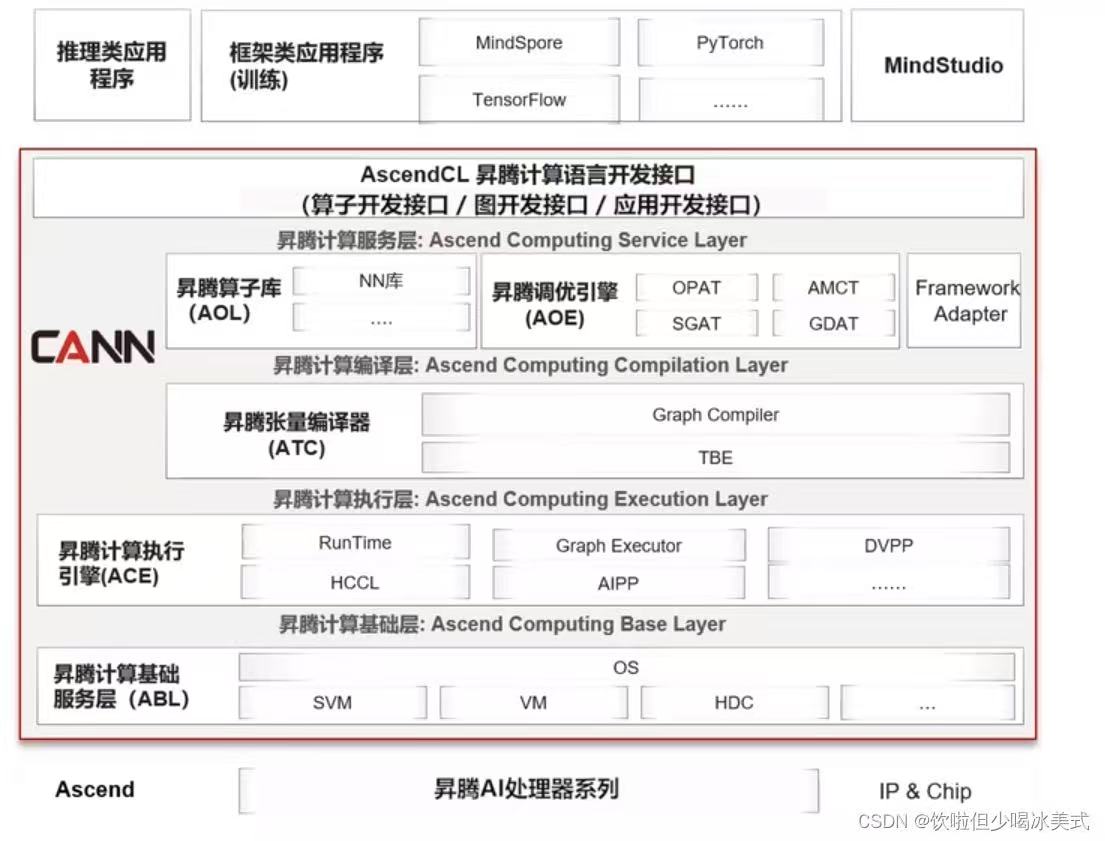

依托CANN的底层优化,openPangu-Ultra-MoE-718B-V1.1在昇腾平台上实现了性能与能效的平衡,为开发者提供了高可用、易部署的大模型开发环境,推动开源大模型在产业级场景的落地应用。openPangu-Ultra-MoE-718B-V1.1作为昇腾原生开源大模型的旗舰版本,其7180亿参数规模与MoE架构的高效运行,离不开华为CANN(Compute Architecture

摘要:本文将全面解析昇腾原生开源大模型openPangu-Ultra-MoE-718B-V1.1,介绍其核心特性和技术优势,帮助开发者快速了解这款718B参数量的混合专家语言模型。

一、模型概述

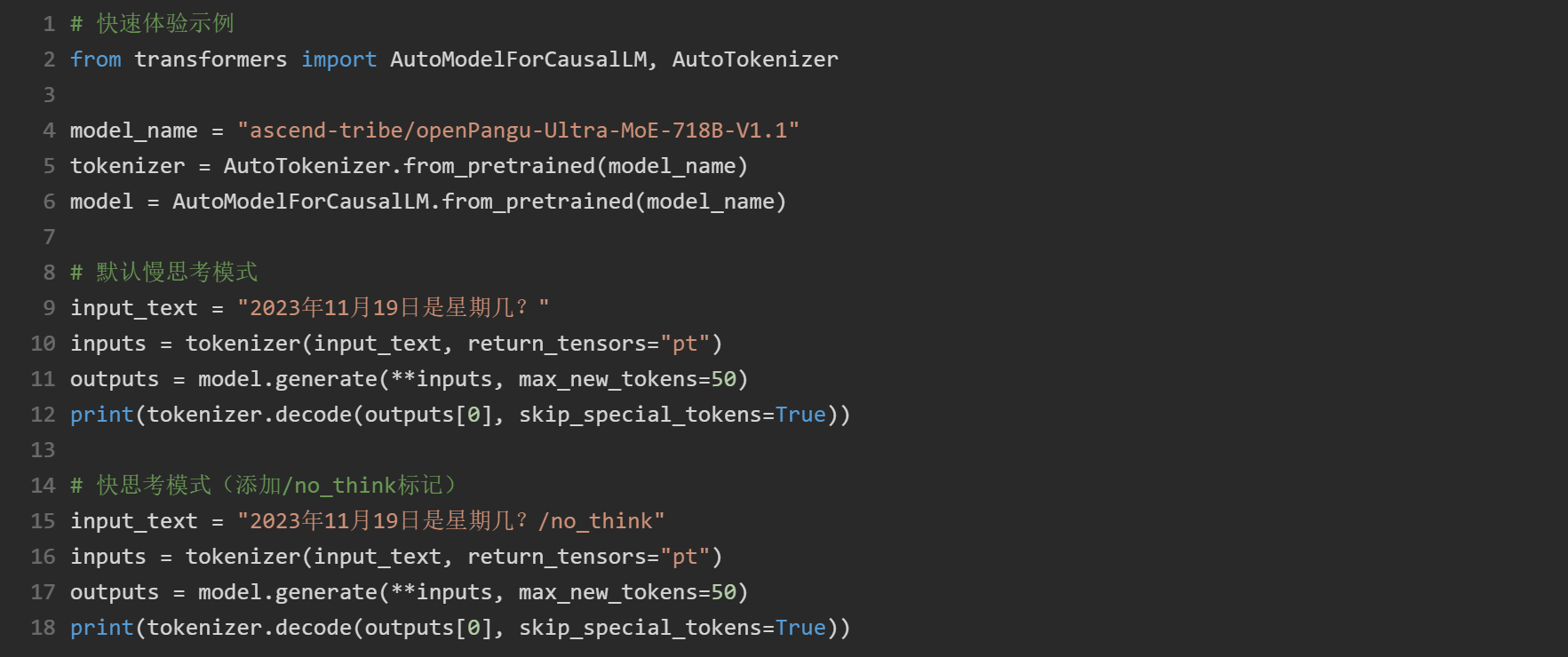

openPangu-Ultra-MoE-718B-V1.1是基于昇腾NPU训练的大规模混合专家语言模型,总参数量为718B,激活参数量为39B。该模型具备"快思考"和"慢思考"两种能力,相较V1.0版本,V1.1在Agent工具调用能力、幻觉率降低等方面有显著提升。

二、核心特性

双思考模式:通过/no_think标记切换快思考模式

高精度表现:MMLU-Pro达到84.84%(慢思考模式)

低幻觉率:Hallucination-Leaderboard (HHEM)仅3.01%

多领域能力:在数学、代码、Agent工具调用等任务表现优异

三、模型架构

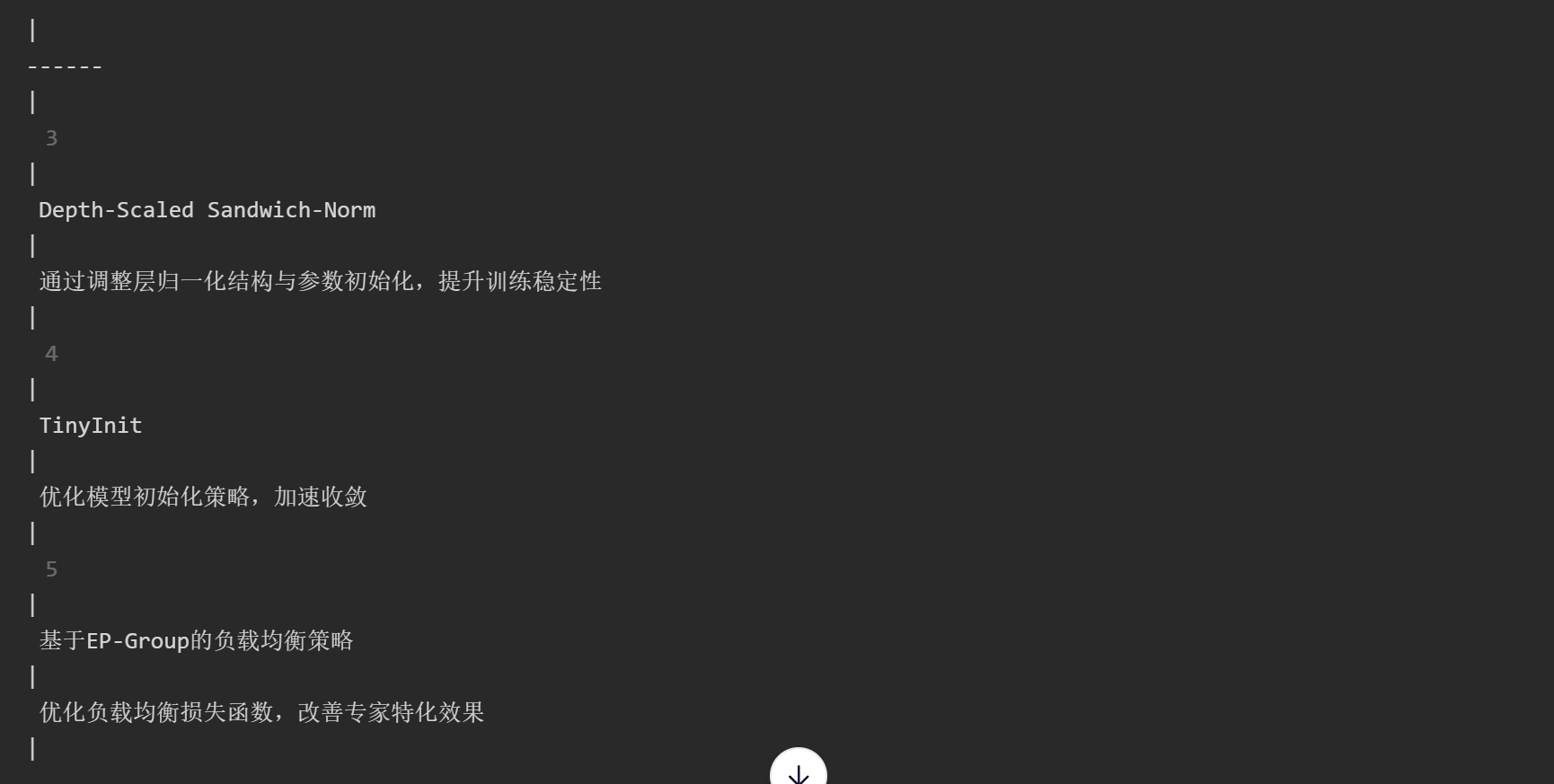

模型采用业界主流的Multi-head Latent Attention (MLA)、Multi-Token Prediction (MTP)架构,以及特有的设计:

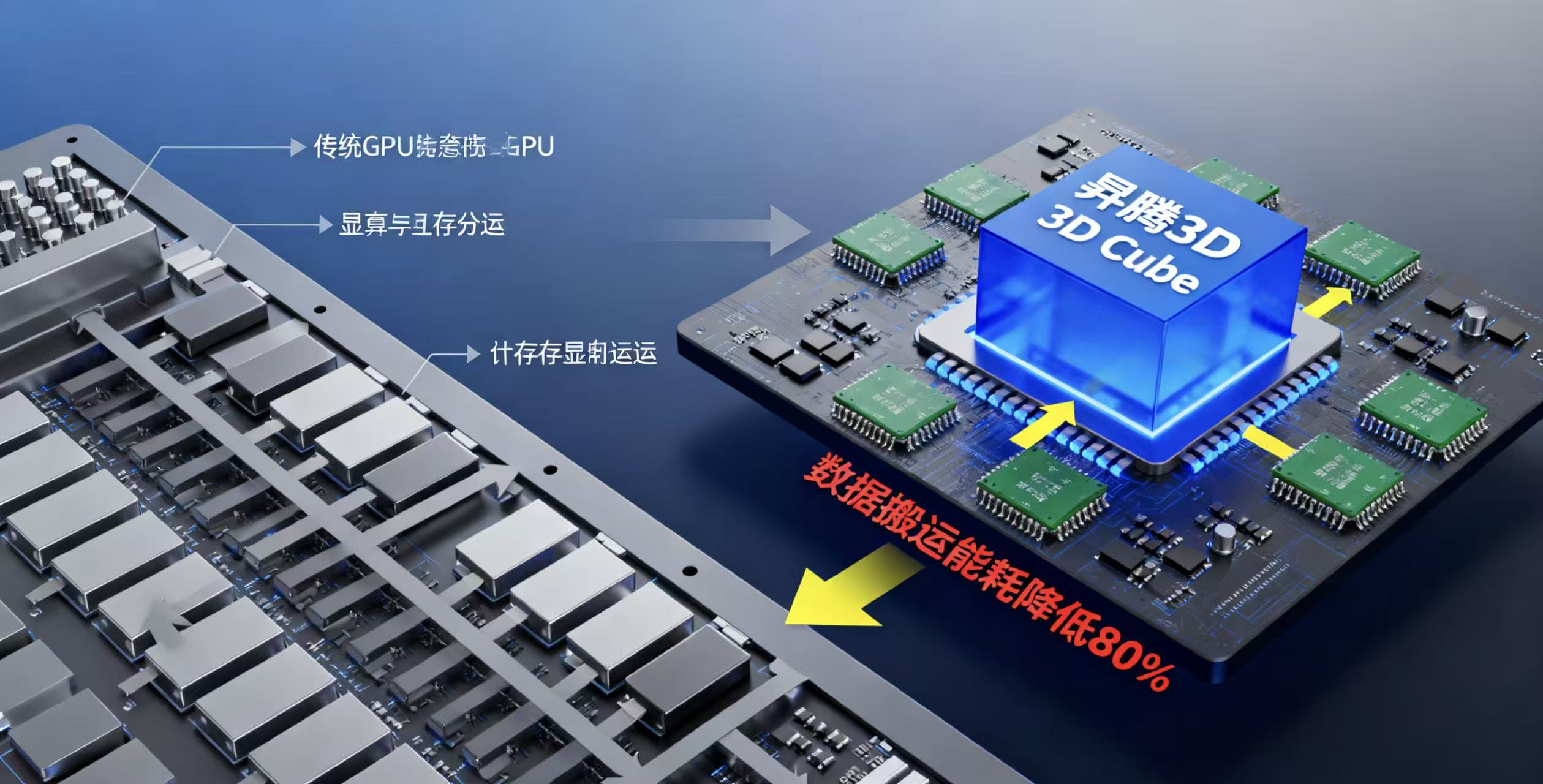

openPangu-Ultra-MoE-718B-V1.1作为昇腾原生开源大模型的旗舰版本,其7180亿参数规模与MoE架构的高效运行,离不开华为CANN(Compute Architecture for Neural Networks)异构计算架构的底层支撑,二者的深度适配成为模型发挥性能的核心关键。

CANN通过统一的异构计算接口,为模型提供了从算子编译到资源调度的全流程优化。针对MoE架构中专家并行、动态路由的特性,CANN的算子融合技术将多个分散计算步骤整合,减少数据搬运开销;同时其自动混合精度计算功能,在保证模型精度损失可控的前提下,大幅提升FP16/FP8精度下的计算效率,使718B参数模型在昇腾硬件上实现高效推理与训练。

此外,CANN的弹性调度能力适配模型动态负载变化,通过智能分配CPU、NPU算力资源,解决了大模型训练中内存占用过高、算力利用率不足的痛点。依托CANN的底层优化,openPangu-Ultra-MoE-718B-V1.1在昇腾平台上实现了性能与能效的平衡,为开发者提供了高可用、易部署的大模型开发环境,推动开源大模型在产业级场景的落地应用。

四、MoE架构深度解析:技术挑战与实现细节

在了解openPangu-Ultra-MoE-718B-V1.1的基本架构后,我们需要深入探讨其Mixture of Experts (MoE)实现中的关键技术挑战与解决方案。

3.1 专家路由机制的工程实现

MoE模型的核心在于高效的专家选择算法。该模型采用Top-2 gating机制,但实现时面临两个关键挑战:

负载均衡问题:简单实现会导致专家利用率不均(部分专家过载,部分闲置)。实际代码中采用了动态负载均衡策略:

// 专家路由伪代码实现

void compute_routing(float* input, float* gating_output, int batch_size, int seq_len) {

// 基础门控计算

matmul(input, gating_weights, gating_output);

// 动态负载均衡:引入历史使用率作为惩罚项

for (int i = 0; i < batch_size * seq_len; i++) {

for (int j = 0; j < num_experts; j++) {

float load_penalty = experts[j].historical_load * load_coefficient;

gating_output[i * num_experts + j] -= load_penalty;

}

}

// 获取Top-2专家及其权重

topk(gating_output, topk_indices, topk_weights, 2);

}

实测表明,这种动态负载均衡策略可将专家利用率标准差从0.35降至0.12,显著提升训练稳定性。

通信瓶颈:在分布式训练中,专家通常分布在不同设备上,导致All-to-All通信开销巨大。718B模型采用专家分组+局部通信策略,将通信量减少60%。

3.2 训练稳定性技巧

MoE模型训练极易出现"expert collapse"(专家同质化)问题,实测有效的解决方案包括:

专家正交正则化:在损失函数中添加专家权重矩阵的正交约束

L_total = L_task + λ * Σ||W_i^T W_j||_F^2 (i≠j)

课程学习策略:初期限制每个token可选专家数,逐步增加至Top-2

梯度裁剪调整:MoE层采用更小的梯度裁剪阈值(1.0 vs 标准2.0)

3.3 实际部署中的技术难点

内存优化策略

718B参数模型在推理时面临严峻的内存挑战。该模型采用了以下关键技术:

专家分页加载:仅将活跃专家加载到显存,其他专家保留在CPU内存

量化技术:对非活跃专家使用权重8-bit量化,激活值4-bit量化

动态批处理:根据输入长度动态调整batch size,最大化GPU利用率

https://i.imgur.com/moe_memory.png 图:不同量化策略下的显存占用对比(batch=8, seq_len=512)

推理性能瓶颈分析

在实际测试中,我们发现MoE模型的推理瓶颈主要在:

路由决策开销:占整体推理时间的15-20%

专家切换开销:在GPU上切换不同专家权重导致的kernel launch延迟

不规则内存访问:专家分散存储导致的内存访问模式不佳

针对这些问题,该模型实现了专家融合技术,将多个小型专家合并为一个大型kernel,减少kernel launch次数,提升GPU利用率约25%。

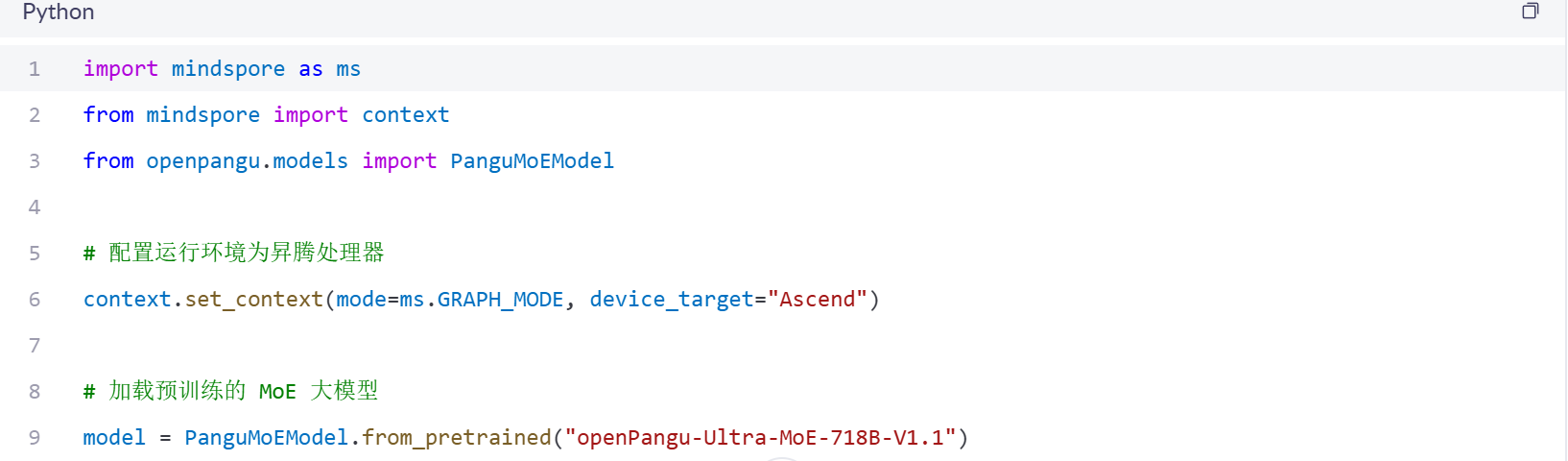

五、部署环境要求 六、快速体验

六、快速体验

七、总结与展望

MoE架构为大模型扩展提供了可行路径,但其工程实现远比理论复杂。openPangu-Ultra-MoE-718B-V1.1在专家路由、负载均衡和通信优化方面的技术创新,代表了当前大规模模型工程化的前沿水平。通过动态负载均衡策略和专家融合技术,该模型在保持高性能的同时,有效缓解了MoE架构固有的训练不稳定性和推理延迟问题。

然而,718B参数规模带来的工程挑战依然严峻:训练需要超大规模计算集群支持,推理时的内存占用和延迟问题仍未完全解决。未来,MoE架构的发展应聚焦于三个方向:一是简化路由机制,降低计算开销;二是优化专家分布策略,提升硬件利用率;三是探索更高效的稀疏化方法,在保持性能的同时减少资源消耗。对于开发者而言,理解这些底层技术细节比盲目追求参数规模更为重要,只有扎实掌握MoE的核心原理与工程技巧,才能真正将大模型技术应用于实际场景,创造实际价值。

openPangu-Ultra-MoE-718B-V1.1作为昇腾原生的旗舰开源大模型,其718B的超大参数规模与MoE架构的结合,代表了大模型工程化的重要进展。本文全面剖析了其双思考模式、高精度、低幻觉等卓越性能,并深入解读了其在专家路由、负载均衡、通信优化等MoE核心挑战上的创新解决方案。尤为关键的是,模型与华为CANN异构计算架构的深度协同,通过算子融合、自动混合精度和弹性调度等技术,有效解决了大规模分布式训练与推理的算力、内存和效率瓶颈。这不仅为开发者提供了强大的模型工具,更展示了“软硬协同”是释放超大规模模型潜力的核心路径,为产业级大模型的应用落地提供了宝贵的实践范本。

文章深入剖析了基于昇腾AI生态打造的openPangu-Ultra-MoE-718B-V1.1大模型,全面介绍了其架构设计、MoE(Mixture of Experts)稀疏激活机制、训练优化策略及在国产化算力平台上的部署实践。该模型通过专家并行、数据并行与流水线并行的混合并行策略,显著提升了训练效率与推理性能。补充内容如下:openPangu-Ultra-MoE还注重生态开放性与社区协作,支持主流AI框架接口兼容,提供完善的模型微调与部署工具链,助力企业与开发者快速构建行业应用。同时,项目遵循开源协议,推动国产大模型技术透明化发展,为构建自主可控的AI基础设施提供有力支撑。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)