算子开发实战:从 LeNet-5 拆解看 “算子怎么支撑模型

摘要:LeNet-5作为首个商用卷积神经网络,是算子开发的理想入门模型。其简洁的7层结构涵盖了Conv2D、MaxPool2D、MatMul等核心算子,完整呈现了数据转换流程。在昇腾NPU上实现时,需重点优化:1)利用TCU加速Conv2D计算;2)通过分布式并行提升MatMul效率;3)融合"Conv2D+ReLU"等连续算子减少内存访问;4)优化无参算子的硬件适配。该案例展

一、LeNet-5:算子开发的 “入门样板间”

在深度学习发展历程中,LeNet-5 作为首个落地商用的卷积神经网络,不仅奠定了现代 CNN 的基础架构,更成为算子开发入门的 “理想样板间”。这款诞生于 1998 年的模型,虽结构简洁(仅含 7 层可训练参数层),却精准覆盖了深度学习最核心的算子类型 —— 卷积(Conv2D)、池化(MaxPool2D)、矩阵乘法(MatMul)、展平(Flatten)、激活(ReLU)、Softmax 等,恰好对应异构计算中算子开发的核心知识点。

对算子开发者而言,LeNet-5 的价值在于 “复杂度适中、逻辑清晰”:既没有冗余模块干扰核心计算流程,又能完整呈现 “数据从输入到输出的算子调用链路”。将其拆解为算子组合后(如思维导图所示),每个层的计算本质都能对应到具体的算子实现,开发者可聚焦单个算子的优化逻辑,再逐步理解多算子协同的整体流程,大幅降低入门门槛。

二、从思维导图看 LeNet-5 的算子链路:数据如何被 “算子链” 转化

LeNet-5 的核心任务是手写数字识别(MNIST 数据集),输入为 28×28×1 的灰度图像,输出为 10 类数字的概率分布。整个推理过程,本质是一条 “算子调用链”,每一步都由特定算子完成数据转换:

1. 输入层 → 卷积层(Conv2D + ReLU)

- 核心算子:Conv2D 算子(核心计算)+ ReLU 算子(激活函数)

- 输入数据:28×28×1 的灰度图像(维度记为 [N, C_in, H_in, W_in] = [1, 1, 28, 28],N 为 batch size)

- 算子功能:Conv2D 算子通过 6 个 5×5×1 的卷积核,对输入图像进行局部特征提取,计算逻辑为 “互相关运算”—— 每个卷积核在图像上滑动,逐元素相乘后累加,输出 6 个特征图(维度 [1, 6, 28, 28]);ReLU 算子紧随其后,对卷积输出执行 “逐元素 max (0, x)” 操作,引入非线性,增强模型表达能力。

- 数据流转逻辑:输入图像 → Conv2D 算子(特征提取)→ ReLU 算子(非线性激活)→ 卷积层输出特征图。

2. 卷积层 → 池化层(MaxPool2D)

- 核心算子:MaxPool2D 算子

- 输入数据:卷积层输出的 6 个 28×28 特征图([1, 6, 28, 28])

- 算子功能:采用 2×2 的池化核、步长 2 的配置,对每个特征图进行空间维度下采样。核心逻辑是 “在池化窗口内取最大值”,既保留关键特征(最大值对应最显著的局部响应),又将特征图尺寸压缩为 14×14([1, 6, 14, 14]),减少后续计算量和过拟合风险。

- 关键特性:池化算子仅改变空间维度,不改变通道数,且计算过程无参数更新,属于 “无参算子”。

3. 池化层 → 全连接层(Flatten + MatMul + ReLU)

- 核心算子:Flatten 算子(维度转换)+ MatMul 算子(核心计算)+ ReLU 算子(激活)

- 输入数据:池化层输出的 6 个 14×14 特征图([1, 6, 14, 14])

- 算子协同逻辑:

-

- Flatten 算子:将 6×14×14 的三维特征图 “展平” 为一维向量,维度从 [1, 6, 14, 14] 转换为 [1, 1176](6×14×14=1176),适配全连接层的矩阵乘法输入格式;

-

- MatMul 算子:接收展平后的 1176 维向量,与全连接层的权重矩阵(维度 [1176, 120])执行矩阵乘法,输出 120 维特征向量([1, 120]);

-

- ReLU 算子:对 120 维向量执行非线性激活,进一步增强模型表达能力。

4. 全连接层 → 输出层(MatMul + Softmax)

- 核心算子:MatMul 算子(维度映射)+ Softmax 算子(概率归一化)

- 输入数据:前一层全连接层输出的 120 维向量([1, 120])

- 算子功能:

-

- MatMul 算子:将 120 维向量与权重矩阵([120, 10])相乘,映射为 10 维向量(对应 10 个数字类别);

-

- Softmax 算子:对 10 维向量进行概率归一化,使每个元素取值在 [0,1] 之间,且所有元素之和为 1,最终输出每个类别的预测概率(如 [0.01, 0.03, 0.92, ..., 0.005],对应数字 “2” 的概率最高)。

整个 LeNet-5 的推理过程,就是 “Conv2D→ReLU→MaxPool2D→Flatten→MatMul→ReLU→MatMul→Softmax” 的算子链执行过程,每个算子各司其职,完成数据的逐步转换,最终实现从图像像素到类别概率的映射。

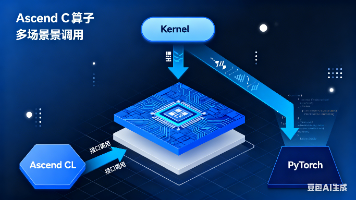

三、昇腾上实现 LeNet-5 的算子开发要点:适配硬件,优化性能

在昇腾 NPU 上开发 LeNet-5 对应的算子,核心是 “适配昇腾硬件架构” 和 “优化算子协同效率”,以下是关键要点和实战技巧:

1. Conv2D 算子:利用 TCU 算力,优化卷积计算

Conv2D 是 LeNet-5 中计算量最大的算子,其性能直接决定模型整体推理速度。在昇腾平台上,推荐使用 Ascend C 提供的 ascendc::conv2d 内置接口,核心优化思路如下:

- 硬件资源适配:昇腾 AI Core 中的 TCU(张量计算单元)专为卷积、矩阵乘等高密度计算设计,ascendc::conv2d 接口会自动将卷积计算映射到 TCU 执行,充分发挥硬件算力(单 TCU 算力可达 TFLOPS 级别);

- 参数精准配置:需明确指定卷积核大小(LeNet-5 中为 5×5)、步长(1)、填充(padding=2,保证输入输出空间维度一致)、输入输出通道数等参数,接口会根据参数自动优化计算逻辑:

// Ascend C Conv2D 算子调用示例

#include "ascendc/conv.h"

global void LeNetConv1Kernel(global const float* input, global const float* weights, global const float* biases, global float* output) { // 配置卷积参数:输入[1,1,28,28],输出[1,6,28,28],卷积核[6,1,5,5],步长[1,1],填充[2,2] ascendc::Conv2dParam conv_params; conv_params.in_shape = {1, 1, 28, 28}; conv_params.out_shape = {1, 6, 28, 28}; conv_params.kernel_shape = {6, 1, 5, 5}; conv_params.stride = {1, 1}; conv_params.padding = {2, 2};

// 调用内置 Conv2D 接口,自动适配 TCU 计算

ascendc::conv2d(input, weights, biases, output, conv_params);

}

- 数据类型优化:在精度允许的场景下,将输入数据和权重从 float32 改为 float16(半精度),可使 TCU 算力提升 2 倍,同时减少内存占用和数据传输开销,接口支持自动适配数据类型。

2. MatMul 算子:分布式并行,突破单卡算力限制

LeNet-5 的全连接层包含两次矩阵乘法(1176×120 和 120×10),虽然计算量小于卷积层,但通过分布式优化可进一步提升效率:

- 数据并行拆分:在多卡昇腾集群中,采用 “数据并行” 策略拆分全连接层的输入数据 —— 例如,将 batch size=128 的输入按卡数拆分(4 卡环境下每卡处理 32 个样本),每个卡独立执行 MatMul 计算,最后汇总结果;

- 接口优化调用:使用 Ascend C 的 ascendc::gemm 接口(矩阵乘专用),该接口已针对昇腾硬件做深度优化,支持自动调整并行粒度和内存访问模式:

// 全连接层矩阵乘法算子实现示例

#include "ascendc/blas.h"

__global__ void LeNetFC1Kernel(__global__ const float* input,

__global__ const float* weights,

__global__ const float* bias,

__global__ float* output) {

// 矩阵乘法参数说明:

// input[1,1176] × weights[1176,120] + bias[120] = output[1,120]

ascendc::GemmParam params;

params.trans_a = ascendc::Transpose::NoTrans; // 输入矩阵保持原样

params.trans_b = ascendc::Transpose::NoTrans; // 权重矩阵保持原样

params.m = 1; // 输入矩阵行数(批大小)

params.n = 120; // 输出特征维度

params.k = 1176; // 输入特征维度(等于权重矩阵行数)

// 调用优化后的GEMM接口,支持分布式计算

ascendc::gemm(1.0f, input, 1176, weights, 120, 0.0f, output, 120, params);

// 添加偏置项(自动广播)

__parallel_for(int i = 0; i < 120; ++i) {

output[i] += bias[i];

}

}

- 内存对齐优化:确保输入数据和权重矩阵的内存地址按 64 字节对齐(昇腾 NPU 内存访问的最优对齐方式),可减少内存访问延迟,ascendc::gemm 接口会自动检测并适配对齐格式。

3. 算子融合:减少数据搬运,提升端到端效率

LeNet-5 中 “Conv2D + ReLU”“MatMul + ReLU” 的连续调用场景,是算子融合的核心优化点。算子融合的本质是 “将多个连续算子的计算逻辑整合为一个复合算子”,避免中间结果的内存读写开销:

- 融合原理:以 “Conv2D + ReLU” 为例,原始流程是 “Conv2D 计算→中间结果写入全局内存→ReLU 从全局内存读取→激活计算→写入最终结果”,融合后流程简化为 “Conv2D 计算→ReLU 激活(直接在寄存器 / 局部内存中执行)→写入最终结果”,减少 2 次全局内存访问(全局内存是昇腾 NPU 中访问速度最慢的内存层级);

- Ascend C 实现方式:通过在 Conv2D 核函数中直接嵌入 ReLU 计算逻辑,实现算子融合:

// "Conv2D + ReLU" 融合算子实现示例

__global__ void LeNetConv1FusedKernel(__global__ const float* input,

__global__ const float* weights,

__global__ const float* bias,

__global__ float* output) {

// 1. 执行 Conv2D 卷积计算

ascendc::Conv2dParam conv_params;

conv_params.in_shape = {1, 1, 28, 28};

conv_params.out_shape = {1, 6, 28, 28};

conv_params.kernel_shape = {6, 1, 5, 5};

conv_params.stride = {1, 1};

conv_params.padding = {2, 2};

ascendc::conv2d(input, weights, bias, output, conv_params);

// 2. 就地执行 ReLU 激活

const int total_elements = 1 * 6 * 28 * 28;

__parallel_for(int i = 0; i < total_elements; ++i) {

output[i] = ascendc::max(output[i], 0.0f); // 内置 ReLU 实现

}

}

- 优化效果:LeNet-5 的卷积层融合后,端到端推理速度可提升 15%-25%,且融合算子的开发难度远低于单独优化两个算子,是 “低成本高回报” 的优化手段。

4. 无参算子(Flatten/MaxPool2D):简化实现,适配硬件流水线

LeNet-5 中的 Flatten 和 MaxPool2D 属于 “无参算子”(无训练权重),实现难度较低,但需适配昇腾硬件的流水线特性:

- Flatten 算子:本质是维度重排,无需计算,仅需调整数据的索引映射。在 Ascend C 中可通过指针偏移实现,避免数据拷贝:

// Flatten 算子实现(将[1,6,14,14]张量展平为[1,1176])

global void LeNetFlattenKernel(global const float* input, global float* output) { int idx = blockIdx.x * blockDim.x + threadIdx.x; const int total_elements = 1 * 6 * 14 * 14; // 1176个元素

if (idx < total_elements) {

// 将线性索引转换为三维坐标(c,h,w)

int channel = idx / (14 * 14);

int remaining = idx % (14 * 14);

int height = remaining / 14;

int width = remaining % 14;

// 直接通过指针偏移访问,避免数据拷贝

output[idx] = input[channel * 196 + height * 14 + width];

}

}

- MaxPool2D 算子:利用昇腾 VCU(向量计算单元)的并行能力,每个线程负责一个池化窗口的最大值计算,提升效率:

// 2×2 最大池化核函数(步长为2)

__global__ void LeNetMaxPoolKernel(__global__ const float* input, __global__ float* output) {

const int output_h = 14, output_w = 14;

// 获取当前线程处理的输出位置

int c = blockIdx.z; // 通道索引

int h = blockIdx.y * blockDim.y + threadIdx.y; // 高度索引

int w = blockIdx.x * blockDim.x + threadIdx.x; // 宽度索引

if (h < output_h && w < output_w) {

// 计算输入特征图的对应位置

int input_h = h * 2;

int input_w = w * 2;

// 在2×2窗口内计算最大值

float max_val = input[c * 28 * 28 + input_h * 28 + input_w];

max_val = ascendc::max(max_val, input[c * 28 * 28 + input_h * 28 + input_w + 1]);

max_val = ascendc::max(max_val, input[c * 28 * 28 + (input_h + 1) * 28 + input_w]);

max_val = ascendc::max(max_val, input[c * 28 * 28 + (input_h + 1) * 28 + input_w + 1]);

// 存储结果

output[c * output_h * output_w + h * output_w + w] = max_val;

}

}

四、总结:算子开发的核心逻辑 ——“模型需求→硬件适配→性能优化”

通过 LeNet-5 的算子拆解与昇腾平台实现,可总结出算子开发的核心逻辑:模型是 “需求方”,定义了算子的功能和调用链路;硬件是 “执行方”,决定了算子的实现方式和优化方向;而算子开发者的核心任务,就是搭建 “模型需求” 与 “硬件能力” 之间的桥梁。

对新手而言,LeNet-5 的价值在于 “化繁为简”—— 它让开发者看清:复杂模型的本质是简单算子的组合,掌握每个核心算子的实现逻辑(如 Conv2D 的 TCU 适配、MatMul 的并行拆分、算子融合的内存优化)后,再迁移到更复杂的模型(如 ResNet、Transformer)时,只需复用核心思路并扩展适配即可。

后续可进一步探索的方向:LeNet-5 算子的量化实现(INT8 低精度优化)、动态 Shape 适配(支持不同 batch size 和输入尺寸)、多算子流水线并行等,逐步深化对昇腾算子开发的理解。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:

https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)