昇腾技术体系

医疗场景中,诊断设备常需在基层医疗机构部署,无法依赖云端算力,昇腾边缘模块提供的本地化算力,解决了医疗数据传输延迟、隐私保护等问题,技术适配的是“基层医疗的实际部署环境”,而非单纯追求算力指标。这里的核心是昇腾硬件与交通模型的协同优化,让技术能够匹配交通场景“高并发、低时延”的核心诉求,而非硬件性能的绝对领先。其核心逻辑是“技术组件适配场景需求”,而非技术主导场景,例如边缘算力适配医疗设备的移动化

AI生态的协作与实践:昇腾技术体系的客观观察

前言

人工智能技术的规模化落地,本质是“技术工具-开发实践-行业需求”的三方协同。在众多AI技术体系中,昇腾以硬件为基础、软件为纽带、开源社区为支撑,构建了一套覆盖从模型开发到场景落地的完整技术链路。它并非孤立的技术产品,而是通过兼容第三方框架、开放开发工具、联动行业伙伴,形成了“工具赋能-实践验证-生态共建”的良性循环。本文将跳出宣传视角,聚焦其技术协同逻辑、实操开发案例、行业落地路径与开源协作模式,为从业者呈现一个基于实际应用场景的技术体系观察。

一、技术体系的协同逻辑:从硬件到场景的链路搭建

昇腾技术体系的核心竞争力,在于各组件间的协同适配,而非单一环节的性能标签。其整体逻辑可概括为“底层支撑-中层适配-上层落地”的三级联动:

底层硬件支撑

以昇腾AI处理器为核心,形成多元化硬件矩阵:从边缘端的模块、加速卡,到云端的服务器、集群,再到针对大规模训练的昇腾384超节点,覆盖不同场景的算力需求。其中,384超节点通过对通信、访存、并行策略的优化,适配商汤大装置等大规模训练平台,解决超大模型训练中的算力调度难题,这一适配并非单纯的硬件堆砌,而是基于场景需求的协同优化。

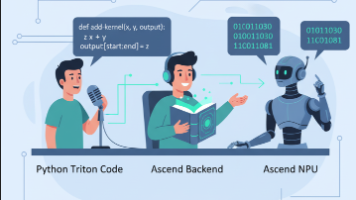

中层软件与工具适配

- 异构计算架构CANN:作为中间件,其核心价值在于实现“硬件算力-上层应用”的平滑衔接,支持动态Shape图调度、算子矩阵化实现等技术,其中插值类算子通过矩阵化优化实现性能提升,本质是通过软件逻辑挖掘硬件潜力,而非硬件本身的性能跃升。

- 框架兼容与应用使能:原生支持MindSpore框架,同时兼容TensorFlow、PyTorch、飞桨等第三方框架,降低开发者的技术迁移成本;MindX系列工具包(MindX DL、MindX Edge等)与ModelZoo预训练模型库,为应用开发提供标准化组件,减少重复开发工作。

- 开发工具链:MindStudio集成算子调试、模型量化、性能分析等功能,其算子精度调试工具解决了开发中的实际痛点,让技术落地过程更高效,这一价值源于对开发者实际需求的响应,而非工具本身的功能堆砌。

上层场景落地衔接

通过与行业伙伴的协作,将标准化技术组件转化为场景化解决方案。其核心逻辑是“技术组件适配场景需求”,而非技术主导场景,例如边缘算力适配医疗设备的移动化需求、超节点算力适配大模型的训练需求,形成“需求牵引技术,技术支撑需求”的闭环。

二、核心开发实践:基于实际场景的代码示例

示例1:CANN动态Shape图调度实现(适配复杂AI任务)

CANN接口实现动态Shape适配的核心代码:

c

#include “acl/acl.h”

#include “acl/acl_graph.h”

#include

#include

int main() {

// 1. 初始化ACL环境

aclError ret = aclInit(nullptr);

if (ret != ACL_SUCCESS) {

std::cerr << "ACL init failed, error code: " << ret << std::endl;

return -1;

}

// 2. 加载动态Shape模型(假设模型已通过MindStudio编译生成)

const char* model_path = "dynamic_shape_model.om";

uint32_t model_id;

ret = aclmdlLoadFromFile(model_path, &model_id);

if (ret != ACL_SUCCESS) {

std::cerr << "Load dynamic shape model failed" << std::endl;

aclFinalize();

return -1;

}

// 3. 配置动态输入Shape(模拟多模态任务中不同尺寸的输入)

std::vector<int64_t> input_dims1 = {1, 3, 256, 256}; // 输入尺寸1

std::vector<int64_t> input_dims2 = {1, 3, 512, 512}; // 输入尺寸2

aclmdlIODims input_dims;

input_dims.num_dims = input_dims1.size();

// 4. 申请输入输出内存(动态调整内存大小)

void* input_buf1 = nullptr;

void* input_buf2 = nullptr;

size_t input_size1 = 1 * 3 * 256 * 256 * sizeof(float);

size_t input_size2 = 1 * 3 * 512 * 512 * sizeof(float);

ret = aclrtMalloc(&input_buf1, input_size1, ACL_MEM_MALLOC_NORMAL_ONLY);

ret |= aclrtMalloc(&input_buf2, input_size2, ACL_MEM_MALLOC_NORMAL_ONLY);

if (ret != ACL_SUCCESS) {

std::cerr << "Malloc input buffer failed" << std::endl;

// 资源释放逻辑省略

return -1;

}

// 5. 执行模型推理(适配不同输入尺寸)

aclmdlDataset* input_dataset = aclmdlCreateDataset();

aclDataBuffer* input_buffer1 = aclCreateDataBuffer(input_buf1, input_size1);

aclmdlAddDatasetBuffer(input_dataset, input_buffer1);

input_dims.dims = input_dims1.data();

ret = aclmdlSetInputDims(model_id, 0, &input_dims); // 设置输入尺寸1

ret |= aclmdlExecute(model_id, input_dataset, nullptr);

std::cout << "Dynamic shape inference with size 256x256 completed" << std::endl;

// 切换输入尺寸2

aclmdlResetDataset(input_dataset);

aclDataBuffer* input_buffer2 = aclCreateDataBuffer(input_buf2, input_size2);

aclmdlAddDatasetBuffer(input_dataset, input_buffer2);

input_dims.dims = input_dims2.data();

ret = aclmdlSetInputDims(model_id, 0, &input_dims); // 设置输入尺寸2

ret |= aclmdlExecute(model_id, input_dataset, nullptr);

std::cout << "Dynamic shape inference with size 512x512 completed" << std::endl;

// 6. 资源释放

aclDestroyDataBuffer(input_buffer1);

aclDestroyDataBuffer(input_buffer2);

aclmdlDestroyDataset(input_dataset);

aclrtFree(input_buf1);

aclrtFree(input_buf2);

aclmdlUnload(model_id);

aclFinalize();

return 0;

}

代码说明:该示例基于CANN动态Shape调度技术,通过 aclmdlSetInputDims 接口动态调整输入尺寸,适配多模态模型等复杂任务的需求,核心逻辑是通过软件接口实现硬件算力的灵活调度,而非依赖硬件的特殊性能。

三、场景化落地:技术与需求的协作逻辑

昇腾技术体系的行业落地,核心是“技术组件适配场景痛点”,而非技术的单向输出。以下从三个典型场景,分析其落地逻辑:

医疗领域:边缘算力的场景适配

斯贝达与昇腾的协作,聚焦医疗设备“移动化、低时延”的需求。医疗场景中,诊断设备常需在基层医疗机构部署,无法依赖云端算力,昇腾边缘模块提供的本地化算力,解决了医疗数据传输延迟、隐私保护等问题,技术适配的是“基层医疗的实际部署环境”,而非单纯追求算力指标。

交通领域:实时数据的处理效率

海信网络科技的“云信·通途”大模型,针对交通场景中“实时车流分析、信控动态调整”的需求,借助昇腾算力实现数据的毫秒级处理。这里的核心是昇腾硬件与交通模型的协同优化,让技术能够匹配交通场景“高并发、低时延”的核心诉求,而非硬件性能的绝对领先。

司法领域:流程优化的工具支撑

图灵微雀的司法AI一体机,利用昇腾技术实现案件卷宗分析、类案检索等功能,解决司法工作中“重复性劳动多、效率低”的痛点。技术的价值在于将标准化的AI工具与司法流程结合,优化工作流程,而非替代人工决策,体现了技术作为“辅助工具”的本质定位。

四、开源协作:生态共建的核心逻辑

昇腾生态的可持续性,源于其“开源开放、协作共建”的模式,而非单一主体的技术输出:

开源项目的技术共享

CANN架构全面开源,支持开发者参与算子创新与工具优化,例如插值类算子的矩阵化实现,便是社区协作优化的成果;XTuner V1超大模型训练引擎开源,适配昇腾384超节点,降低了大规模训练的技术门槛,让更多开发者能够参与大模型训练技术的迭代。

开发者社区的能力共建

通过CANN训练营、算子开源周Meetup等活动,搭建开发者交流平台,聚焦“0基础入门、实操技巧赋能”,而非单纯的活动宣传;“昇腾AI金种子全国行”等线下活动,将技术资源下沉至不同区域,促进区域间的技术交流;AI开源实习生招募覆盖6大领域、10大方向,为生态注入新鲜血液,形成“学习-实践-贡献”的人才闭环。

学习资源的普惠性

提供70余门在线课程与统一知识体系,覆盖算子开发、模型部署等全场景,搭配案例库与权威文档,降低技术学习的门槛。这些资源的核心价值在于“标准化、可及性”,让不同基础的开发者都能找到对应的学习路径,而非资源的“稀缺性”。

结尾

AI生态的本质,是“技术工具的普惠性、开发实践的可操作性、行业需求的适配性”三者的统一。昇腾技术体系的价值,不在于其单一组件的性能标签,而在于构建了一套“硬件-软件-工具-社区”的协同框架,让技术能够以标准化的方式适配不同场景、连接不同主体。

从开发角度,它提供了兼容主流框架的工具链,降低了技术迁移成本;从行业角度,它通过与伙伴的协作,让AI技术能够真正解决实际痛点;从生态角度,它以开源开放的模式,让更多开发者参与技术迭代。未来,AI生态的竞争,终将回归到“是否能高效解决问题、是否能促进协作共建”的核心本质,而昇腾生态的探索,也为行业提供了一个“以协作驱动技术落地”的参考样本。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)