深度解读 ascend-host-runtime:揭秘算力资源自动发现的底层逻辑

的自动设备发现机制是昇腾计算平台“开箱即用”体验的核心保障。高度抽象:屏蔽了复杂的 PCIe 拓扑和底层驱动调用细节。鲁棒性:结合健康检查机制,确保只有就绪的硬件参与计算。标准化:为上层框架(如 MindSpore 或 PyTorch)提供了统一的逻辑设备视图。对于希望深入了解昇腾算力底层的开发者,建议深入研读CANN 组织下的这一开源仓库。理解了设备发现,就掌握了开启昇腾高效计算大门的钥匙。本文

深度解读 ascend-host-runtime:揭秘算力资源自动发现的底层逻辑

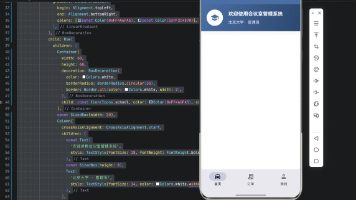

在华为(Ascend)计算产业生态中,CANN(Compute Architecture for Neural Networks)作为衔接上层深度学习框架与底层硬件算力的核心枢纽,其稳定性和高效性至关重要。作为 CANN 组织 开源生态中的关键组件,ascend-host-runtime 承担了主机侧运行时环境的管理重任。

本文将深入探讨 ascend-host-runtime 在启动阶段如何实现“自动设备发现(Automatic Device Discovery)”,并从源码逻辑角度分析其底层实现原理。

一、 自动设备发现的背景与意义

在异构计算场景下,一台服务器可能挂载多张加速卡(如 Atlas 300I Duo 或 Atlas 300V Pro)。对于开发者而言,手动配置设备 ID 既繁琐又易错。ascend-host-runtime 的自动设备发现机制,旨在通过标准化的接口,在运行时动态感知系统中的 NPU 资源,完成硬件抽象层(HAL)与逻辑设备 ID 的映射,为后续的算子下发和内存管理打下基础。

二、 核心架构设计

在 ascend-host-runtime 仓库中,设备发现逻辑主要围绕 Device Manager 模块展开。其核心链路可以概括为:驱动探测 -> 总线扫描 -> 资源枚举 -> 逻辑初始化。

1. 驱动层接口调用(DRV 层)

Runtime 并不直接操作 PCIe 总线,而是通过调用驱动(Driver)提供的 drv 接口。在初始化阶段,Runtime 会加载 libdrv_xxx.so 动态库。

代码逻辑通常从 DevMgrInit 函数开始,该函数会触发对内核态驱动状态的轮询。

2. 枚举流程解析

在源码的 core/device 目录下,我们可以看到设备管理的实现细节。自动发现的关键步骤如下:

- 获取总设备数:Runtime 首先调用

drvGetDeviceCount获取当前系统可见的物理 NPU 数量。 - 物理信息采集:针对每一个探测到的设备,Runtime 会获取其

Module ID、PCIe Bus ID以及Device Type。这些信息是区分不同硬件型号(如 910B 与 310P)的关键。 - 健康状态检查:自动发现不仅是“看到”设备,还要“确认可用”。Runtime 会读取心跳寄存器或通过驱动反馈的

HealthStatus过滤掉处于异常状态的卡。

三、 深度代码逻辑实现

1. 设备发现的切入点

在 ascend-host-runtime 的初始化逻辑中,DeviceDiscovery 类负责维护一个全局的设备列表。

// 伪代码示例:设备扫描逻辑

Status DeviceDiscovery::ScanDevices() {

uint32_t devCount = 0;

// 从驱动层获取物理设备总数

ret = drvGetDeviceCount(&devCount);

for (uint32_t i = 0; i < devCount; ++i) {

DeviceInternalInfo info;

// 获取物理设备的详细拓扑结构

ret = drvGetDeviceInfo(i, &info);

if (IsDeviceAvailable(info)) {

// 将物理设备映射为 Runtime 内部管理的逻辑对象

RegisterDevice(i, info);

}

}

return SUCCESS;

}

2. 逻辑 ID 与物理 ID 的解耦

ascend-host-runtime 引入了一层映射机制。用户在应用层看到的 device_id: 0,在底层可能对应的是物理 PCIe 槽位上的 device_id: 4。

这种映射关系在 DeviceManager::MapLogicalToPhysical 中实现。自动发现逻辑会自动处理这种映射,确保即使在多卡并行环境下,用户也能通过连续的逻辑 ID 访问硬件,极大降低了分布式训练时的配置难度。

3. 热插拔与动态感知预留

虽然目前的 AI 训练环境多为静态配置,但在 ascend-host-runtime 的架构设计中,通过 EventMonitor 机制预留了对设备状态变更的监听。当驱动层检测到硬件复位或链路中断时,Runtime 的设备管理模块能够捕获信号并更新内部的设备可用性表,防止无效的任务下发导致系统崩溃。

四、 总结

ascend-host-runtime 的自动设备发现机制是计算平台“开箱即用”体验的核心保障。它通过以下三点实现了高效的资源管理:

- 高度抽象:屏蔽了复杂的 PCIe 拓扑和底层驱动调用细节。

- 鲁棒性:结合健康检查机制,确保只有就绪的硬件参与计算。

- 标准化:为上层框架(如 MindSpore 或 PyTorch)提供了统一的逻辑设备视图。

对于希望深入了解算力底层的开发者,建议深入研读 CANN 组织 下的这一开源仓库。理解了设备发现,就掌握了开启高效计算大门的钥匙。

更多推荐

已为社区贡献38条内容

已为社区贡献38条内容

所有评论(0)