深入CANN算子仓库:ops-nn如何加速神经网络计算

在AIGC时代,算法创新与系统优化同等重要。CANN的ops-nn算子库为我们提供了一个将深度学习计算映射到昇腾硬件的强大平台。通过理解TIK/Ascend C的开发范式,掌握数据搬运、内存管理和流水线并行等核心技术,我们才能不仅仅是“使用”算子,更能“优化”和“创造”算子,从而为AIGC应用注入极致性能。进一步探索:你可以从实现一个简单的自定义算子(如带特殊填充的卷积或一种新型的激活函数)开始你

cann组织链接:https://atomgit.com/cann

ops-nn仓库链接:https://atomgit.com/cann/ops-nn

在AIGC(生成式AI)时代,模型性能的优化不再仅限于算法设计,更深入到计算算子与硬件架构的融合层面。华为昇腾CANN(Compute Architecture for Neural Networks)架构下的ops-nn仓库,正是实现这种深度优化的关键所在。它不仅是一个神经网络计算算子库,更是连接上层AI框架与底层昇腾AI处理器的桥梁。

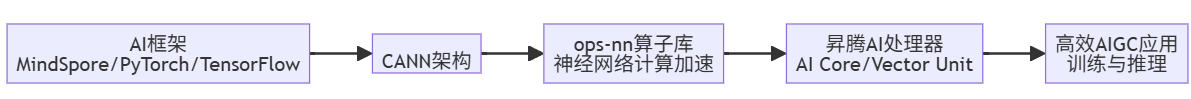

一、CANN与ops-nn:算力底座的承上启下者

CANN是华为针对AI场景推出的异构计算架构,对上支持多种AI框架,对下服务AI处理器与编程,发挥承上启下的关键作用。而ops-nn仓库是CANN子库中提供神经网络计算能力的高阶算子库,其设计遵循三大核心原则:

- 高性能优先:每个算子都经过NPU架构专家深度优化,充分释放昇腾硬件算力。

- 多场景适配:覆盖了卷积、矩阵运算、激活函数等常见的神经网络计算场景。

- 持续演进:随着CANN和昇腾硬件的迭代,ops-nn不断新增和优化算子,以支持最新的网络结构和算法。

下图展示了CANN中ops-nn算子库在整个昇腾AI软件栈中的位置与作用:

二、ops-nn算子库的核心价值与设计哲学

ops-nn的价值远不止于提供可调用的算子接口。它代表了一种将算法逻辑映射到硬件指令的深度工程实践,其设计哲学体现在:

- 深度硬件亲和:算子实现并非简单的软件模拟,而是紧密围绕昇腾AI Core的向量计算单元和矩阵计算单元进行优化。例如,充分利用SIMD(单指令多数据)特性,一条指令可处理多个数据。

- 多算子协同优化:ops-nn中的算子并非孤立存在。CANN的图融合(Auto Fuse) 技术能将多个连续算子(如Conv+BN+Relu)融合为一个核函数执行,大幅减少访存开销,提升整体计算效率。

- 开放与共建生态:ops-nn并非封闭的黑盒。CANN开源社区(包括Gitee上的cann-ops仓库)鼓励开发者学习、使用和贡献算子代码。这意味着你可以根据自己AIGC模型的特殊需求,基于ops-nn的范式开发自定义算子。

三、技术深挖:TIK算子开发的核心流程与实战

要深入理解ops-nn,就必须了解其算子开发的底层范式——TIK (Tensor Iterator Kernel)。TIK是算子开发者最常用也最核心的底层编程模型之一,它构建在TBE(Tensor Boost Engine)之上,通过一套接近硬件执行模型的Python DSL,让开发者可以直接操控Unified Buffer、L1 Buffer、AI Core指令等底层资源。

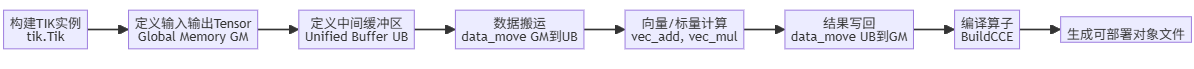

1. TIK开发的核心流程

一个典型的TIK算子Python程序开发流程如下图所示,它清晰地展示了从数据定义到编译输出的关键步骤:

2. 实战代码:一个简单的加法算子

以下是一个使用TIK API实现的简单加法算子代码片段,它展示了如何将两个张量在NPU上高效相加:

# 导入依赖的Python模块

from tbe import tik

import tbe.common.platform as tbe_platform

from tbe.common.utils import para_check

# 算子定义入口函数

@para_check.check_input_type(dict, dict, dict, str)

def my_add(input_x, input_y, output_z, kernel_name):

# 1. 设置目标硬件环境,指定昇腾AI处理器型号

soc_version = "Ascend310P3"

tbe_platform.set_current_compile_soc_info(soc_version)

# 2. 构建TIK DSL容器

tik_instance = tik.Tik(disable_debug=False)

# 3. 定义输入输出Tensor(Global Memory, GM)

data_x = tik_instance.Tensor("float16", (1024,), scope=tik.scope_gm, name="data_x")

data_y = tik_instance.Tensor("float16", (1024,), scope=tik.scope_gm, name="data_y")

data_z = tik_instance.Tensor("float16", (1024,), scope=tik.scope_gm, name="data_z")

# 4. 定义中间缓冲区(Unified Buffer, UB)

data_ub = tik_instance.Tensor("float16", (1024,), scope=tik.scope_ubuf, name="data_ub")

# 5. 数据搬运:GM → UB

# 从GM连续搬运1024B(32 blocks)到UB

tik_instance.data_move(data_ub, data_x, 0, 1, 32, 0, 0)

# 将data_y也搬运到data_ub的同一位置(加法在原地完成)

tik_instance.data_move(data_ub, data_y, 0, 1, 32, 0, 0)

# 6. 调用向量计算指令

# 每个向量指令可以处理128个float16元素(256B)

# 1024个float16元素 = 2048B = 8 * 256B

tik_instance.vec_add(128, data_ub, data_ub, data_ub, 8, 8, 8)

# 7. 结果写回:UB → GM

tik_instance.data_move(data_z, data_ub, 0, 1, 32, 0, 0)

# 8. 编译算子

tik_instance.BuildCCE(kernel_name="my_add", inputs=[data_x, data_y], outputs=[data_z])3. 关键技术点解析:数据搬运与内存模型

在TIK编程中,数据搬运(data_move)是性能优化的关键,也是最容易出错的环节。其核心函数原型为:

data_move(dst, src, sid, nburst, burst, src_stride, dst_stride)|

参数 |

含义 |

常见场景 |

|

|

搬运次数(段数) |

分块搬运,每次处理一大块数据 |

|

|

每段搬运的长度(单位:32B的block) |

决定单次搬运的数据量 |

|

|

源数据段之间的间隔block数 |

处理非连续数据(如按列取数据) |

|

|

目的数据段之间的间隔block数 |

写入时进行数据重排 |

例如,处理多batch数据按行存储但需要按列操作的场景时,就需要使用非零的stride值:

# 假设GM中数据按行连续存储,但我们需要按列读取到UB

# 每次搬4 blocks(128B),每段之间间隔4 blocks,目的端间隔2 blocks

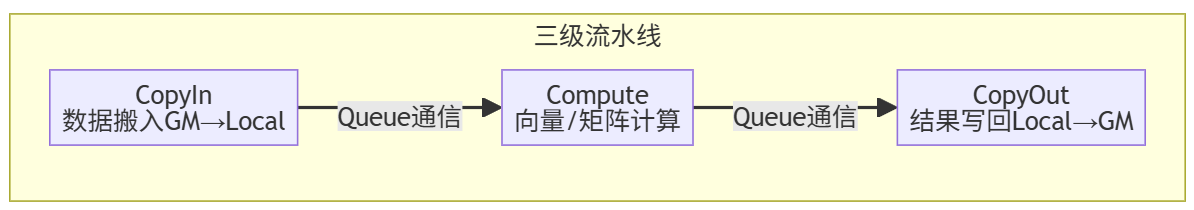

tik_instance.data_move(data_input_ub, data_input_gm, 0, 4, 4, 4, 2)昇腾AI Core的存储层次结构(GM -> UB -> Vector Unit)对性能影响巨大。数据必须在UB(Unified Buffer)中才能进行向量计算。因此,合理的分块(Tiling)策略、复用UB空间、以及采用流水线并行(将CopyIn, Compute, CopyOut流水线化)是提升算子性能的三大法宝。

四、超越TIK:Ascend C——面向未来的算子开发语言

随着CANN的演进,Ascend C作为下一代算子开发语言应运而生。它原生支持C和C++标准规范,通过多层接口抽象、自动并行计算、孪生调试等关键技术,极大提高了算子开发效率。

1. Ascend C的优势与核心概念

|

特性 |

TIK |

Ascend C |

|

编程语言 |

Python DSL |

C/C++ |

|

开发效率 |

中等 |

高(贴近标准C++,有大量类库和API) |

|

性能潜力 |

极高(直接操作硬件) |

极高(编译器自动优化,同时提供低阶API) |

|

调试体验 |

较难(需在硬件上调试) |

优(支持CPU孪生调试,模拟NPU行为) |

|

适用场景 |

需要极致性能控制的算子开发 |

通用高性能算子开发,更易用高效 |

2. Ascend C算子开发核心:核函数与流水线

Ascend C算子的核心是核函数(Kernel Function),它使用特殊的限定符__global__和__aicore__来标识。其开发范式强调流水线并行,将算子的执行分解为三个阶段:

以下是一个非常简化的Ascend C核函数框架示例,展示了如何组织流水线:

#include "kernel_operator.h"

extern "C" __global__ __aicore__ void my_add_ascend_c(__gm__ uint8_t* x, __gm__ uint8_t* y, __gm__ uint8_t* z, uint32_t size) {

// 1. 初始化:获取核ID,配置流水线

uint32_t core_id = GetBlockIdx();

TPipe pipe;

pipe.InitBuffer(inQueueX, BUFFER_NUM, TILE_SIZE * sizeof(float16));

pipe.InitBuffer(inQueueY, BUFFER_NUM, TILE_SIZE * sizeof(float16));

pipe.InitBuffer(outQueueZ, BUFFER_NUM, TILE_SIZE * sizeof(float16));

// 2. 主循环:分块处理

for (uint32_t i = 0; i < total_tiles; i++) {

// CopyIn阶段:数据从GM搬入Local Memory

LocalTensor<float16> xLocal = inQueueX.AllocTensor<float16>();

LocalTensor<float16> yLocal = inQueueY.AllocTensor<float16>();

DataCopy(xLocal, xGlobal[i * TILE_SIZE], TILE_SIZE); // 模拟GM->Local

DataCopy(yLocal, yGlobal[i * TILE_SIZE], TILE_SIZE);

inQueueX.EnQue(xLocal);

inQueueY.EnQue(yLocal);

// Compute阶段:进行向量计算

LocalTensor<float16> zLocal = outQueueZ.AllocTensor<float16>();

Add(zLocal, xLocal, yLocal, TILE_SIZE); // 假设提供了向量加法API

outQueueZ.EnQue(zLocal);

// CopyOut阶段:结果从Local写回GM

LocalTensor<float16> outLocal = outQueueZ.DeQue<float16>();

DataCopy(zGlobal[i * TILE_SIZE], outLocal, TILE_SIZE); // 模拟Local->GM

outQueueZ.FreeTensor(outLocal);

}

}五、面向AIGC的应用:ops-nn如何赋能生成式模型

在AIGC领域,模型训练和推理对算力、显存和计算效率的要求极高。ops-nn的优化算子直接体现在以下几个方面:

- 加速关键计算算子:AIGC模型中大量的矩阵乘法(GEMM)、卷积(Conv)、激活函数(如ReLU, GELU)、归一化(LayerNorm) 等算子,都是ops-nn优化的重点。高效的算子实现直接转化为模型训练和推理的加速。

- 支持新的数据格式与精度:为了应对显存瓶颈和提升计算吞吐,AIGC模型常采用混合精度训练(如FP16/BF16) 和各种量化技术。ops-nn提供了对应精度(如int8, float16)的算子实现,并针对不同精度进行了极致优化。

- 算子融合提升吞吐:对于生成式推理,延迟是关键指标。CANN的图融合能力可以将注意力机制中的

Softmax、Mask、MatMul等操作融合为一个算子,大幅减少访存和kernel启动开销,显著提升推理吞吐和降低延迟。

💡 案例:优化一个简单的生成模型组件

假设你要优化一个自回归语言模型的下一个token预测部分,它本质是一个大的矩阵乘法。通过使用ops-nn中经过深度优化的MatMul算子,并结合双缓冲(Double Buffering) 和流水线技术,可以有效隐藏数据搬运延迟,提升计算单元的利用率,从而加速整个生成过程。

六、如何开始参与与贡献?成为算子共建者

CANN生态鼓励开发者参与算子共建。你可以通过以下方式参与:

- 学习与体验:

-

- 官方文档:访问昇腾社区,查阅详细的CANN、TIK、Ascend C开发文档。

- 开源仓库:深入研究

cann-ops(Gitee)和ops-nn(AtomGit)仓库中的现有算子实现代码,学习其优化技巧和编程范式。 - CANN训练营:华为定期举办CANN训练营,提供从入门到精通的系列课程和实战演练。

- 实践与开发:

-

- 使用Ascend C开发新算子:基于你熟悉的C++,使用Ascend C为你的AIGC模型开发或优化特定算子(如自定义的激活函数、高效注意力算子等)。

- 性能调优:对现有算子进行性能分析和调优,尝试提升其计算效率。

- 贡献与分享:

-

- 提交Pull Request:当你开发出高质量、经过验证的算子后,可以向CANN的官方算子仓库提交PR。

- 分享经验:在CANN社区、博客或技术论坛分享你的开发经验和优化技巧,帮助更多开发者。

结语:走向深度的系统化优化

在AIGC时代,算法创新与系统优化同等重要。CANN的ops-nn算子库为我们提供了一个将深度学习计算映射到昇腾硬件的强大平台。通过理解TIK/Ascend C的开发范式,掌握数据搬运、内存管理和流水线并行等核心技术,我们才能不仅仅是“使用”算子,更能“优化”和“创造”算子,从而为AIGC应用注入极致性能。

进一步探索:你可以从实现一个简单的自定义算子(如带特殊填充的卷积或一种新型的激活函数)开始你的算子开发之旅,这将是对你理解硬件-软件协同优化的一次绝佳实践。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)