昇腾CANN Runtime深度解析:AI计算引擎的核心驱动力

本文介绍了昇腾AI软件栈中的Runtime组件,作为连接AI框架与硬件处理器的关键桥梁。Runtime包含三大核心模块:运行时引擎负责任务调度,资源管理层优化硬件分配,内存管理系统确保数据高效流动。文章详细阐述了Runtime的多层次API体系、典型执行流程、维测功能组件以及性能优化指南,并展望了其自适应运行时技术的发展趋势。该组件通过精心设计的架构,将昇腾处理器的计算潜力转化为实际应用性能,为开

CANN 组织链接: https://atomgit.com/cann

runtime仓库链接:https://atomgit.com/cann/runtime

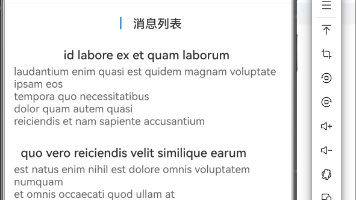

目录

1. 昇腾AI软件栈中的Runtime:连接计算梦想与硬件现实的关键桥梁

3. Runtime API体系:从易用到深度控制的多层次接口

4. Runtime执行流程:从模型加载到结果返回的完整旅程

1. 昇腾AI软件栈中的Runtime:连接计算梦想与硬件现实的关键桥梁

在人工智能计算领域,硬件性能的充分发挥离不开高效、稳定的软件运行时环境。昇腾CANN(Compute Architecture for Neural Networks)运行时正是这样一套精心设计的软件组件,它如同一位经验丰富的指挥家,精准协调着上层AI框架与底层昇腾AI处理器之间的每一个交互细节。作为CANN架构的中枢神经,Runtime不仅负责任务调度与执行,更提供了全面的系统监控和调试功能,是确保AI应用能够在昇腾硬件上高效、稳定运行的基石。

Runtime的核心价值在于它对复杂性的抽象和对效率的极致追求。在异构计算环境中,AI工作负载需要跨CPU、AI处理器等多个计算单元协同执行,数据需要在不同存储层级间高效流动,这些复杂任务均由Runtime透明处理。通过精心设计的资源管理、任务调度和内存优化机制,Runtime能够将硬件计算潜力转化为实实在在的应用性能,同时为开发者提供简洁一致的编程接口。

从发展历程来看,Runtime经历了从基础设备管理到全面智能调度的演进过程。早期版本主要关注设备初始化和基本任务执行,而现代Runtime已经发展成为包含资源管理、性能优化、系统监控和故障恢复的完整生态系统。这种演进反映了AI计算从单一模型推理到复杂训练任务、从单设备到大规模集群部署的发展趋势。

2. Runtime的架构全景:三大核心模块协同作战

2.1 运行时核心引擎:AI任务执行的“中央处理器”

Runtime的核心引擎是任务调度与执行的中枢,负责将AI计算图转化为在昇腾硬件上实际执行的操作序列。这一过程涉及多个关键环节:

任务管理子系统采用多层次队列与优先级调度机制,确保高优先级任务能够快速获得计算资源。系统维护多个任务队列,根据任务类型、资源需求和截止时间等因素动态调整执行顺序。对于实时推理任务,系统会采用抢占式调度策略,确保低延迟要求得到满足;而对于训练任务,则更注重吞吐量和资源利用率。

同时,该系统实现了计算与数据搬运的流水线并行,通过分析计算图中的数据依赖关系,将没有依赖关系的任务并行下发执行,最大化硬件利用率。高级调度算法能够识别计算图中的并行机会,将可并行的算子分配到不同的计算单元上同时执行,充分利用AI处理器的多核心架构。

设备管理模块负责昇腾AI处理器的初始化、状态监控和错误恢复。它维护着每个AI核心的详细状态信息,包括计算单元利用率、温度、功耗等关键指标,为动态负载均衡和系统健康管理提供数据支持。该模块还实现了设备的虚拟化功能,允许单个物理设备被划分为多个逻辑设备,供不同的应用或用户使用,提高硬件资源的利用率。

执行控制模块实现了自适应执行策略,能够根据工作负载特性和系统状态动态调整执行参数。例如,在运行大batch size的推理任务时,它会自动调整AI核心的并行度;而在处理动态形状的模型时,则会启用特殊的形状推断和执行优化机制。该模块还包含了一个轻量级的性能预测模型,能够预估不同执行策略的性能表现,并选择最优策略。

2.2 资源管理层:精准高效的硬件资源调配师

资源管理是Runtime高效运行的基础,它确保每个任务都能在正确的时间获得恰当的资源。这一功能主要通过三个子模块实现:

计算资源管理采用细粒度时间片轮转与空间分区相结合的策略。昇腾AI处理器中的多个计算核心可以按需分配给不同任务或进程使用,实现硬件资源的灵活共享与隔离。时间片轮转适用于短时间任务,确保快速响应;空间分区则适合长时间运行的任务,提供更稳定的性能表现。这种设计特别适合云环境中的多租户场景,不同用户的AI任务可以在同一硬件上安全、高效地并行执行。

内存资源管理实现了统一虚拟地址空间与智能分页机制。所有处理器(CPU和AI处理器)共享统一的虚拟地址空间,简化了数据交换过程。内存管理器会跟踪每个张量的生命周期,在不再需要时及时释放,并对频繁访问的数据实施智能缓存。高级内存管理功能还包括透明大页支持、内存压缩和交换空间管理,这些功能共同作用,确保即使在内存压力较大的情况下,系统也能保持高效运行。

通信资源管理优化了设备间与设备内数据通信。对于多卡训练场景,Runtime提供了高效的集合通信原语,如AllReduce、Broadcast等,并针对昇腾芯片的互联拓扑进行专门优化,最大限度地降低分布式训练中的通信开销。该模块支持多种通信模式,包括点对点通信、集体通信和远程直接内存访问(RDMA),能够根据网络条件和任务需求自动选择最优通信策略。

2.3 内存管理系统:数据流动的高速公路

内存管理对AI计算性能有着决定性影响。Runtime的内存管理系统通过多种创新技术,确保数据能够高效地在存储层级间移动:

统一内存架构消除了CPU与AI处理器之间的数据拷贝开销。通过地址转换和一致性协议,CPU和AI处理器可以直接访问同一物理内存区域,大大减少了数据搬运延迟和内存占用。这一架构还支持内存的原子操作和一致性维护,确保多处理器并发访问时的数据正确性。

智能内存分配器采用伙伴系统与内存池相结合的策略,针对AI负载中常见的张量分配模式进行专门优化。它会预先分配常用大小的内存块,并通过内存复用技术减少动态分配的开销。分配器还实现了延迟分配和提前释放策略,进一步优化内存使用效率。对于特别频繁的内存分配模式,分配器会学习并缓存分配模式,提供更快的分配速度。

数据预取与缓存机制通过分析计算图的数据访问模式,预测下一步需要的数据并提前加载到高速缓存中。这种基于计算图分析的预取策略能够有效隐藏内存访问延迟,提升计算单元利用率。缓存系统采用多层次设计,包括寄存器缓存、共享缓存和全局缓存,每层缓存针对不同数据访问模式进行优化。智能缓存替换算法会根据数据访问频率、时间和空间局部性等因素动态调整缓存内容,最大化缓存命中率。

3. Runtime API体系:从易用到深度控制的多层次接口

3.1 三级API结构:满足不同开发需求

Runtime提供多层次API,适应从快速原型开发到底层性能优化的全场景需求:

高层API(模型级接口) 面向算法工程师和AI应用开发者,提供最简单直接的使用方式。通过极简的接口,开发者可以加载模型、准备数据、执行推理并获取结果,无需关注底层硬件细节。这一层API抽象了设备的异构性,提供统一的编程模型,使同一份代码可以在不同代际的AI处理器上运行。高层API还集成了常用的预处理和后处理功能,进一步简化开发流程。

中层API(图与算子级接口) 为框架集成者和高级开发者提供更细粒度的控制能力。开发者可以直接操作计算图,添加自定义算子,或调整执行计划。这一层API支持动态形状、条件分支等高级图特性。中层API还提供了丰富的图分析和优化工具,帮助开发者理解和改进计算图的执行效率。通过这些接口,开发者可以访问中间表示(IR)、调整内存布局、控制算子融合策略等。

底层API(设备级接口) 提供最直接的硬件控制能力,适合系统开发者和研究者进行深度优化。通过这些接口,可以精确控制每个AI核心的计算任务,实现定制化的计算模式。底层API暴露了硬件的详细信息,包括核心数量、内存层次、特殊功能单元等,使开发者能够充分利用硬件特性。这一层API还提供了直接内存访问(DMA)控制、中断处理和性能计数器访问等低级功能。

3.2 核心API功能详解

上下文管理API 负责创建和管理执行环境。每个上下文对应一个独立的执行环境,包含自己的资源池和执行队列。Runtime支持多上下文并行执行,允许不同应用或同一应用的不同部分同时使用硬件资源。上下文API还提供了资源限制功能,可以为每个上下文设置计算资源、内存和功耗的上限,确保系统的公平性和稳定性。上下文之间可以共享资源,也可以完全隔离,满足不同的安全性和性能需求。

内存管理API 提供设备内存的分配、释放和迁移功能。除了基本的内存操作,还包括异步内存拷贝、内存复用等高级特性,帮助开发者优化内存使用模式。内存API支持多种内存类型,包括设备内存、主机内存和共享内存,每种内存类型有不同的特性和使用场景。高级内存管理功能包括内存映射、内存锁定和NUMA感知分配,这些功能共同帮助开发者实现最优的内存访问性能。

任务调度API 允许开发者控制任务的执行顺序和并行度。通过显式指定任务依赖关系,可以构建复杂的数据流水线;而流与事件机制则提供了细粒度的执行同步能力。任务API支持多种任务类型,包括计算任务、内存拷贝任务和同步任务,每种任务类型有不同的特性和优化方法。高级调度功能包括任务优先级设置、截止时间约束和资源预留,这些功能使开发者能够实现复杂的调度策略。

性能分析API 提供丰富的性能数据收集功能。开发者可以获取每个算子的执行时间、内存使用情况、设备利用率等指标,为性能优化提供数据支撑。性能API支持多种分析模式,包括实时监控、离线分析和对比分析,每种模式适用于不同的优化场景。分析工具还提供了可视化功能,可以将性能数据以图表形式展示,帮助开发者直观理解系统行为。

4. Runtime执行流程:从模型加载到结果返回的完整旅程

4.1 典型执行流程详解

AI任务在Runtime中的执行遵循一条精心设计的路径,每个环节都经过深度优化:

初始化阶段 建立与昇腾AI处理器的连接通道。此阶段Runtime会检测可用设备,加载相应驱动程序,并建立管理数据结构。多设备环境下的初始化过程经过特别优化,能够并行探测所有设备,显著减少启动时间。初始化过程还包括资源预留和环境配置,确保系统在后续执行阶段的稳定性和性能。对于大规模集群环境,初始化过程还包含设备拓扑发现和通信网络建立,为分布式计算做好准备。

资源分配阶段 根据任务需求分配计算资源。Runtime采用延迟分配策略,仅在任务实际需要时才分配资源,提高资源利用率。对于常见模型,它会使用预分配的内存池,避免重复分配的开销。资源分配过程考虑了多个因素,包括任务的计算需求、内存需求、通信需求和功耗限制,确保分配的资源既满足任务需求,又不会造成浪费。对于长期运行的任务,资源管理器还会监控资源使用情况,并根据需要动态调整资源分配。

任务执行阶段 将计算任务下发到AI处理器。此阶段Runtime实施动态负载均衡,监控各AI核心的负载情况,将任务智能分配到空闲核心。对于多节点任务,它还会协调节点间的数据同步。任务执行过程采用异步模式,计算、数据搬运和通信操作可以重叠进行,最大化硬件利用率。执行引擎还实现了错误检测和恢复机制,当检测到硬件错误或软件异常时,能够自动重试或切换到备用计算路径。

清理阶段 释放已分配资源。Runtime采用引用计数与垃圾回收相结合的资源管理策略,确保资源在不再需要时被及时释放,同时避免过早释放导致的错误。清理过程还包括状态保存和日志记录,为后续任务执行和系统调试提供信息。对于可复用资源,清理阶段不会立即释放,而是将其返回资源池,供后续任务使用,减少资源分配开销。

4.2 高级执行特性

多流并行执行 允许单个应用创建多个执行流,每个流可以独立提交任务。Runtime会自动检测不同流中任务的数据依赖关系,在保证正确性的前提下最大化并行度。这种机制特别适合多输入多输出的复杂模型。多流执行还支持流优先级和抢占功能,高优先级的流可以中断低优先级流的执行,确保关键任务的实时性。流之间可以通过事件进行同步,实现复杂的执行模式。

动态形状支持 使Runtime能够高效处理输入尺寸变化的模型。通过在线形状推断与内存重分配优化,Runtime在保持高性能的同时,支持完全动态的输入形状,无需为每种可能形状预编译内核。动态形状支持包括形状推导、内存规划和内核选择三个步骤,每个步骤都经过高度优化,最小化形状变化带来的开销。对于常见的形状变化模式,系统还会缓存优化结果,加速后续执行。

混合精度计算 Runtime全面支持FP16、FP32和INT8等精度格式,并能在不同精度间自动转换。对于支持混合精度的模型,它会自动将适合低精度计算的部分转换为FP16或INT8,在保持精度的同时提升计算速度。混合精度计算包括精度选择、类型转换和精度损失控制三个环节,每个环节都有多种策略可供选择。系统还提供了精度调试工具,帮助开发者分析和优化模型的精度表现。

5. 维测功能组件:确保系统稳定运行的守护者

5.1 系统监控与健康检查

Runtime的维测组件提供全方位、多粒度的系统监控能力,确保AI应用的稳定运行:

实时性能监控 收集各类性能指标,包括设备利用率、内存使用率、功耗和温度等。这些指标以时间序列数据的形式保存,可以用于性能分析和异常检测。监控数据通过轻量级二进制协议收集,对系统性能影响极小。监控系统支持自定义指标和告警规则,开发者可以根据应用需求定义关键性能指标(KPI)和异常阈值。监控数据可以通过多种方式访问,包括API查询、文件导出和可视化界面,满足不同的使用场景。

健康检查系统 定期对昇腾AI处理器进行诊断测试,包括内存测试、计算单元测试和互联测试等。渐进式测试策略确保在最短时间内发现潜在问题,同时最小化对正常任务的影响。健康检查包括启动时检查、运行时检查和定期深度检查三个层次,每个层次有不同的测试范围和频率。检查结果会与历史数据进行比较,识别性能退化和异常趋势。对于检测到的问题,系统会提供修复建议和自动化修复工具。

错误预警与预测 基于历史数据和应用行为模式,维测组件能够预测潜在的系统问题。例如,当检测到内存泄漏趋势时,它会提前发出警告,并建议采取预防措施。预警系统使用机器学习算法分析监控数据,识别异常模式和发展趋势。预测功能包括故障预测、性能预测和资源需求预测,帮助系统管理员提前采取措施,避免问题发生。预警信息可以通过多种渠道发送,包括系统日志、电子邮件和移动通知,确保及时响应。

5.2 故障诊断与调试工具

当系统出现异常时,Runtime提供强大的诊断工具帮助快速定位问题:

分层日志系统 记录从设备驱动到应用层的所有关键事件。日志采用结构化格式,便于自动化分析,同时支持动态日志级别调整,可以在不重启应用的情况下增加或减少日志细节。日志系统支持多种输出目标,包括文件、网络和数据库,满足不同的部署需求。高级日志功能包括日志压缩、加密和完整性验证,确保日志的安全性和可靠性。日志分析工具可以自动识别常见问题模式,并提供解决方案建议。

性能瓶颈分析工具 帮助开发者识别应用中的性能瓶颈。通过关键路径分析和热点函数识别,开发者可以快速找到限制性能的关键操作,并有针对性地进行优化。分析工具支持多种分析模式,包括CPU分析、内存分析和I/O分析,每种模式提供不同的优化视角。工具还提供了比较分析功能,可以对比不同版本或配置的性能表现,评估优化效果。分析结果可以生成可视化报告,直观展示性能问题和优化机会。

内存错误检测 专门针对AI应用中常见的内存问题设计。它可以检测越界访问、使用已释放内存、内存泄漏等问题,并提供详细的错误上下文信息,大大简化调试过程。内存检测工具支持多种检测模式,包括快速检测、深度检测和持续监控,每种模式有不同的检测范围和性能开销。工具还提供了内存调试功能,包括内存标记、内存追踪和内存快照,帮助开发者理解复杂的内存使用模式。检测结果包括问题位置、影响范围和修复建议,加速问题解决过程。

5.3 容错与恢复机制

在分布式训练或长时间推理任务中,Runtime提供多种容错机制确保任务完成:

检查点与恢复 支持定期保存训练状态,当发生故障时可以从最近的检查点恢复训练,避免重复计算。检查点保存过程经过优化,采用增量保存策略,只保存自上次检查点以来发生变化的部分。检查点系统支持多种保存频率和粒度,可以根据任务特性和系统状况动态调整。恢复过程包括状态验证和一致性检查,确保恢复后的状态正确无误。对于大规模模型,检查点系统还支持分层保存和并行保存,减少保存时间和存储空间。

弹性训练支持 允许在训练过程中动态调整资源分配。当某个节点发生故障时,Runtime可以自动调整任务分配,在剩余节点上继续训练,最大限度地减少故障对整体进度的影响。弹性训练包括故障检测、状态保存、资源重分配和训练恢复四个步骤,每个步骤都有多种策略可供选择。系统还支持主动弹性调整,根据负载变化动态增减计算资源,优化资源利用率。弹性训练功能与检查点系统紧密集成,确保状态的一致性和可恢复性。

容错通信机制 在分布式计算中提供可靠的通信保障。当网络出现问题时,通信层能够自动重试、切换路径或降级通信模式,确保训练过程的连续性。容错通信包括错误检测、连接管理和数据重传三个部分,每个部分都有多种算法可供选择。系统还支持多种通信拓扑和协议,可以根据网络状况自动选择最优配置。高级容错功能包括数据编码、冗余传输和分布式一致性维护,确保极端情况下的系统可用性。

6. Runtime最佳实践与性能优化指南

6.1 高效编程实践

充分发挥Runtime潜力需要遵循一定的编程模式和最佳实践:

异步执行模式 充分利用昇腾AI处理器的并行能力。通过将数据准备与计算重叠,可以显著提升系统整体吞吐量。异步编程的关键是正确管理任务依赖和数据流,避免竞态条件和死锁。以下示例展示了复杂异步执行模式:

python

# 创建多个流和事件用于精细控制

streams = [aclrt.create_stream() for _ in range(num_streams)]

events = [aclrt.create_event() for _ in range(num_events)]

# 构建异步执行流水线

for i in range(num_batches):

current_stream = streams[i % num_streams]

previous_event = events[(i-1) % num_events] if i > 0 else None

# 等待前一批数据准备完成

if previous_event:

aclrt.stream_wait_event(current_stream, previous_event)

# 异步准备数据

prepare_data_async(i, current_stream)

# 记录数据准备完成事件

data_ready_event = events[i % num_events]

aclrt.record_event(data_ready_event, current_stream)

# 在另一个流上执行计算

compute_stream = streams[(i+1) % num_streams]

aclrt.stream_wait_event(compute_stream, data_ready_event)

execute_model_async(i, compute_stream)

# 同步所有流

for stream in streams:

aclrt.synchronize_stream(stream)

内存使用优化 合理管理内存生命周期。尽可能复用内存缓冲区,避免频繁分配释放;对于大小固定的张量,使用预分配的内存池;对于可变大小的张量,考虑使用最大可能尺寸一次性分配。高级内存优化技术包括内存池化、内存对齐和NUMA感知分配,这些技术可以显著提升内存访问性能。内存分析工具可以帮助识别内存瓶颈和优化机会,指导优化决策。

批处理策略 根据应用场景选择合适的批处理大小。较大的批处理可以提高计算效率,但会增加延迟和内存占用。Runtime提供动态批处理功能,可以自动调整批处理大小以适应不同负载。动态批处理算法考虑多个因素,包括输入数据特性、系统负载和性能目标,实时调整批处理策略。对于时延敏感的应用,可以采用小批处理或流式处理;对于吞吐量优先的应用,则可以采用大批处理。批处理优化还包括批处理调度和内存管理,确保批处理过程的高效性。

6.2 性能调优技巧

针对常见性能瓶颈,以下调优技巧可以帮助提升应用性能:

计算密集型任务优化 确保AI处理器的计算单元得到充分利用。通过分析性能数据,如果发现计算单元利用率偏低,可以尝试增加并行度或调整任务划分策略。计算优化技术包括算子融合、内核优化和计算调度优化,这些技术可以从不同层面提升计算效率。硬件特性利用也是计算优化的重要方向,包括特殊指令集使用、张量核心利用和流水线优化,这些技术可以充分发挥硬件计算潜力。

内存带宽优化 减少不必要的数据搬运。尽可能使用原地操作,减少中间结果的产生;合理安排计算顺序,提高数据局部性;使用异步内存拷贝隐藏数据传输延迟。内存带宽优化还包括内存访问模式优化、数据布局优化和缓存友好算法设计,这些技术可以提升内存系统的效率。对于带宽受限的应用,还可以采用数据压缩、精度降低和稀疏化技术,减少数据传输量。

多设备扩展优化 在分布式训练场景中,优化通信模式。根据昇腾处理器的互联拓扑合理安排任务分配,使通信密集的操作发生在连接紧密的设备之间;使用梯度压缩等技术减少通信数据量。多设备优化还包括负载均衡、通信调度和同步优化,这些技术可以提升分布式系统的扩展性。对于大规模集群,还需要考虑网络拓扑、通信协议和容错机制,确保系统的稳定性和性能。

7. Runtime的未来演进与社区生态

7.1 技术发展趋势

随着AI计算需求的不断演进,Runtime技术也在持续发展:

自适应运行时技术 使Runtime能够根据工作负载特性自动调整执行策略。通过在线学习和分析,Runtime可以识别应用的计算模式,并动态优化资源分配和任务调度策略。自适应技术包括工作负载特征提取、性能建模和策略优化三个部分,每个部分都使用先进的机器学习算法。未来自适

CANN 组织链接: https://atomgit.com/cann

runtime仓库链接:https://atomgit.com/cann/runtime

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)