快来看看 vLLM × Ascend 年度回顾:2025 年度总结

2025 年,vLLM Ascend 项目正式创建,并在一年内完成了 25 次快速迭代,与社区共同打磨代码、测试、文档与反馈。项目的使命是为昇腾(Ascend)用户提供易用、高性能、低成本的推理服务,并推动从 0 到 1 到生产落地的持续演进,聚焦分布式推理与强化学习等关键场景。全年发布了 3 个正式版本和 22 个尝鲜版本,重要里程碑包括 v0.7.1rc1、v0.7.3、v0.9.1、v0.1

注:原始内容来自开源时刻,作者为 vLLM Ascend Team,链接:https://mp.weixin.qq.com/s/hyY4DtWkEAM7jXfyt8BLuA

2025 年,vLLM Ascend 项目正式创建,并在一年内完成了 25 次快速迭代,与社区共同打磨代码、测试、文档与反馈。项目的使命是为昇腾(Ascend)用户提供易用、高性能、低成本的推理服务,并推动从 0 到 1 到生产落地的持续演进,聚焦分布式推理与强化学习等关键场景。全年发布了 3 个正式版本和 22 个尝鲜版本,重要里程碑包括 v0.7.1rc1、v0.7.3、v0.9.1、v0.11.0、v0.13.0rc1 等的性能提升与稳定性改善。还举办了多场社区活动与行业峰会,获得互联网企业、银行、运营商等多方的积极反馈与合作。展望 2026 年,计划继续稳定插件接口、扩大生产落地范围,感谢并携手全球贡献者推动昇腾推理生态的持续发展。

截至 2025 年末,vLLM Ascend 项目已完成了从零到一的探索阶段。在过去一年中,团队与社区用户和开发者共同协作,通过持续的代码开发与实践验证不断推进项目成熟。

回顾 2025 年的发展历程

年初,vLLM Ascend 项目(即 vLLM 昇腾适配插件)正式启动。在不到一年的时间内,团队从首个尝鲜版本开始,以每两周为一个迭代周期,累计完成了 25 个版本的快速迭代。

在整个开发过程中,团队与社区开发者紧密合作:确保每行代码的质量,严格执行每项测试,精心撰写技术文档,并认真处理每个 Issue 与改进建议。项目的每一步进展,都离不开社区开发者的积极参与和宝贵反馈。

vLLM Ascend 项目的使命

vLLM Ascend 项目的使命明确为:作为 vLLM 生态的关键组成部分,专注于为华为昇腾用户提供易用、高性能且成本效益优异的大模型推理解决方案,同时持续向 vLLM 开源社区贡献代码与优化经验,推动生态共建共赢。

vllm-ascend 项目从技术探索到全面生产化落地的演进历程如下:

-

技术奠基阶段:完成了硬件插件原型开发,并实现了对主流模型及基础特性的初步支持,为项目及社区协作奠定了技术基础。

-

生产化准备阶段:重点提升在昇腾硬件上的实际可用性与稳定性,持续完善功能、优化性能,并初步构建与上下游工具链的生态连接。

-

2025 年第三季度:团队高效完成了与 vLLM V1 推理引擎的适配工作,实现了架构层面的重要升级。在此基础上,系统性地提升了代码质量与部署规范性,以满足生产环境要求。同时,持续优化用户与开发者体验,并在分布式推理、强化学习等关键应用场景中增强了竞争力。

-

2025 年第四季度:团队致力于稳定硬件插件接口,增强系统泛化能力,并持续进行性能优化。针对超低时延响应、长上下文序列处理等关键难题实施了深度优化,旨在将 vLLM Ascend 打造为适用于更广泛场景的可靠推理解决方案。

上图中这些关键词,既记录了团队过去一年中技术探索与精心打磨的历程,也见证了 vLLM 与昇腾在互联网、金融、运营商等多个行业的实际生产环境中实现规模化落地。

致敬社区的每一次提交

通过快速迭代发布的 25 个版本,团队向社区贡献者的每一次提交致以敬意:2025 年,团队与社区开发者共同发布了 3 个正式版本与 22 个尝鲜版本。

v0.7.1rc1 是 vLLM 昇腾适配插件的首个候选版本。在发布第一行 Release Note —— “🎉 Hello, World! We are excited to announce the first release candidate of v0.7.1 for vllm-ascend.” 之际,也标志着该项目正式向社区亮相。同期发布的配套资源还包括:支持一键安装的 Python 软件包、帮助用户上手的教程与文档、可快速部署服务的容器镜像,以及集成于昇腾平台的持续集成(Continuous Integration,CI)环境,以协助开发者高效完成功能验证。

此后,团队确立了每两周发布一个版本的迭代周期。版本演进脉络清晰:v0.7.3 实现了核心加速特性的全面支持;v0.9.1 引入了对大规模专家并行(Expert Parallel,EP)的支持;v0.11.0 显著提升了高性能与稳定性;v0.13.0rc1 尝鲜版本则在超低时延与长序列处理方面取得了关键突破。这一历程,完整展现了从单机稠密模型的深度性能优化,到大规模分布式推理能力的有序拓展。

多次技术交流与分享活动,亦同步推动了社区的快速成长,精彩集锦如下图所示:

-

2025 年 3 月,在 “国内首次 vLLM Meetup” 上,团队分享了主题为《昇腾插件化接入 vLLM 最佳实践》的内容,该文章随后发表于 vLLM 官方博客,并与社区用户展开了深入讨论。

-

2025 年 5 月,在 “昇腾 AI 开发者峰会 2025” 上,vLLM 项目 Committer 游凯超受邀发表演讲《昇腾全面支持 vLLM,加速大模型推理创新》,详实介绍了 vLLM 与昇腾结合的最新技术进展。

-

2025 年 6 月,团队受邀出席 PyTorch Day China 大会,并在 Poster Session 环节展示了 vLLM × 昇腾在推理加速落地方面的最新实践成果。

-

2025 年 8 月,在 “vLLM 北京 Meetup” 上,团队分享了基于 vLLM 与昇腾构建大规模专家并行能力及进行模型优化的最佳实践。

-

2025 年 10 月,在北京大学人工智能研究院举办的 “科技节” 活动中,团队分享了主题为《vLLM × 昇腾竞争力构建与实战》的技术内容。

来自开发者的走心寄语

2025 年,项目从零到一的孵化与成长,得益于每一位开发者的使用与贡献。我们汇集了来自社区的多方真实反馈,这些认可与支持是我们持续前进的核心动力:

vLLM Project Co-Leader 游凯超:“vLLM 始终致力于为用户提供易用、高性能、低成本的推理服务。广泛的硬件与模型支持是 vLLM 生态繁荣的基石,而 vLLM-Ascend 项目正是该生态系统的重要组成部分。2025 年,vLLM-Ascend 项目完成了从创建到成熟的跨越。展望 2026 年,祝愿 vLLM-Ascend 项目能再进一步:持续增强插件化机制的接口稳定性,并加速 vLLM 在大规模分布式推理、强化学习等关键场景的生产化落地。”

来自某互联网企业的核心维护者:“我们基于 vLLM 0.11.0 及配套的 vLLM Ascend 插件,构建并部署了核心推理系统,成功承载了在线与离线等多场景生产业务。一项超低时延部署方案也已进入上线阶段。自今年三、四月份项目启动以来,我们的业务与社区生态实现了同步成长。”

来自国内某大型银行的核心维护者:“今年,我们成功将生产环境的推理引擎切换至 vLLM。依托 vLLM Ascend 插件的高性能与良好扩展性,不仅显著提升了硬件资源利用率,也加快了我们针对新推出模型的适配速度。我们期待与社区携手,共同推动 vLLM Ascend 项目的发展,并将我们在落地实践中取得的优化与改进回馈给社区。”

来自某电信领域运营商的贡献者:“我们基于 vLLM + vLLM Ascend,已成功上线包括 DeepSeek V3.2、Qwen 系列文本模型、VL 多模态理解模型、Pooling 模型(Pooling 类模型用于处理序列数据,通过池化操作将变长序列转换为固定长度的表示,常见的 Pooling 模型包括嵌入模型、分类模型、得分模型、奖励模型等)、GLM 系列等在内的 10+ 模型。这些模型通过智算平台、模型即服务(Model as a Service,MaaS)及智能体等多种形态,服务于政府、企业、高校及互联网等领域的云上客户。我们愿与社区一道,持续贡献并积极回馈。”

来自 verl 社区的 Committer:“在强化学习(Reinforcement Learning,RL)场景中,我们借助 vLLM 及 vLLM Ascend 插件,实现了对 Qwen 等主流模型的 GRPO/DAPO 训练,并完成了面向异步 RL 训练场景的 Server 化改造。从 v0.7.3 到 v0.9.1,再到当前的 v0.11.0,我们始终积极跟进每个版本,并与 vLLM 开发者协作,共同推动性能优化。”

来自 LLaMA-Factory 的作者:“通过集成 vLLM 与 vLLM Ascend,我们实现了 LLaMA-Factory 的高效分布式推理能力,从而帮助昇腾开发者一站式完成从大模型训练到推理的全流程闭环。”

来自 GPUStack 的核心维护者:“GPUStack 基于 vLLM 与 vLLM Ascend,在昇腾平台上实现了覆盖范围更广、兼容性更优的一键式大模型推理部署方案。我们持续跟进 vLLM Ascend 的每一个版本迭代。在实际的框架集成与工程验证中,我们亲身见证了它在模型结构适配、兼容性及推理性能上的持续提升,并从中切实受益。项目落地推进过程中,我们也获得了社区开发者高效且专业的支持。展望 2026 年,我们期待在更多模型结构、更复杂的部署形态以及更大规模的推理场景中,与社区携手,共同推动昇腾推理生态的成熟与完善。”

来自 MinerU 的开发者:“MinerU 是一个一站式 PDF 文档解析工具。基于 vLLM 0.11.0 及 vLLM Ascend 插件,我们支持了 MinerU 命令行工具(mineru)、Gradio 交互界面(mineru-gradio)以及 OpenAI 兼容服务(mineru-openai-server),同时实现了数据并行加速能力。此外,依托 vLLM Ascend 提供的容器镜像,我们构建了可一键部署的 MinerU 昇腾专用镜像。”

结语

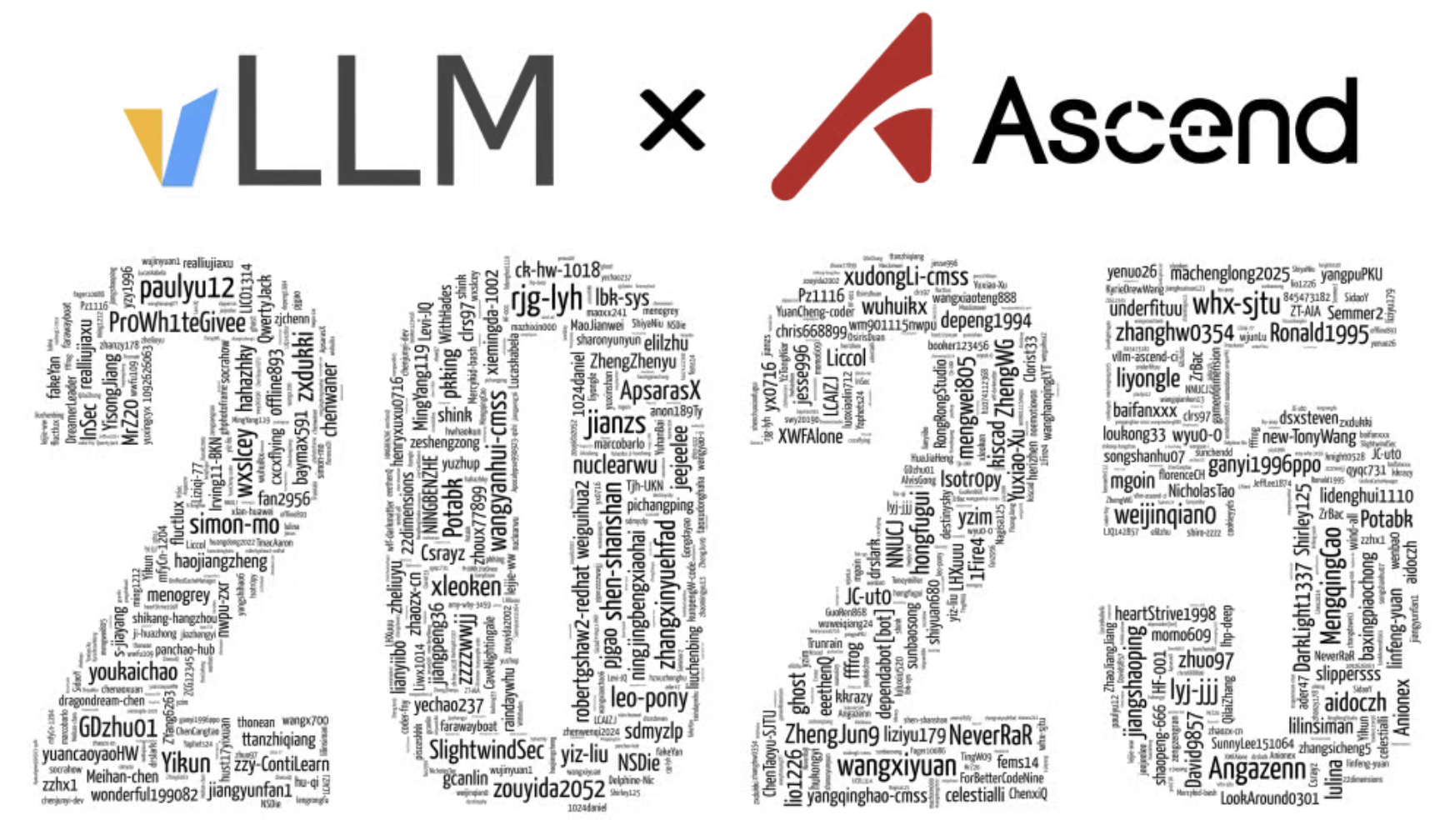

衷心感谢两百余位直接贡献代码的开发者,感谢将项目应用于各行各业生产实践的社区贡献者,以及此刻正在阅读 vllm-ascend 项目主页或者这篇文章的每一位用户。您们在实际场景中提供的反馈、建议与持续关注,是 vLLM Ascend 项目最珍贵的资产与发展源泉。最终,我们以所有贡献者的 ID,共同汇聚成了这幅属于 vLLM x Ascend 的 2025 年画卷,如下所示:

我们也为 vLLM Ascend 社区中的优秀贡献者准备了纪念礼品。后续我们将逐步联系获奖者并安排礼品寄送 ⬇️

让我们带着过去一年的收获与经验,继续脚踏实地,聚焦解决实际问题。展望 2026 年,我们期待继续与社区携手并进,积极为 vLLM Ascend 社区作出贡献。我们的共同目标是持续为昇腾(Ascend)用户提供更易用、更高性能且更低成本的 AI 推理服务。

🔗 项目地址:https://github.com/vllm-project/vllm-ascend

🔗 官方文档:https://docs.vllm.ai/projects/ascend/en/latest/

🔗 每周例会:https://tinyurl.com/vllm-ascend-meeting

💬 添加小助手:ascendosc(备注加入交流群)

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)