CANN 开源仓核心模块解析:仓库结构与功能定位深度剖析

CANN 是华为面向 AI 场景设计的异构计算架构,其核心目标是打通上层 AI 框架与底层昇腾 AI 处理器之间的鸿沟,实现高效、灵活、可扩展的 AI 计算支持。对上兼容主流 AI 框架:如 TensorFlow、PyTorch、MindSpore 等,通过插件或适配层实现无缝对接;对下深度优化昇腾硬件:提供算子库、运行时调度、内存管理、图优化等底层能力;中间层提供统一编程模型:包括 Ascend

引言

AI在近几年发展的越来越快,异构计算架构已经成为了提升 AI 算力效率的关键支撑。华为推出的 CANN(Compute Architecture for Neural Networks)作为昇腾 AI 处理器的核心软件栈,不仅在工业界广泛应用,也通过开源方式向全球的开发者开放它的能力。2025 年,CANN 正式将开源主阵地迁移至 GitCode,标志着其社区生态建设迈入新阶段。

今天这篇文章将围绕 CANN 开源仓(https://gitcode.com/CANN)展开系统性解析,重点剖析其 仓库结构布局 与 各核心模块的功能定位,帮助大家快速理解 CANN 的整体架构、开发路径及协作机制。全文内容基于官方公开资料、代码结构分析及社区文档整理,力求为 AI 软件栈研究者、昇腾平台开发者提供一份详实的技术参考。

CANN 概述

CANN 是华为面向 AI 场景设计的异构计算架构,其核心目标是 打通上层 AI 框架与底层昇腾 AI 处理器之间的鸿沟,实现高效、灵活、可扩展的 AI 计算支持。这个架构特点可概括为:

- 对上兼容主流 AI 框架:如 TensorFlow、PyTorch、MindSpore 等,通过插件或适配层实现无缝对接;

- 对下深度优化昇腾硬件:提供算子库、运行时调度、内存管理、图优化等底层能力;

- 中间层提供统一编程模型:包括 AscendCL(C++ API)、TBE(Tensor Boost Engine)自定义算子开发框架等;

- 全栈开源与工具链支持:从编译器、调试器到性能分析工具,形成完整开发生态。

CANN 的开源不仅仅是代码的开放,更是构建一个 开放、协作、可持续演进的 AI 基础软件生态。而且 GitCode 上的 CANN 组织正是这一生态的核心载体。

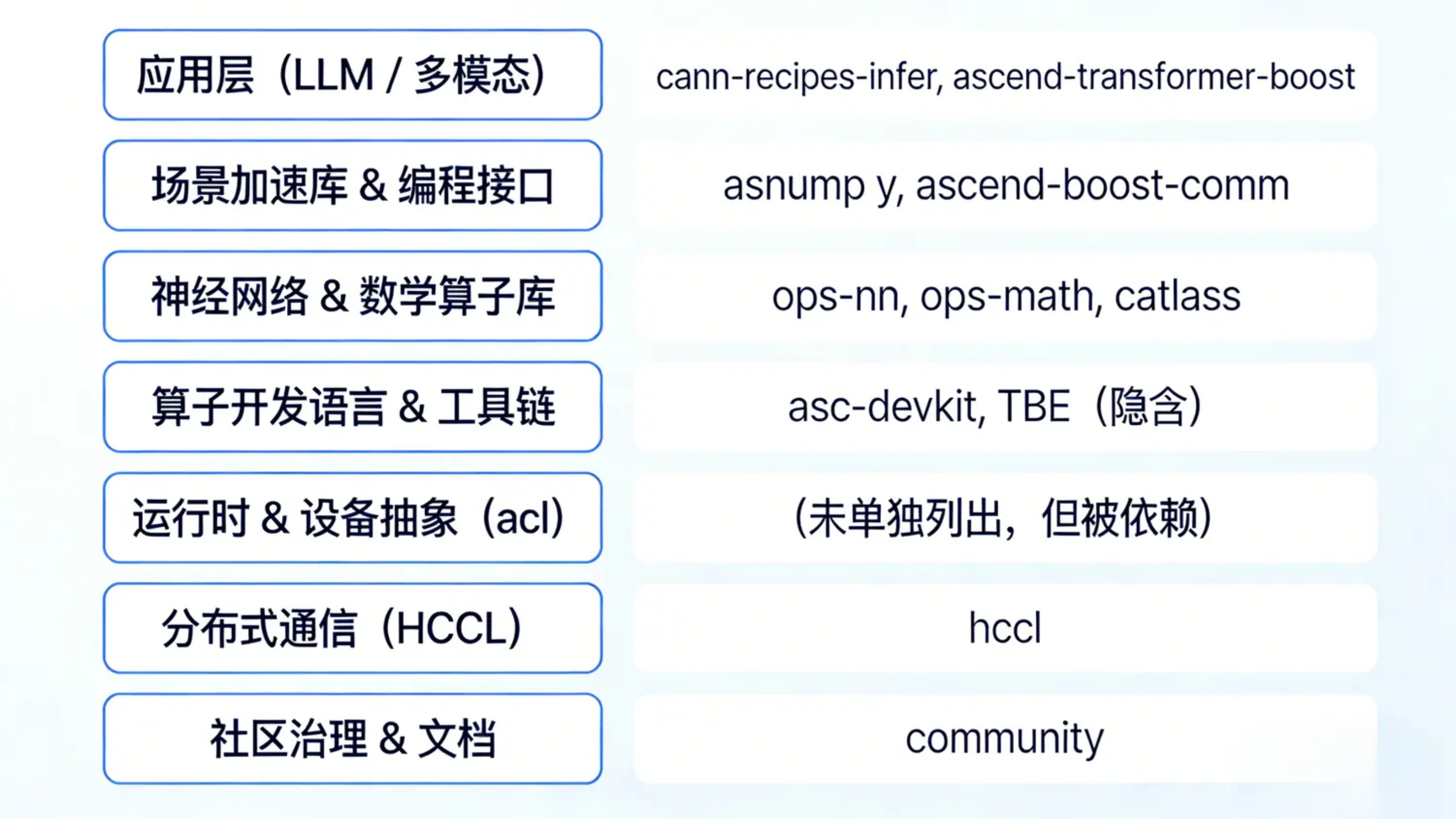

CANN 开源仓整体结构解析

访问 https://gitcode.com/CANN 可以看到,CANN 并非单一仓库,而是由 多个子项目(Repositories)组成的组织级开源体系。截至到今天,这个组织下包含 27 个公开项目,涵盖基础库、工具链、示例代码、文档、测试框架等多个维度。

仓库分类逻辑

根据功能与依赖关系,可以将 27 个仓库划分为以下五大层级:

三、核心模块详解(基于实际仓库列表)

3.1 基础算子库:ops-math 与 ops-nn

ops-math

描述: “CANN 提供的数学类基础计算算子库,实现网络在 NPU 上加速计算。”

-

- 包含通用数学运算:

Add,Mul,Exp,Log,ReduceSum等; - 高度优化的 FP16/INT8 实现,适配 AICore 架构;

- 是上层神经网络算子的基础构件。

- 包含通用数学运算:

ops-nn

描述: “CANN 提供的神经网络类计算算子库”

-

- 覆盖 CNN、RNN、Transformer 核心算子:

Conv2D,MatMul,LayerNorm,Softmax,GELU; - 支持算子融合(如

MatMul + BiasAdd + GELU)以减少 kernel launch 开销; - 与

catlass协同,提供矩阵乘高性能实现。

- 覆盖 CNN、RNN、Transformer 核心算子:

这两者构成了 CANN 的 算子基石,类似于 cuBLAS + cuDNN 在 CUDA 生态中的地位。

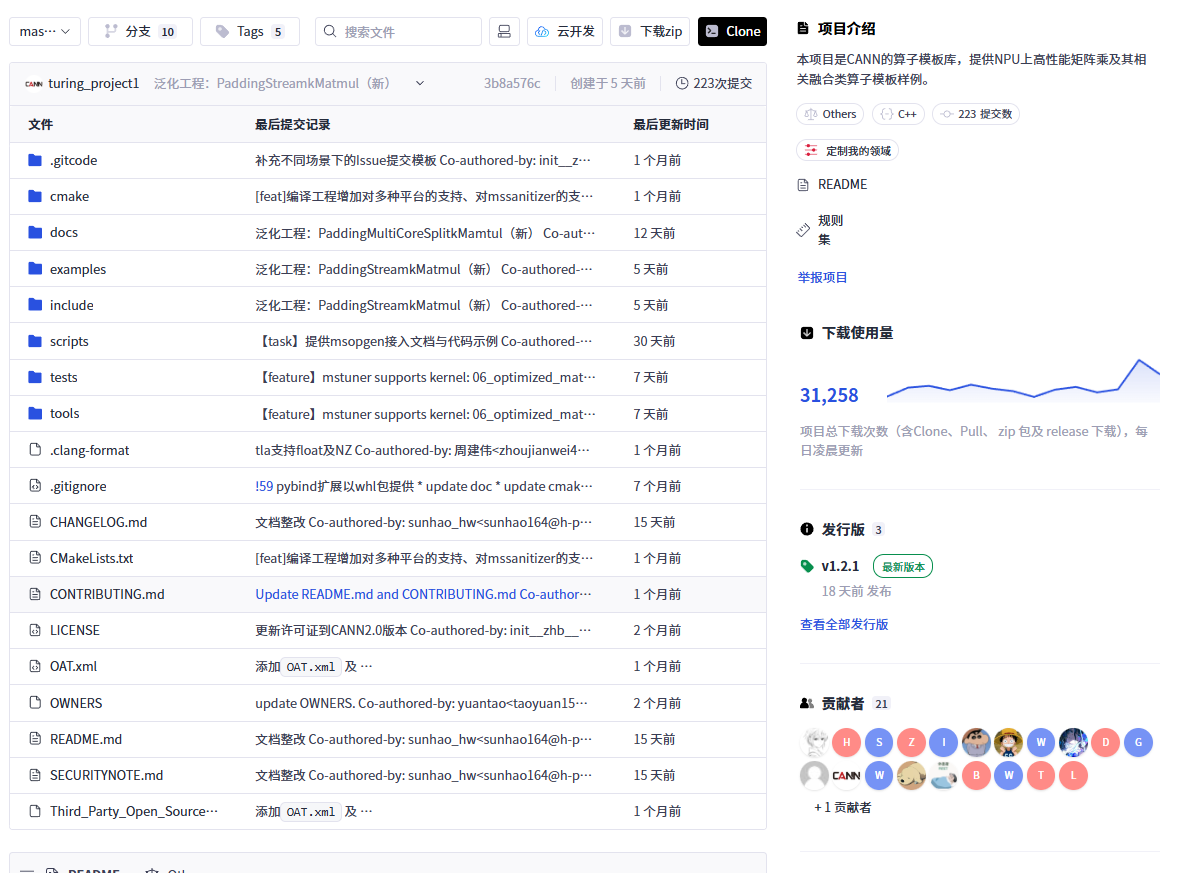

3.2 高性能矩阵计算:catlass

catlass

描述: “CANN 的算子模板库,提供 NPU 上高性能矩阵乘及其相关融合类算子模板样例。”

-

- 专注于 GEMM(General Matrix Multiply)优化;

- 提供可复用的 算子模板(Template),开发者可基于此快速构建自定义融合算子;

- 是

ascend-transformer-boost等高层加速库的底层依赖。

这个仓库体现了 CANN “模板化 + 可组合” 的算子开发哲学。

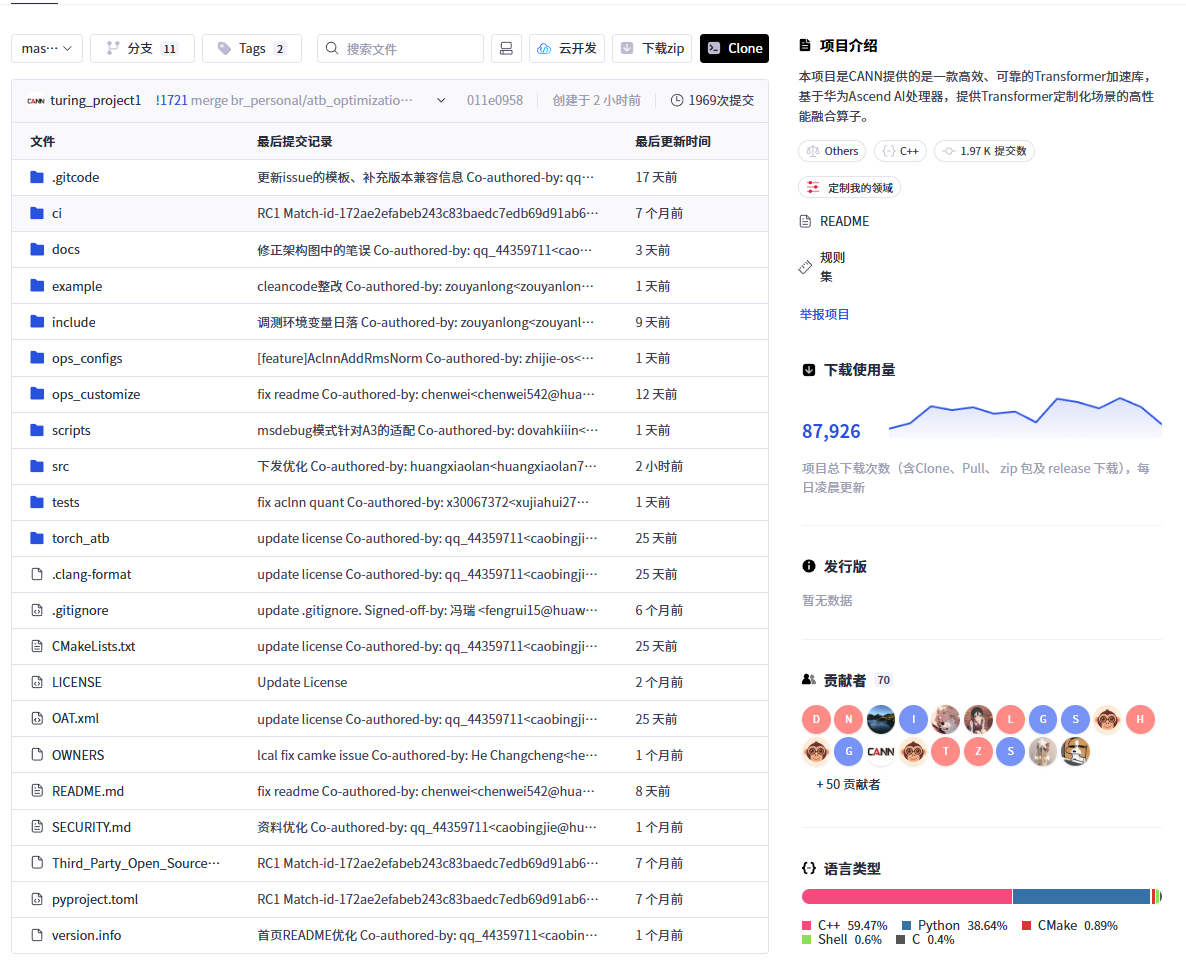

3.3 Transformer 专用加速:ascend-transformer-boost

ascend-transformer-boost

描述: “基于华为 Ascend AI 处理器,提供 Transformer 定制化场景的高性能融合算子。”

-

- 针对 Attention 机制(QKV 投影、Softmax、Out Linear)进行深度融合;

- 支持 FlashAttention 类优化,减少 HBM 访问;

- 适用于 Llama、ChatGLM、Qwen 等主流大模型。

这是 CANN 场景化优化 的典范,直接服务于当前最热门的大模型推理需求。

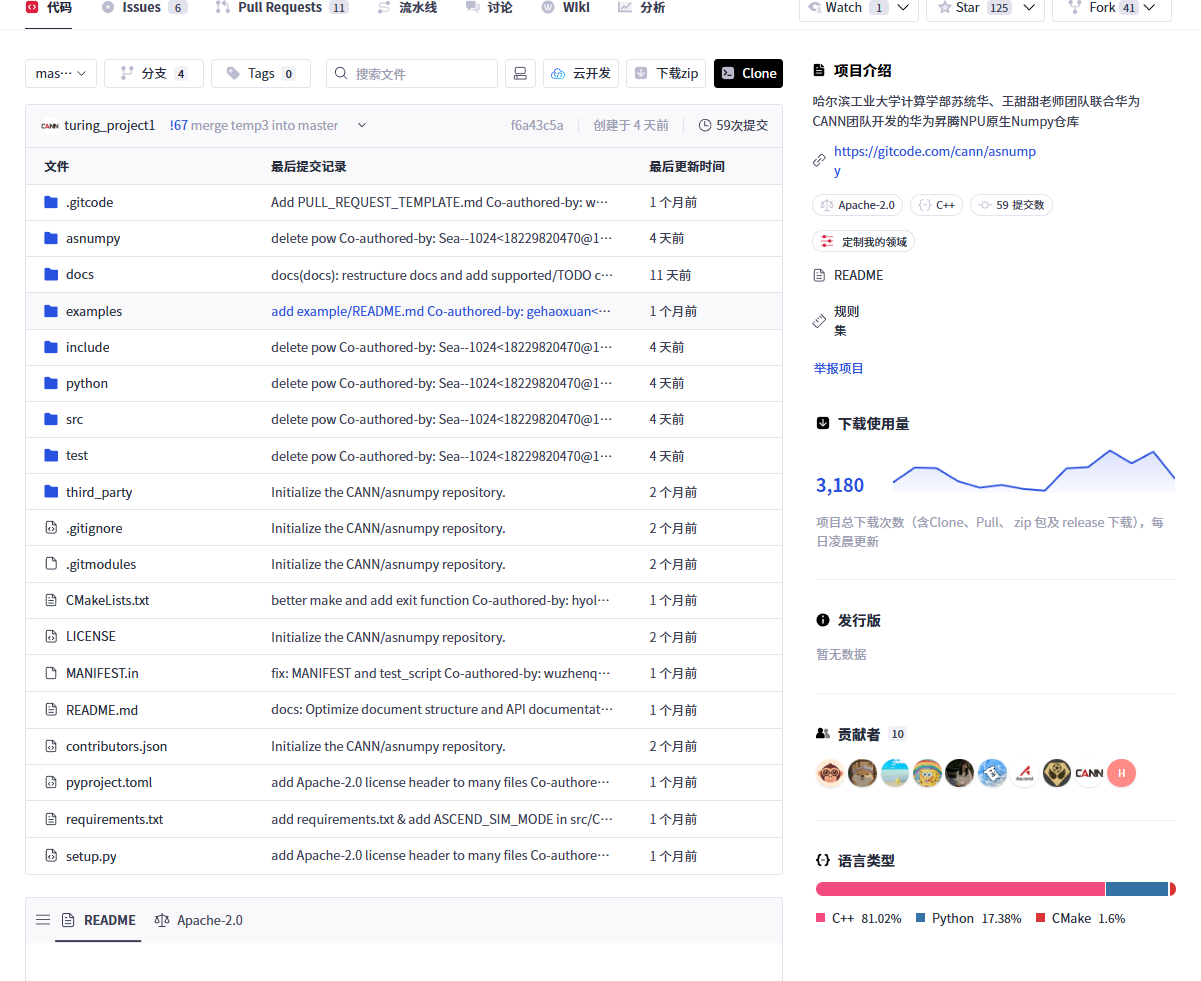

3.4 NPU 原生 NumPy:asnumpy

asnumpy

描述: “哈尔滨工业大学联合华为 CANN 团队开发的华为昇腾 NPU 原生 Numpy 仓库”

-

- 提供类似 NumPy 的 API(如

asnp.array,asnp.matmul); - 数据默认驻留在 NPU 显存,避免 Host-Device 频繁拷贝;

- 支持自动图优化与懒执行(Lazy Evaluation)。

- 提供类似 NumPy 的 API(如

该项目极大降低了 科学计算与原型开发 在 NPU 上的门槛,是 Python 开发者友好型入口。

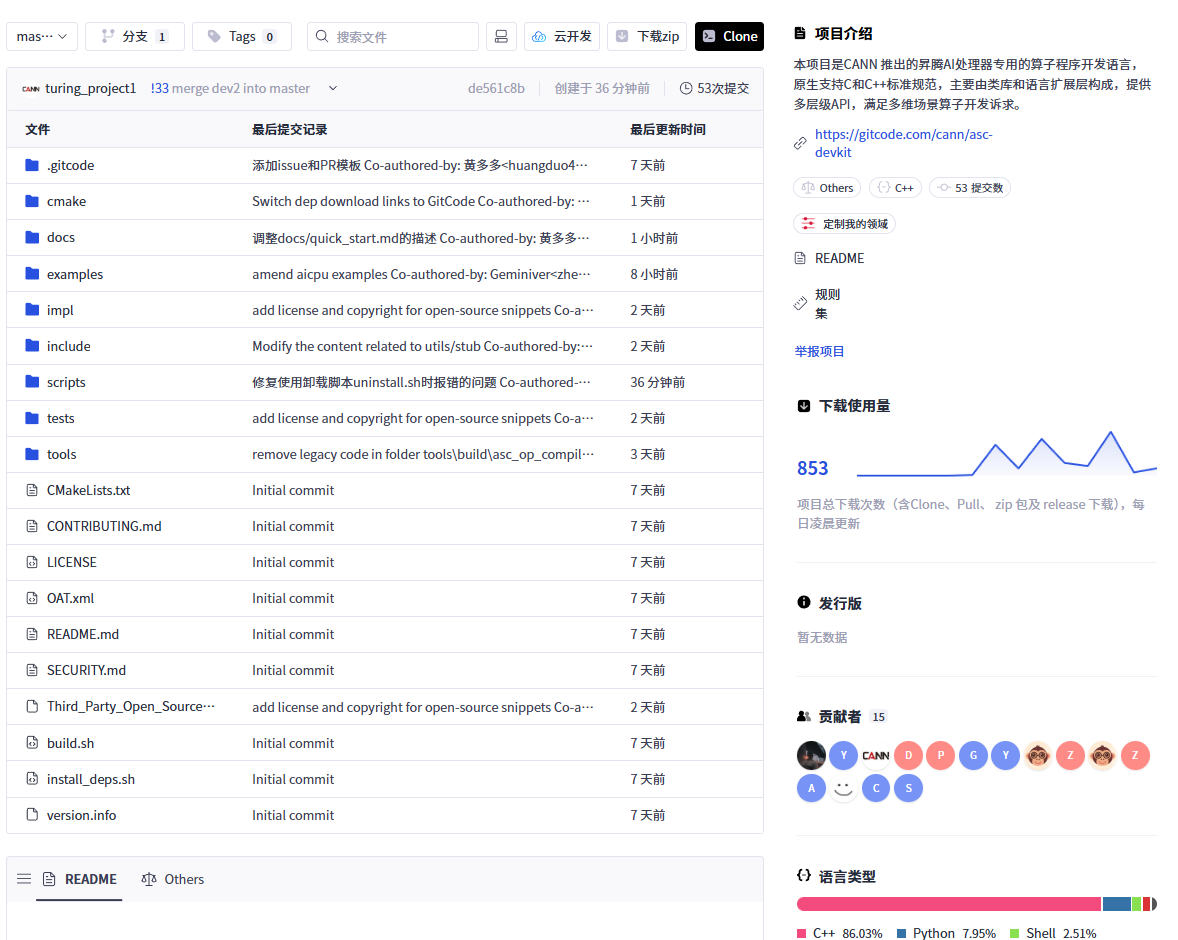

3.5 算子开发语言与工具链:asc-devkit

asc-devkit

描述: “CANN 推出的昇腾 AI 处理器专用的算子程序开发语言,原生支持 C/C++ 标准,提供多层级 API。”

-

- 包含编译器前端、IR 表示、调度器、代码生成器;

- 支持从 C++ 直接编写高性能 Kernel;

- 提供调试符号、性能计数器注入等开发辅助功能。

该仓库是 CANN 自主可控工具链 的核心体现,对标 NVIDIA 的 NVCC + PTX。

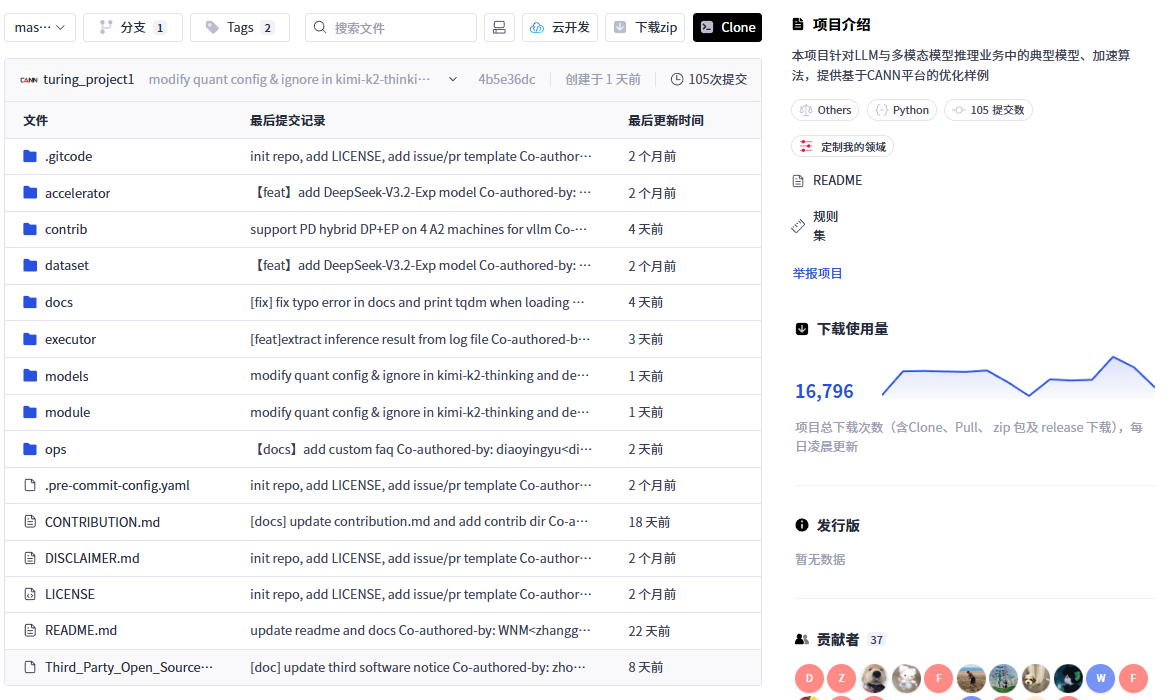

3.6 推理优化样例:cann-recipes-infer

cann-recipes-infer

描述: “针对 LLM 与多模态模型推理业务中的典型模型、加速算法,提供基于 CANN 平台的优化样例。”

-

- 包含 LLaMA、Stable Diffusion、Whisper 等模型的部署脚本;

- 展示如何结合

ascend-transformer-boost、asnumpy、ops-nn实现端到端加速; - 提供吞吐/延迟对比数据与调优建议。

这是 最佳实践集合,帮助用户快速复现工业级性能。

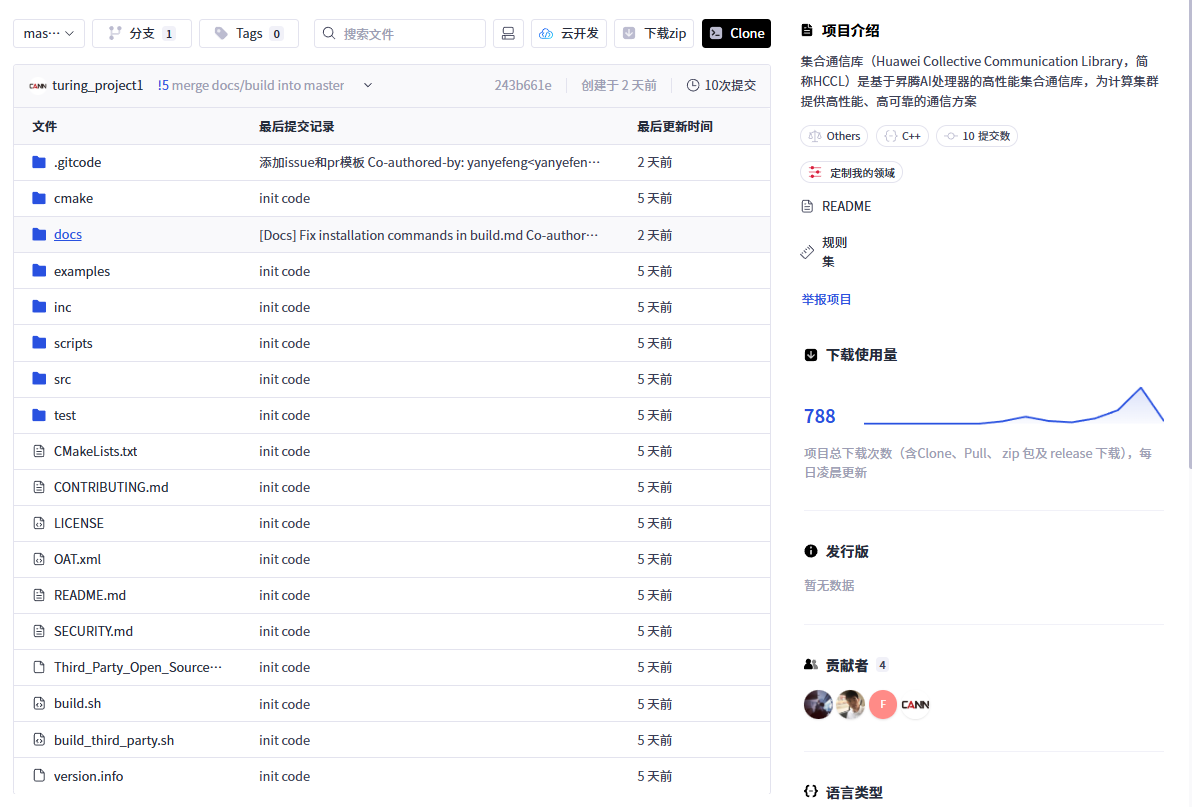

3.7 集合通信库:hccl

hccl

描述: “Huawei Collective Communication Library,基于昇腾 AI 处理器的高性能集合通信库。”

-

- 实现 AllReduce、AllGather、Broadcast 等通信原语;

- 深度优化 RoCE 网络与 PCIe 拓扑;

- 与 MindSpore、PyTorch(通过适配器)集成,支撑千卡训练。

HCCL 是 CANN 分布式能力 的关键组件,对标 NCCL。

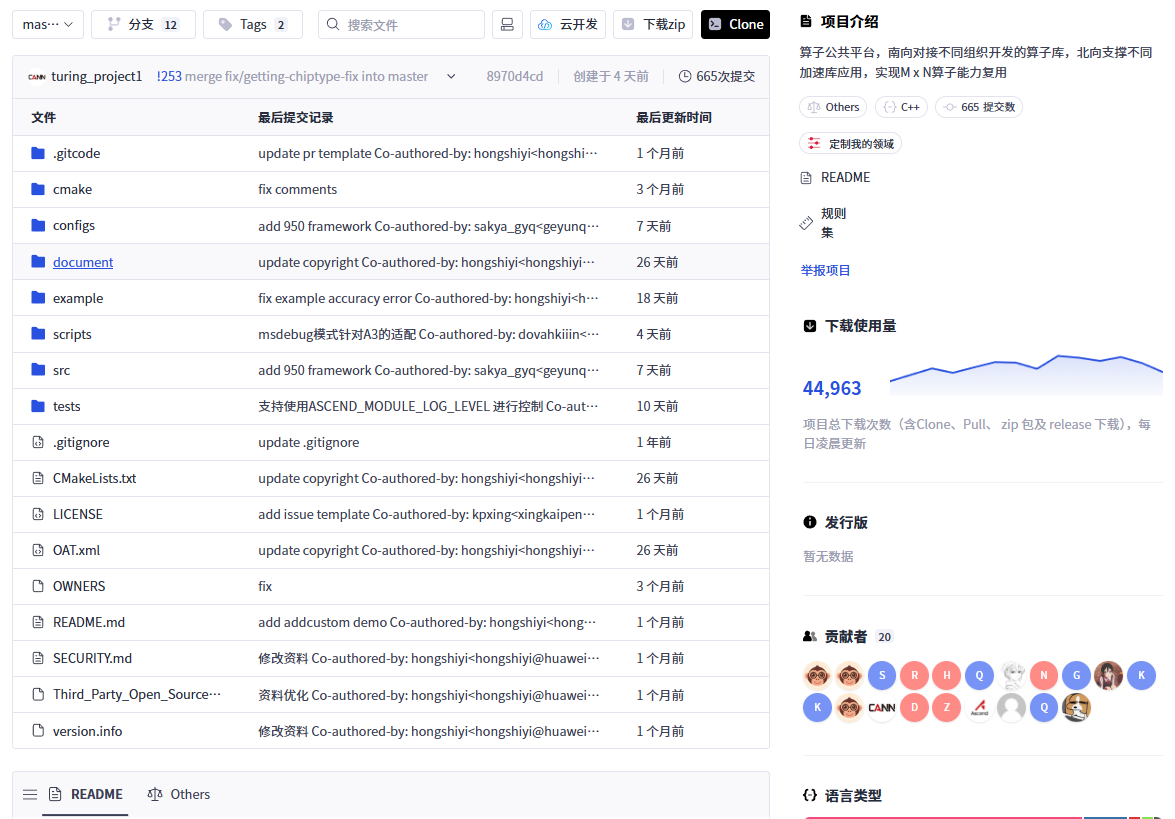

3.8 算子公共平台:ascend-boost-comm

ascend-boost-comm

描述: “算子公共平台,南向对接不同组织开发的算子库,北向支撑不同加速库应用,实现 M×N 算子能力复用。”

-

- 充当 算子中间件,解耦算子实现与应用场景;

- 支持插件式加载

ops-nn、catlass、第三方算子; - 提供统一注册、查询、调度接口。

该设计显著提升了 CANN 生态的 可扩展性与复用性。

3.9 社区治理:community

community

描述: “CANN 开源社区的核心管理仓库,包含治理章程、组织架构、操作指引等。”

-

- 定义贡献流程、代码规范、版本发布策略;

- 公开 SIG(Special Interest Group)列表与会议纪要;

- 是社区健康发展的制度保障。

技术栈全景图

协作机制与社区参与

CANN 在 GitCode 上建立了完整的 开源协作流程:

- Issue 跟踪:用于 Bug 报告、功能请求;

- Pull Request:代码贡献需通过 CI 测试与 Review;

- 看板管理:公开 Roadmap 与任务进度;

- 算力激励:社区公告中提及“免费领算力”,鼓励大家提交高质量 PR。

除了这些,CANN 团队还提供 迁移指引,帮助原 Gitee 用户同步历史贡献数据,确保社区连续性。

总结

CANN 开源仓通过 模块化设计、清晰的功能边界、完善的工具链与文档体系,构建了一个专业且友好的 AI 基础软件生态。

未来,随着大模型、边缘 AI、多模态等场景的发展,CANN 有望进一步扩展其 分布式训练支持、量化压缩工具、安全可信计算 等能力。而 GitCode 作为其主阵地,将持续承载这一技术演进与生态繁荣。本文章参考了“昇腾PAE案例库”。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)