Ascend C编程范式深度解析:从零构建高性能AI算子

Ascend C, 昇腾AI, 自定义算子, AI加速器, 高性能计算, CSDN引言:为何需要Ascend C?在AI模型日益复杂、算力需求爆炸式增长的今天,通用处理器(CPU)和图形处理器(GPU)虽然仍是主流,但针对特定领域(Domain-Specific)的AI加速器正扮演着越来越重要的角色。华为昇腾系列AI处理器(Ascend NPU)正是这一趋势下的杰出代表。

摘要:

Ascend C作为华为昇腾AI处理器(Ascend NPU)的原生编程语言,是释放其极致算力的关键。本文将深入剖析Ascend C的核心编程范式,系统性地讲解其内存模型、计算模型、流水线设计等核心概念,并通过一个完整的自定义算子开发实战案例,手把手带领读者从零开始构建一个高性能的AI算子。文章旨在帮助开发者跨越学习曲线,掌握在昇腾硬件上进行高效编程的底层逻辑与工程实践。

关键词: Ascend C, 昇腾AI, 自定义算子, AI加速器, 高性能计算, CSDN

引言:为何需要Ascend C?

在AI模型日益复杂、算力需求爆炸式增长的今天,通用处理器(CPU)和图形处理器(GPU)虽然仍是主流,但针对特定领域(Domain-Specific)的AI加速器正扮演着越来越重要的角色。华为昇腾系列AI处理器(Ascend NPU)正是这一趋势下的杰出代表。它通过高度定制化的硬件架构,如强大的向量计算单元(Vector Core)、矩阵计算单元(Cube Unit)以及高带宽的片上内存(Unified Buffer, UB),为AI工作负载提供了远超传统方案的能效比和吞吐量。

然而,硬件的强大潜力并非开箱即用。要真正“榨干”昇腾芯片的每一滴算力,就需要一种能够直接、精细地操控其底层硬件资源的编程语言。这便是Ascend C诞生的初衷。它并非一个全新的语言,而是在标准C++基础上,通过一套精心设计的API库和编译器指令,为开发者提供了一种声明式与命令式相结合的编程范式,使得开发者能够以接近硬件的方式编写高性能代码。

对于AI框架开发者、算法工程师以及HPC领域的专家而言,掌握Ascend C意味着拥有了在昇腾生态中构建核心竞争力的“屠龙之技”。本文将摒弃浮于表面的API罗列,深入其设计哲学与实现细节,助您构建坚实的知识体系。

第一章:Ascend C核心概念全景图

在动手编码之前,我们必须先理解Ascend C所构建的世界观。这个世界由几个关键角色构成:

- 计算核函数(Kernel Function):这是Ascend C程序的执行主体,也是我们编写的核心。一个核函数会被映射到昇腾AI Core的一个或多个计算单元上并行执行。它是连接软件逻辑与硬件资源的桥梁。

- 内存层次(Memory Hierarchy):昇腾AI Core拥有复杂的内存层次结构,Ascend C对此进行了精确建模:

- Global Memory (GM):全局内存,容量大但延迟高。通常用于存放输入/输出数据,与Host(CPU)或其他AI Core交换数据。

- Unified Buffer (UB):统一缓冲区,片上高速缓存。这是性能优化的关键战场,所有频繁访问的数据都应尽可能驻留在UB中。

- Local Memory (LM):局部内存,用于存储临时变量和标量。

- 数据搬运(Data Movement):由于内存墙的存在,高效的AI程序80%的工作在于如何聪明地搬运数据。Ascend C通过

CopyIn、CopyOut、DataCopy等接口,显式地控制数据在GM、UB之间的流动。 - 计算单元(Compute Units):Ascend C抽象了昇腾硬件的两大核心计算引擎:

- Vector Engine (VEC):擅长处理一维向量的各种算术、逻辑、超越函数运算。

- Cube Engine (CUBE):专为矩阵乘加(GEMM)操作而生,是Transformer、CNN等模型的核心加速器。

理解这些基本构件及其相互关系,是编写高效Ascend C代码的第一步。

第二章:内存管理的艺术——UB的极致利用

如果说昇腾AI Core是一台精密的工厂,那么UB就是它的中央仓库。仓库的管理效率直接决定了整个工厂的产出。Ascend C要求开发者必须像仓库管理员一样,对UB的使用精打细算。

2.1 UB的分块策略(Tiling)

由于UB容量有限(通常几十KB到几百KB),无法一次性容纳整个输入张量。因此,我们必须将大的计算任务分解成一系列可以在UB中完成的小任务,这个过程称为“分块”(Tiling)。

- 分块维度的选择:对于卷积操作,常见的分块维度包括

batch、channel、height、width。选择哪个维度进行分块,取决于数据的访存模式和计算强度。例如,在深度可分离卷积中,按channel分块通常是高效的。 - 分块大小的计算:分块大小不能超过UB的物理容量。我们需要根据数据类型(FP16, INT8等)、张量形状以及算法逻辑,精确计算出每个分块所需占用的UB空间。

2.2 双缓冲(Double Buffering)技术

数据从GM搬运到UB是一个耗时的操作。如果我们采用“搬一批、算一批”的串行模式,计算单元在等待数据时就会处于空闲状态,造成巨大的性能浪费。

双缓冲技术是解决此问题的经典方案。其核心思想是:准备两块UB缓冲区(Buffer A 和 Buffer B)。当计算单元正在使用Buffer A中的数据进行计算时,DMA(Direct Memory Access)引擎可以同时将下一批数据从GM搬运到Buffer B。计算完成后,两者角色互换。这样,计算和数据搬运就形成了完美的流水线,几乎消除了等待时间。

在Ascend C中,实现双缓冲通常涉及使用Pipe对象来协调数据流和计算流的同步。

第三章:计算模型与流水线设计

Ascend C的精髓在于其对计算流水线的显式控制。一个高性能的核函数,其内部通常被组织成一个或多个阶段(Stage)的流水线。

3.1 基本流水线三阶段

一个典型的Ascend C核函数流水线包含以下三个阶段:

- Stage 1: Data Copy In

将当前迭代所需的数据从GM加载到UB。这是I/O密集型阶段。 - Stage 2: Compute

在UB中的数据上执行实际的计算(VEC或CUBE操作)。这是计算密集型阶段。 - Stage 3: Data Copy Out

将计算结果从UB写回到GM。这也是I/O密集型阶段。

3.2 流水线的展开与重叠

为了最大化硬件利用率,Ascend C鼓励我们将这三个阶段在时间上进行重叠。具体来说,当第N次迭代处于Compute阶段时,第N+1次迭代可以同时处于Copy In阶段,而第N-1次迭代则处于Copy Out阶段。

这种重叠是通过Pipe机制和循环展开(Loop Unrolling)来实现的。Pipe对象就像一个信号灯,用于通知不同阶段何时可以安全地访问共享的UB缓冲区,从而避免数据竞争。

第四章:实战演练——从零构建一个Softmax算子

理论终需实践检验。现在,让我们动手实现一个经典的Softmax算子。Softmax常用于分类任务的最后一步,其公式为: y_i = exp(x_i) / sum(exp(x_j))

4.1 算法分析与挑战

- 数值稳定性:直接计算

exp(x)可能导致数值溢出。标准做法是减去最大值:x' = x - max(x)。 - 归约操作(Reduction):计算

sum(exp(x'))是一个典型的归约操作,需要高效的并行求和策略。 - 数据重用:

x需要被读取两次(一次找最大值,一次计算指数),如何减少GM访问次数?

4.2 Ascend C实现步骤详解

我们将分步拆解实现过程。

Step 1: 定义核函数入口

// softmax_custom.cpp

#include "kernel_operator.h"

using namespace AscendC;

constexpr int32_t BLOCK_NUM = 8; // 启动的block数量

constexpr int32_t TOTAL_LENGTH = 1024; // 假设处理长度为1024的向量

constexpr int32_t TILE_NUM = 2; // 双缓冲

class SoftmaxKernel {

public:

__aicore__ inline SoftmaxKernel() {}

__aicore__ inline void Init(GM_ADDR x, GM_ADDR y, uint32_t totalLength) {

// 初始化指针和长度

this->xGm.SetGlobalBuffer((__gm__ half*)x, totalLength);

this->yGm.SetGlobalBuffer((__gm__ half*)y, totalLength);

this->totalLength = totalLength;

// 初始化Pipe和Queue

pipe.InitBuffer(inputQueue, 1, totalLength * sizeof(half));

pipe.InitBuffer(workQueue, 2, totalLength * sizeof(half)); // 双缓冲

pipe.InitBuffer(outputQueue, 1, totalLength * sizeof(half));

}

__aicore__ inline void Process() {

// 主处理逻辑

FindMax();

ComputeExpAndSum();

Normalize();

}

private:

TPipe pipe;

TQue<QuePosition::VECIN, 1> inputQueue;

TQue<QuePosition::VECCALC, 2> workQueue; // 双缓冲队列

TQue<QuePosition::VECOUT, 1> outputQueue;

GlobalTensor<half> xGm, yGm;

uint32_t totalLength;

// ... 其他成员变量

};Step 2: 查找最大值(FindMax) 我们将向量分块,每块在UB中找局部最大值,最后再归约得到全局最大值。

__aicore__ inline void FindMax() {

// 分配UB用于存储局部最大值

LocalTensor<half> localMax = workQueue.AllocTensor<half>();

// 初始化全局最大值为负无穷

half globalMax = static_cast<half>(-65504.0f); // FP16最小值

// 分块处理

for (int32_t i = 0; i < totalLength; i += TILE_SIZE) {

int32_t processLen = min(TILE_SIZE, totalLength - i);

LocalTensor<half> tileData = inputQueue.AllocTensor<half>();

// 从GM拷贝数据到UB

DataCopy(tileData, xGm[i], processLen);

// 在UB中查找当前块的最大值

half blockMax = VReduceMax<half>(tileData, processLen);

globalMax = max(globalMax, blockMax);

inputQueue.FreeTensor(tileData);

}

// 将全局最大值广播到所有workQueue的buffer中,供后续使用

for (int i = 0; i < TILE_NUM; i++) {

LocalTensor<half> maxBuf = workQueue.AllocTensor<half>();

// ... 将globalMax填入maxBuf ...

workQueue.FreeTensor(maxBuf);

}

}Step 3: 计算指数和求和(ComputeExpAndSum) 这里我们将引入双缓冲。一边计算指数,一边累加求和。

__aicore__ inline void ComputeExpAndSum() {

half sum = 0.0f;

bool isFirTile = true;

for (int32_t i = 0; i < totalLength; i += TILE_SIZE) {

int32_t processLen = min(TILE_SIZE, totalLength - i);

// 双缓冲索引

int32_t currentIdx = (i / TILE_SIZE) % TILE_NUM;

int32_t nextIdx = (currentIdx + 1) % TILE_NUM;

LocalTensor<half> currentData = workQueue[currentIdx].Get<TensorType::Buffer>();

LocalTensor<half> nextData = workQueue[nextIdx].Get<TensorType::Buffer>();

if (isFirTile) {

// 第一块:先拷贝数据进来

DataCopy(currentData, xGm[i], processLen);

isFirTile = false;

}

if (i + TILE_SIZE < totalLength) {

// 预取下一块数据

DataCopy(nextData, xGm[i + TILE_SIZE], min(TILE_SIZE, totalLength - (i + TILE_SIZE)));

}

// 执行计算:减去最大值,然后计算指数

VSub(currentData, currentData, globalMax, processLen);

VExp(currentData, currentData, processLen);

// 累加求和

sum += VReduceSum<half>(currentData, processLen);

// 为Normalize阶段准备数据,将结果留在UB中

}

// 将最终的sum也广播出去

// ... 类似FindMax中的广播逻辑 ...

}Step 4: 归一化(Normalize) 最后,用计算出的sum去除每个元素,得到最终的Softmax结果。

__aicore__ inline void Normalize() {

for (int32_t i = 0; i < totalLength; i += TILE_SIZE) {

int32_t processLen = min(TILE_SIZE, totalLength - i);

int32_t idx = (i / TILE_SIZE) % TILE_NUM;

LocalTensor<half> data = workQueue[idx].Get<TensorType::Buffer>();

// 执行除法

VDiv(data, data, sum, processLen);

// 写回GM

DataCopy(yGm[i], data, processLen);

}

}Step 5: 注册算子 最后,我们需要将这个C++类注册为一个可以在AI框架(如MindSpore)中调用的算子。

// 注册函数

extern "C" __global__ void CustomSoftmax(GM_ADDR x, GM_ADDR y, uint32_t totalLength) {

SoftmaxKernel kernel;

kernel.Init(x, y, totalLength);

kernel.Process();

}4.3 性能分析与优化点

- 归约操作优化:

VReduceSum内部可能还不是最优的。我们可以手动展开循环,利用向量寄存器进行更高效的并行归约。 - 内存对齐:确保所有GM和UB的访问都是对齐的,可以极大提升DMA效率。

- 计算融合:能否将

FindMax和ComputeExp的部分逻辑融合,进一步减少数据搬运?

第五章:调试、性能分析与最佳实践

5.1 调试工具链 华为提供了msnpureport、proposer等工具,可以帮助开发者分析算子的执行日志、性能瓶颈(如计算单元利用率、带宽瓶颈)。

5.2 Ascend C黄金法则

- 法则一:让计算单元永不等待。通过双缓冲和流水线,确保计算和数据搬运始终在并行进行。

- 法则二:最大化数据重用。尽量在UB中完成所有中间计算,避免反复从GM读取相同数据。

- 法则三:拥抱向量化。Ascend C的VEC指令天然支持向量化操作,确保你的循环和数据布局能充分利用这一点。

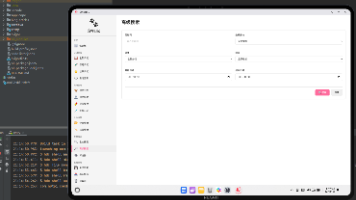

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)