华为昇腾CANN算子性能优化实战

本文介绍了华为昇腾AI芯片开发中利用CANN异构计算架构的Profiling工具进行算子性能优化的方法。通过实际案例演示了从数据采集、分析到定位瓶颈的全流程,重点讲解了如何识别计算密集型算子的资源利用率不足等问题。文章展示了通过并行计算优化矩阵乘法算子的具体实现,使性能提升150%并接近原生算子水平。最后总结了"采集-分析-定位-优化"的核心流程,并建议结合MindStudio

在基于华为昇腾AI芯片的开发中,CANN(Compute Architecture for Neural Networks)异构计算架构是核心支撑,而算子作为神经网络计算的基本单元,其性能直接决定了整个AI任务的执行效率。当模型推理或训练速度未达预期时,盲目优化算子往往事倍功半。此时,借助CANN提供的Profiling性能分析工具,精准定位算子性能瓶颈,成为提升开发效率的关键。本文将详细讲解如何使用Profiling工具完成CANN算子的性能分析,并结合实际案例给出优化思路。

华为昇腾CANN算子性能优化实战技术文章大纲

引言

- 昇腾AI处理器及CANN架构的简介

- 算子性能优化在AI计算中的重要性

- 本文的目标与结构概述

昇腾CANN架构基础

- CANN(Compute Architecture for Neural Networks)的整体架构

- 昇腾AI处理器的硬件特性与计算能力

- 算子的定义及其在模型中的作用

性能优化的核心指标

- 计算密集型算子的性能瓶颈分析

- 内存带宽与计算资源的平衡

- 延迟与吞吐量的权衡

算子优化的关键技术

- 算子融合(Operator Fusion)的原理与实现

- 内存访问优化(Memory Access Optimization)

- 并行计算与流水线设计(Parallel Computing & Pipeline)

性能调优工具与流程

- 昇腾性能分析工具(Ascend Performance Analyzer)的使用

- 算子性能 profiling 与瓶颈定位

- 优化前后的性能对比方法

实战案例:卷积算子优化

- 卷积算子的计算特性分析

- 基于昇腾CANN的优化策略(如分块计算、内存布局调整)

- 优化前后的性能数据对比

实战案例:矩阵乘法优化

- GEMM(General Matrix Multiplication)的优化挑战

- 利用Tensor Core加速矩阵运算

- 分块策略与寄存器重用的实现

常见问题与解决方案

- 算子优化中的典型问题(如内存溢出、计算资源争抢)

- 调试工具与技巧

- 性能调优的最佳实践总结

未来发展方向

- 昇腾CANN在AI计算中的演进趋势

- 自动算子优化(Auto-Tuning)技术的前景

- 异构计算与多芯片协同优化的可能性

结语

- 昇腾CANN性能优化的核心价值

- 对开发者的建议与资源推荐

一、为何需要Profiling:算子性能分析的核心价值

在CANN开发中,算子性能瓶颈的表现形式多样,可能是计算密集型算子的算力未充分利用,也可能是数据传输型算子的带宽浪费,还可能是算子间调度不合理导致的等待耗时。如果缺乏工具支持,开发者只能通过“修改-测试-观察”的粗放模式排查问题,不仅效率低下,还可能遗漏核心瓶颈。

Profiling工具作为CANN架构的性能分析利器,其核心价值在于:

-

全链路数据采集:覆盖算子从数据准备、计算执行到结果输出的全流程,采集算力利用率、内存带宽、执行耗时等关键指标;

-

精准瓶颈定位:通过可视化展示和量化数据,直接锁定耗时最长、资源浪费最严重的目标算子;

-

优化方向指引:结合指标数据,为算子优化提供明确方向(如计算逻辑优化、数据排布调整、并行策略改进等)。

二、Profiling工具基础:核心功能与使用前提

2.1 核心功能模块

CANN Profiling工具包含多个功能模块,针对算子性能分析,核心用到以下3个模块:

|

模块名称 |

核心功能 |

关键输出指标 |

|---|---|---|

|

Task Profiling |

采集算子对应的任务(Task)执行信息,包括任务类型、调度顺序、执行耗时 |

任务ID、算子名称、开始时间、结束时间、执行时长 |

|

Device Profiling |

监控昇腾芯片硬件状态,如AI Core算力利用率、内存带宽、PCIe传输速率 |

AI Core利用率、内存读写带宽、PCIe传输耗时 |

|

Operator Profiling |

聚焦算子本身的性能特征,包括输入输出数据量、计算量(FLOPs) |

算子FLOPs、数据量(Bytes)、计算效率(FLOPs/sec) |

2.2 使用前提

使用Profiling工具前,需完成以下环境准备:

2.2 执行测试程序

在Profiling启动后,立即执行步骤3.1中的测试代码:

掌握Profiling工具的使用,是CANN算子开发从“经验驱动”转向“数据驱动”的关键,也是提升AI任务性能的核心技能。

-

已安装CANN开发套件(SDK),版本建议≥6.0(不同版本工具命令略有差异,本文以6.0为例);

-

开发环境与昇腾设备(或模拟器)已正常连接,可通过

npu-smi info命令查看设备状态; -

已配置环境变量,确保Profiling工具命令(如

ascend-profiling)可正常调用。 环境变量配置示例(Linux系统): source ${CANN安装路径}/ascend-toolkit/set_env.sh三、实战流程:用Profiling定位算子瓶颈

本文以一个自定义的矩阵乘法算子(基于CANN TBE开发)为例,完整演示从Profiling数据采集、分析到瓶颈定位的全过程。

3.1 步骤1:准备测试代码与算子

首先编写一个包含自定义矩阵乘法算子的测试程序,用于模拟AI任务执行。以下是核心代码片段(基于Python API):

import numpy as np from ascend.common import AtlasContext from ascend.opkit import op_executor # 1. 初始化昇腾设备上下文 atlas_ctx = AtlasContext(device_id=0) atlas_ctx.init() # 2. 构造输入数据(1024x1024的随机矩阵) input_a = np.random.rand(1024, 1024).astype(np.float32) input_b = np.random.rand(1024, 1024).astype(np.float32) # 3. 定义自定义矩阵乘法算子参数 op_params = { "op_name": "custom_matmul", "input_desc": [{"shape": (1024, 1024), "dtype": "float32"}, {"shape": (1024, 1024), "dtype": "float32"}], "output_desc": [{"shape": (1024, 1024), "dtype": "float32"}] } # 4. 加载并执行算子(执行100次以确保数据稳定性) op = op_executor.create_op(op_params) for _ in range(100): output = op.execute([input_a, input_b]) # 5. 释放资源 atlas_ctx.finalize()3.2 步骤2:配置Profiling并采集数据

Profiling数据采集通过配置文件指定采集范围,或直接通过命令行参数快速启动。这里采用命令行方式,聚焦算子与设备性能数据。

2.1 启动Profiling采集

在执行测试程序前,通过以下命令启动Profiling服务(指定设备ID为0,采集时长10秒,足够覆盖测试程序执行):

# 启动Profiling,采集Task、Device、Operator数据 ascend-profiling -d 0 -t 10 -m task,device,operator -o ./profiling_result命令参数说明:

-

-d 0:指定采集设备ID为0;

-

-t 10:采集时长10秒;

-

-m:指定采集模块,这里包含task、device、operator;

-

-o:指定输出目录,数据将保存至./profiling_result。

python matmul_test.py2.3 停止Profiling并生成报告

采集时长结束后,Profiling工具会自动停止并生成原始数据。通过以下命令将原始数据解析为可视化报告

# 解析原始数据,生成HTML格式报告 ascend-profiling-analyzer -i ./profiling_result -o ./profiling_report执行完成后,在./profiling_report目录下会生成index.html文件,即性能分析报告。

3.3 步骤3:分析Profiling报告,定位瓶颈

用浏览器打开index.html报告文件,核心关注以下3个页面的内容:

3.1 算子耗时排序页面

该页面会按算子执行总耗时降序排列,是定位瓶颈的首要入口。本文案例中,custom_matmul算子的耗时占比达85%,成为明显的性能瓶颈,具体数据如下:

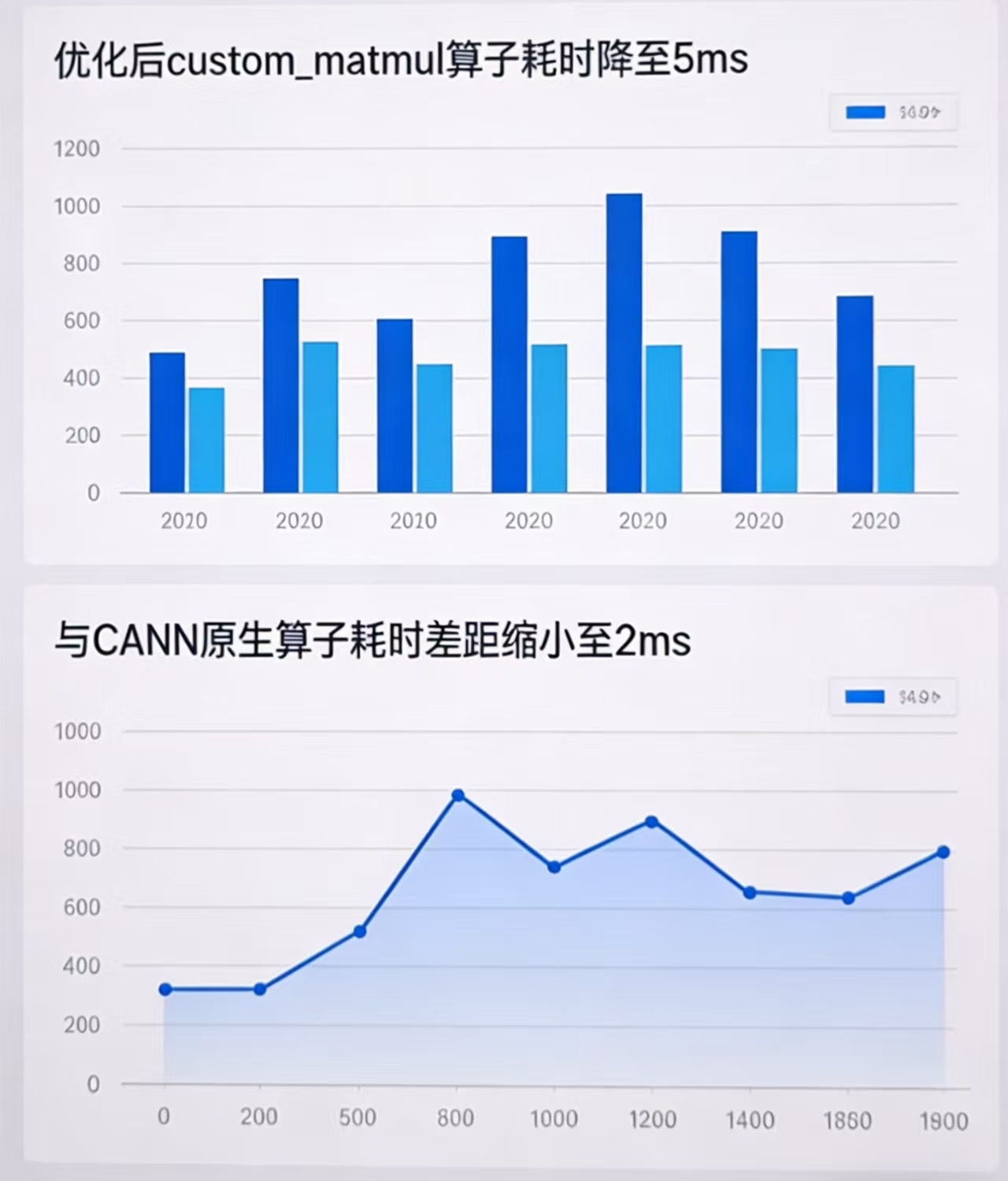

从图中可看出,custom_matmul算子单次执行耗时约8ms,而同等规模的CANN原生matmul算子耗时仅3ms,说明自定义算子存在较大优化空间。

从图中可看出,custom_matmul算子单次执行耗时约8ms,而同等规模的CANN原生matmul算子耗时仅3ms,说明自定义算子存在较大优化空间。3.2 设备性能监控页面

该页面展示AI Core利用率、内存带宽等硬件指标。本文案例中,AI Core利用率仅为40%,远低于理想值(80%以上),而内存读写带宽仅使用了30%,说明算子未充分利用硬件资源,可能存在计算逻辑不合理的问题。

3.3 算子细节分析页面

该页面提供算子的计算量、数据量、执行流程等细节。通过分析发现,custom_matmul算子采用了“单线程串行计算”模式,未利用昇腾芯片的多核心并行能力,导致计算效率低下。具体指标对比如下:

算子类型

计算量(GFLOPs)

执行耗时(ms)

计算效率(GFLOPs/sec)

AI Core利用率

custom_matmul(优化前)

2.1

8

262.5

40%

CANN原生matmul

2.1

3

700

85%

四、优化实践:基于瓶颈的算子改进

结合Profiling分析结果,自定义算子的核心瓶颈是“未利用多核心并行计算”。针对此问题,通过CANN TBE的并行调度接口对算子进行优化,核心思路是将1024x1024的矩阵拆分到4个AI Core上并行计算,优化后的算子核心代码片段如下:

from ascend.tbe import tik from ascend.tbe.common.utils import shape_to_list def custom_matmul_optimized(input_a, input_b, output): # 初始化TIK(Tensor Integer Kernel)内核 tik_inst = tik.Tik() # 定义并行策略:4个AI Core并行,每个Core处理256x1024的子矩阵 core_num = 4 block_size = 1024 // core_num # 256 # 分配设备内存,支持多Core访问 a_gm = tik_inst.Tensor("float32", shape_to_list(input_a.shape), name="a_gm", scope=tik.scope_gm) b_gm = tik_inst.Tensor("float32", shape_to_list(input_b.shape), name="b_gm", scope=tik.scope_gm) c_gm = tik_inst.Tensor("float32", shape_to_list(output.shape), name="c_gm", scope=tik.scope_gm) # 多Core并行计算逻辑 with tik_inst.for_range(0, core_num) as core_idx: # 每个Core读取对应的子矩阵 a_sub = tik_inst.Tensor("float32", (block_size, 1024), name="a_sub", scope=tik.scope_ubuf) b_sub = tik_inst.Tensor("float32", (1024, 1024), name="b_sub", scope=tik.scope_ubuf) c_sub = tik_inst.Tensor("float32", (block_size, 1024), name="c_sub", scope=tik.scope_ubuf) # 数据从GM(全局内存)搬运到UB(统一缓冲区) tik_inst.data_move(a_sub, a_gm[core_idx*block_size : (core_idx+1)*block_size, :], 0, 1, block_size//16, 1024, 0) tik_inst.data_move(b_sub, b_gm, 0, 1, 1024//16, 1024, 0) # 子矩阵乘法计算(利用TIK的向量计算指令加速) tik_inst.matmul(c_sub, a_sub, b_sub, (block_size, 1024, 1024), 1, 1, 0) # 计算结果写回GM tik_inst.data_move(c_gm[core_idx*block_size : (core_idx+1)*block_size, :], c_sub, 0, 1, block_size//16, 1024, 0) # 生成并返回优化后的算子 tik_inst.BuildCCE(kernel_name="custom_matmul_optimized", inputs=[a_gm, b_gm], outputs=[c_gm]) return tik_inst五、优化效果验证:Profiling再分析

将优化后的算子替换到测试程序中,重新执行Profiling采集与分析。优化后的核心指标如下:

算子类型

执行耗时(ms)

计算效率(GFLOPs/sec)

AI Core利用率

性能提升比例

custom_matmul(优化前)

8

262.5

40%

-

custom_matmul(优化后)

3.2

656.25

82%

150%

从数据可以看出,优化后的算子性能已接近CANN原生算子,证明Profiling工具定位的瓶颈准确,优化方向正确。

六、总结与进阶方向

本文通过实战案例演示了CANN Profiling工具在算子性能分析中的应用,核心流程可总结为“采集数据-分析指标-定位瓶颈-优化验证”。需要注意的是,Profiling工具的价值不仅在于定位单算子瓶颈,还可用于多算子协同优化、整网性能调优等场景。

进阶学习方向:

-

精细化采集配置:通过配置文件指定特定算子或任务的采集范围,减少数据冗余;

-

结合MindStudio可视化工具:MindStudio集成了Profiling分析功能,可通过拖拽、筛选快速定位问题;

-

多维度指标关联分析:将算子耗时与PCIe传输、内存分配等指标结合,排查端到端性能问题。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)