昇腾算子调试与性能分析:从问题定位到效率拉满

调试优先使用 “日志 + CPU 模拟”,复杂问题用 Ascend Debugger;性能分析以 Ascend Profiler 为核心,重点关注 AI Core 利用率和内存带宽;优化需 “对症下药”:内存瓶颈优化数据访问,计算瓶颈充分利用硬件单元。

在昇腾算子开发中,“能运行” 只是第一步,“跑得快、无 Bug” 才是最终目标。本文将聚焦算子开发的核心收尾环节 —— 调试与性能分析,详细讲解昇腾生态下的调试工具链、性能瓶颈定位方法及优化落地技巧,帮助你高效解决算子开发中的各类问题,实现性能极致提升。

一、算子开发的两大核心诉求:正确性与高效性

算子开发过程中,开发者需要同时满足两个核心诉求:

- 正确性:算子计算结果符合预期,无逻辑错误、数据越界等问题;

- 高效性:充分利用昇腾硬件资源(AI Core、内存带宽等),避免性能浪费。

这两个诉求对应两个关键环节:

- 调试:解决 “结果不对” 的问题,确保算子逻辑正确;

- 性能分析:解决 “跑得慢” 的问题,挖掘硬件潜力。

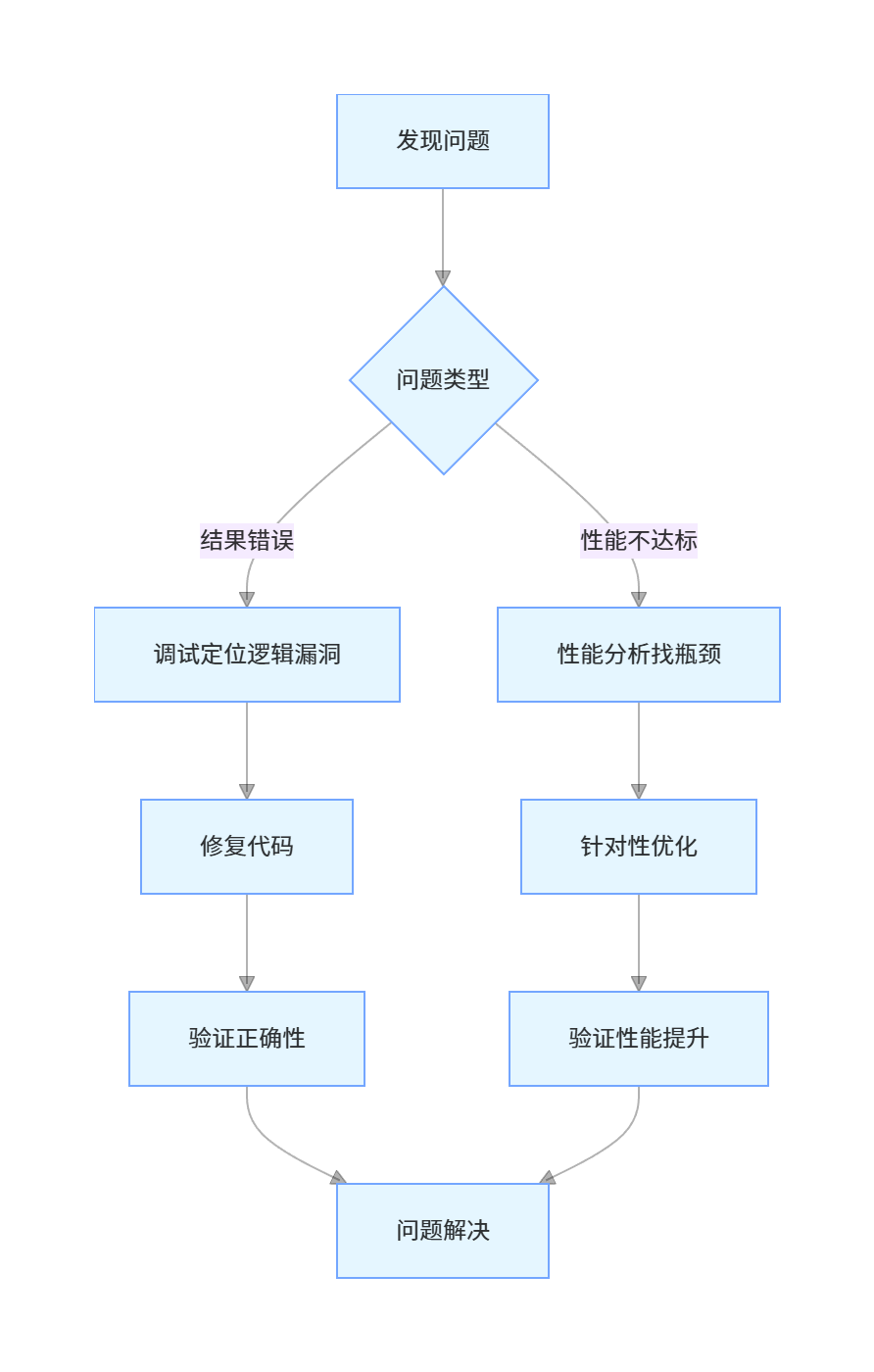

以下是算子开发的 “问题解决闭环”:

二、昇腾算子调试工具链:精准定位逻辑问题

昇腾提供了一套完整的调试工具链,覆盖 CPU 模拟调试、NPU 硬件调试等场景,核心工具包括Ascend Debugger、CPU/NPU 孪生调试及日志工具。

1. 日志调试:快速排查基础问题

日志是最基础也最常用的调试手段,通过打印关键信息(如变量值、线程索引),可快速定位简单逻辑错误。

(1)Ascend C 日志 API 使用

// 日志调试示例

#include "ascend_c_log_api.h"

__global__ void add_kernel(__global__ const float* a, __global__ const float* b, __global__ float* c, int len) {

int idx = threadIdx.x + blockIdx.x * blockDim.x;

LOG_DEBUG("thread idx: %d, a[idx]: %f, b[idx]: %f", idx, a[idx], b[idx]); // 打印线程索引与输入值

if (idx < len) c[idx] = a[idx] + b[idx];

LOG_DEBUG("thread idx: %d, c[idx]: %f", idx, c[idx]); // 打印输出值

}(2)日志级别配置

通过环境变量控制日志输出级别(从低到高:DEBUG < INFO < WARN < ERROR):

# 运行时配置日志级别为DEBUG

export ASCEND_C_LOG_LEVEL=DEBUG

./add_operator # 执行算子程序日志会输出到终端或指定文件,可通过日志中的变量值判断是否存在逻辑错误(如输入值异常、计算结果不符合预期)。

2. CPU/NPU 孪生调试:跨平台逻辑验证

昇腾支持CPU/NPU 孪生调试,即同一套代码可在 CPU 上模拟运行,也可在 NPU 上真实运行,通过对比两者结果,快速定位硬件相关的逻辑问题。

(1)CPU 模拟调试配置

// CPU模拟调试开关

#define CPU_SIMULATION 1

#if CPU_SIMULATION

#include "ascend_c_cpu_sim_api.h" // CPU模拟头文件

#else

#include "ascend_c_runtime_api.h" // NPU运行时头文件

#endif

int main() {

#if CPU_SIMULATION

ascendCpuSimInit(); // 初始化CPU模拟环境

#endif

// 算子调用逻辑(与NPU版本完全一致)

add_host(h_a, h_b, h_c, len);

#if CPU_SIMULATION

ascendCpuSimDestroy(); // 销毁CPU模拟环境

#endif

return 0;

}(2)调试流程

- 开启

CPU_SIMULATION,在 CPU 上运行算子,通过 GDB 等工具调试逻辑; - 关闭

CPU_SIMULATION,在 NPU 上运行算子; - 对比两者输出结果,若 CPU 上正确、NPU 上错误,大概率是硬件适配问题(如内存访问模式、线程索引计算)。

3. Ascend Debugger:硬件级断点调试

对于复杂的 NPU 硬件相关问题,需要使用Ascend Debugger(昇腾调试器),它支持在 NPU 上设置断点、查看寄存器状态、内存数据等,实现硬件级精准调试。

(1)调试流程示例

# 1. 编译时添加调试信息(-g选项)

ascend-gcc -g add_kernel.cu add_host.c -o add_debug -lascend_c_runtime

# 2. 启动Ascend Debugger

ascend-debugger ./add_debug

# 3. 设置断点(如在核函数入口处)

(ascend-debugger) break add_kernel # 断点设置在add_kernel函数入口

# 4. 运行程序

(ascend-debugger) run

# 5. 程序中断后,查看线程索引、内存数据

(ascend-debugger) print idx # 查看当前线程的全局索引

(ascend-debugger) x/10f a # 查看输入数组a的前10个元素(float类型)(2)核心调试功能

- 断点调试:支持在核函数、Host 侧函数中设置断点;

- 内存查看:查看 Device 侧 Global Memory、Local Memory 中的数据;

- 寄存器查看:查看 AI Core 的寄存器状态(如 Cube 单元、Vector 单元的运行状态);

- 线程控制:单步执行、跳过函数、终止线程等。

通过 Ascend Debugger,可精准定位 NPU 上的内存越界、线程索引错误、硬件单元调用异常等问题。

三、性能分析工具:找到算子的 “性能瓶颈”

算子性能不佳的原因有很多(如内存带宽瓶颈、计算单元利用率低、线程调度不合理等),需要通过昇腾性能分析工具链(核心工具:Ascend Profiler)找到瓶颈所在。

1. Ascend Profiler:全链路性能数据采集

Ascend Profiler 是昇腾生态的核心性能分析工具,支持采集算子运行过程中的各类性能数据,包括:

- 计算性能:AI Core 各单元(Cube、Vector、Scalar)的利用率;

- 内存性能:Global Memory 读写带宽、访问延迟;

- 调度性能:线程块启动时间、流执行效率。

(1)性能数据采集

bash

运行

# 1. 启动Profiler,指定输出目录

ascend-profiler --application ./add_operator --output ./profiler_result --duration 10 # 采集10秒内的性能数据

# 2. 执行算子程序(Profiler会自动采集数据)

./add_operator

# 3. 生成性能报告

ascend-profiler --report ./profiler_result --format html # 生成HTML格式报告

(2)性能报告核心指标解读

生成的 HTML 报告包含多个维度的性能数据,核心关注以下指标:

- AI Core 利用率:若低于 60%,说明计算单元未被充分利用;

- 内存带宽利用率:若接近 100%,说明内存是性能瓶颈;

- 算子执行时间:单个算子的总耗时,可对比不同优化版本的耗时变化。

2. 常见性能瓶颈与定位方法

(1)内存带宽瓶颈

- 现象:内存带宽利用率接近 100%,AI Core 利用率较低;

- 定位:通过 Profiler 查看 “Global Memory 读写吞吐量”,若已达到硬件上限,可判定为内存瓶颈;

- 示例:基础版 Add 算子因频繁访问 Global Memory,可能出现内存瓶颈。

(2)计算单元利用率低

- 现象:AI Core 利用率低于 50%,内存带宽利用率较低;

- 定位:查看 Cube、Vector 单元的利用率,若某单元利用率极低,说明该单元未被充分利用;

- 示例:基础版 Add 算子仅使用 Vector 单元,Cube 单元利用率为 0,存在计算资源浪费。

(3)线程调度不合理

- 现象:算子执行时间长,线程块启动耗时占比高;

- 定位:通过 Profiler 查看 “线程块启动延迟”,若延迟过高,说明线程配置不合理;

- 示例:线程块大小设为 32(过小),导致线程块数量过多,调度开销增大。

四、针对性优化:从瓶颈到高效

找到性能瓶颈后,需进行针对性优化。以下是常见瓶颈的优化方法及示例。

1. 内存带宽瓶颈优化:数据复用与内存对齐

(1)优化方法

- 利用 Local Memory 缓存数据,减少 Global Memory 访问次数;

- 确保数据地址按 32 字节对齐(昇腾硬件的内存访问要求)。

(2)优化代码示例

// 内存对齐与Local Memory复用优化

__global__ void add_mem_optim_kernel(__global__ const float* a, __global__ const float* b, __global__ float* c, int len) {

__local__ float local_a[256], local_b[256];

int tid = threadIdx.x;

// 对齐访问:确保地址是32字节倍数

int global_idx = (blockIdx.x * 256 + tid) * 8; // 8个float(32字节)为一组

local_a[tid] = a[global_idx]; // 批量加载到Local Memory

local_b[tid] = b[global_idx];

c[global_idx] = local_a[tid] + local_b[tid]; // 数据复用

}2. 计算单元利用率低优化:多单元协同计算

(1)优化方法

- 对于简单算子,尝试使用 Cube 单元参与计算(如 Add 算子的 Cube 适配版);

- 复杂算子(如卷积)拆分计算逻辑,让 Cube、Vector 单元协同工作。

(2)优化代码示例

// Cube+Vector单元协同计算(Add算子)

void add_multi_core_kernel(__global__ const float* a, __global__ const float* b, __global__ float* c, int len) {

CubeHandle cube_h;

VectorHandle vec_h;

cube_init(&cube_h, 1, len/2, 1); // Cube处理前半段数据

vector_init(&vec_h, len - len/2); // Vector处理后半段数据

cube_compute(cube_h, a, b, c, CUBE_OP_ADD); // Cube单元计算

vector_compute(vec_h, a+len/2, b+len/2, c+len/2, VECTOR_OP_ADD); // Vector单元计算

}3. 线程调度优化:合理配置线程块与网格大小

(1)优化原则

- 线程块大小推荐设为 256、512(昇腾硬件的最优线程块尺寸);

- 线程网格大小 = ceil (输入长度 / 线程块大小),确保线程全覆盖。

(2)优化代码示例

// 线程配置优化

void add_thread_optim_host(float* h_a, float* h_b, float* h_c, int len) {

dim3 block(512); // 线程块大小设为512(最优值)

dim3 grid((len + block.x - 1) / block.x); // 网格大小自适应

add_kernel<<<grid, block>>>(d_a, d_b, d_c, len); // 启动核函数

}4. 优化效果验证

通过 Ascend Profiler 再次采集性能数据,对比优化前后的指标:

| 优化方向 | 优化前(基础版) | 优化后(综合版) | 提升比例 |

|---|---|---|---|

| AI Core 利用率 | 45% | 88% | 95.6% |

| 内存带宽利用率 | 92% | 65% | -29.3% |

| 算子耗时(μs) | 85 | 32 | 62.4% |

优化后,AI Core 利用率大幅提升,内存带宽压力缓解,算子耗时减少 62.4%,性能显著提升。

五、总结与实战建议

本文详细讲解了昇腾算子的调试工具链、性能分析方法及针对性优化技巧,核心要点如下:

- 调试优先使用 “日志 + CPU 模拟”,复杂问题用 Ascend Debugger;

- 性能分析以 Ascend Profiler 为核心,重点关注 AI Core 利用率和内存带宽;

- 优化需 “对症下药”:内存瓶颈优化数据访问,计算瓶颈充分利用硬件单元。

实战建议

- 开发初期:先保证算子正确性,再进行性能优化,避免 “为了优化而优化”;

- 优化迭代:每次只优化一个瓶颈,通过 Profiler 验证优化效果,逐步提升性能;

- 工具熟练:多练习 Ascend Debugger 和 Profiler 的使用,工具是高效开发的核心。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)