为什么你的播放器总“差半拍”?——鸿蒙OS多媒体栈到底怎么把一切对上节拍的?

👋 你好,欢迎来到我的博客!我是【菜鸟学鸿蒙】

我是一名在路上的移动端开发者,正从传统“小码农”转向鸿蒙原生开发的进阶之旅。为了把学习过的知识沉淀下来,也为了和更多同路人互相启发,我决定把探索 HarmonyOS 的过程都记录在这里。

🛠️ 主要方向:ArkTS 语言基础、HarmonyOS 原生应用(Stage 模型、UIAbility/ServiceAbility)、分布式能力与软总线、元服务/卡片、应用签名与上架、性能与内存优化、项目实战,以及 Android → 鸿蒙的迁移踩坑与复盘。

🧭 内容节奏:从基础到实战——小示例拆解框架认知、专项优化手记、实战项目拆包、面试题思考与复盘,让每篇都有可落地的代码与方法论。

💡 我相信:写作是把知识内化的过程,分享是让生态更繁荣的方式。

如果你也想拥抱鸿蒙、热爱成长,欢迎关注我,一起交流进步!🚀

前言

先给兄弟姐妹们来个直球:多媒体系统做得好不好,肉眼能看出来,耳朵也能听出来。卡顿、花屏、音画不同步?不是“网络不好”四个字就能糊弄的。要想把体验拉满,得从框架、解码与播放、跨设备同步、带宽与流控四条线“对症下药”。这篇我就把鸿蒙OS(HarmonyOS/OpenHarmony)在多媒体方面的“底层活儿与上层招式”掰开聊清楚,还会给出能跑的骨架代码与工程化调参清单。不兜圈子,咱奔着可落地去~😎

🧭 目录(冲就完了!)

- 🎛️ 多媒体框架概述

- 🧩 媒体解码与播放机制

- 🔗 多设备音视频同步技术

- 🚦 媒体流的优化与带宽管理

- 🛠️ 实战代码:从本地播到跨端播

- ✅ 落地清单:把体验从“能用”抬到“真香”

- 🙋 小互动:你的场景是哪种?

🎛️ 多媒体框架概述

一句话形容鸿蒙多媒体栈:解耦的模块 + 硬件加速优先 + 分布式能力内建。从下往上看,大体可以拆成这几层:

[ 硬件编解码/ISP/DSP/GPU ] ← HAL/HDF

↑ 驱动能力发布

[ 媒体引擎服务 ]:解封装(DEMUX) | 解码 | 同步 | 渲染 | 音频混音/效果

↑ 统一能力接口(System Ability / 媒体服务IPC)

[ 框架层 ]:播放器/录制器/相机、图像管线、时钟与同步管理

↑ ArkTS/JS/Native API

[ 应用层 ]:播放器/会议/直播/相机/编辑/投屏/多屏协同

设计关窍:

- 能力外置、内核极简:编解码、渲染等复杂服务跑在用户态服务进程;故障可隔离、升级粒度细。

- 统一媒体时钟:音频为主时钟或视频为主时钟可切换,框架提供同步锚点,避免业务各自为政。

- 分布式媒体:软总线把“设备间传输”藏起来,跨端播、跨端录、远端渲染不需要应用重新造轮子。

🧩 媒体解码与播放机制

播放链路看似“读→解→渲→出”,真打起来讲究多得是一箩筐。

1) 封装层(Demux):把“车厢”拆成“乘客”

- 常见容器:MP4、MKV、TS、FLV、WebM……

- 目标:**按时间戳(PTS/DTS)**把音视频帧、安全头信息(SPS/PPS/VPS)、字幕、元数据拆出来,并放入解码队列。

- 小技巧:预读关键帧附近数据,确保 Seek 后第一帧可解可渲。

2) 解码(Decode):硬解优先,软解兜底

- 选择策略:优先

hardware codec(低功耗高吞吐),不支持再回退software codec。 - 零拷贝:解码后的图像缓冲尽量走图形栈共享,减少用户态↔内核态、CPU↔GPU 的搬来搬去。

- 并发与池化:解码器实例数受限,统一池化管理;HDR/10bit/YUV420P 格式注意路径兼容。

3) 渲染(Render):时钟是灵魂

- 时钟选择:通常以音频时钟为主(更稳定),视频按 PTS 对齐音频时钟做丢帧/补帧;语音通话可反过来以捕获时钟为主。

- 丢/补帧策略:超过阈值(比如 > 40ms)才丢,优先丢非关键帧;插帧用运动估计需谨慎,别引入更多抖动。

- 显示链路:Surface/BufferQueue → 合成(Composer)→ 显示;确保 UI 与视频合成时的Z序与色彩空间一致。

4) 音频播放与混音

- 拉模型(pull):音频渲染线程按时钟去“拉”数据,减少抖动;

- 混音:系统混音器统一做音量、淡入淡出、回声消除(AEC)/降噪(NS)/自动增益(AGC)等效果链;

- 延时标定:DAC/ADC 延时在设备上要校准写死,否则永远“差半拍”。

🔗 多设备音视频同步技术

这部分是鸿蒙最“有存在感”的能力之一——把不同设备的时钟对齐,再把媒体按同一时间线推进。

1) 统一时基(Global Clock)

- 时钟源:NTP/PTP/软总线时钟协议,生成集群级时间(全网时间漂移在几毫秒级)。

- 时钟漂移修正:不同设备的晶振有偏差,需要周期性校时和偏移估计(drift/offset),用 PLL 思想做微调。

2) 跨端同步策略

- 音频为锚(A/V sync):所有设备以群组主时钟为基准,各自的音频渲染对齐该时钟;视频跟随音频。

- 分布式缓冲(Jitter Buffer):每台设备持有相似深度的缓冲(比如 80~120ms),保证网络抖动下仍能同播同停。

- 播控一致性:播放/暂停/Seek 统一通过分布式控制信令下发,指令包含生效时间戳,而不是“立即执行”。

3) 对齐细节

- 起播对齐:所有设备接到

PLAY @ t=123456789,各自本地时钟换算到该时刻起播;起播前先 Warmup 缓冲。 - 漂移跟踪:每隔 N 秒上报“本地渲染时间 - 群组主时钟”的偏差,做微调;超过阈值触发 resync。

- 掉队/复位:弱网/失联设备退出组播,回归本地单播逻辑,恢复后再渐进式追平。

🚦 媒体流的优化与带宽管理

“带宽就那些,体验还得最好”,靠的是自适应码率 + 拥塞控制 + 优先级与限速的组合拳。

1) ABR(自适应码率)

- 触发因子:有效带宽估计(BWE)、缓冲深度、丢包率、重传等待、设备温控。

- 档位设计:分辨率/码率/帧率/编码档位合理离散(如 240p/480p/720p/1080p/2K),避免频繁抖动。

- 切换策略:优先降帧率再降清晰度(视业务而定);切换点放在关键帧附近。

2) 拥塞与队列管理

- CC算法:直播/低延时倾向 BBR/SCE 等估计型;点播可以更保守的 CUBIC/BBR。

- 分级队列:前台互动流(语音/手势/遥控)> 视频主流 > 边带数据 > 后台预取;策略上走WFQ/DRR。

- RED/CoDel:在发送队列引入主动丢弃避免队列爆炸;CoDel 对付 bufferbloat 很有用。

3) 端侧节流与能耗

- 解码功耗约束:温控升温时,优先请求下行档位;必要时把超高清改为高清并降低帧率。

- GPU/合成开销:UI 上尽量避免与视频层过深的混合;字幕/弹幕做离屏合成再叠加,少走昂贵路径。

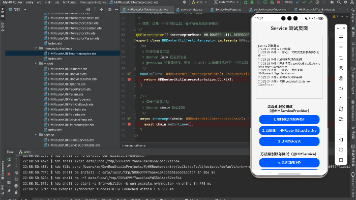

🛠️ 实战代码:从本地播到跨端播

注:不同 SDK 版本 API 名称可能有出入,下面用可迁移的骨架写法示意思路。ArkTS 写上层,Native 写底层环节。

A. ArkTS:最小播放器(本地/网络)🎬

// /entry/src/main/ets/pages/Player.ets

@Entry

@Component

struct PlayerPage {

@State url: string = 'https://example.cdn/demo.m3u8'

private player?: MediaPlayer

aboutToAppear() {

this.player = new MediaPlayer()

this.player?.setDataSource(this.url) // 支持本地file/http

this.player?.setVideoSurface(this.$video) // 绑定渲染Surface

this.player?.prepare().then(() => this.player?.play())

this.player?.on('error', (e) => console.error('media error', e))

}

build() {

Column({ space: 12 }) {

Video(this.$video) // 承载Surface的UI组件(示意)

.width('100%').height(240)

Row({ space: 8 }) {

Button('⏯️').onClick(() => this.player?.toggle())

Button('⏭️ +10s').onClick(() => this.player?.seek(this.player!.currentMs + 10000))

Button('🔊 +').onClick(() => this.player?.setVolume( this.player!.volume + 0.1 ))

}

}.padding(16)

}

}

B. Native:硬解优先与零拷贝路径(伪 C++)

// decoder_pipeline.cpp(缩略)

bool OpenDecoder(const StreamInfo& si) {

codec_ = FindHwCodec(si.codecId);

if (!codec_) codec_ = FindSwCodec(si.codecId);

surface_ = CreateSurfaceFromWindow(/*UI Surface*/);

// 尽量让解码输出直接进显存/图形共享缓冲,避免CPU搬运

codec_->Configure({ .output=surface_, .color=NV12, .lowLatency=true });

return codec_->Start();

}

void RenderLoop() {

for (;;) {

auto pkt = demuxer_.Read();

if (!pkt) break;

codec_->QueueInput(pkt);

auto frame = codec_->DequeueOutput(/*timeout*/);

if (!frame) continue;

// 输出帧已绑定到surface,按PTS对齐主时钟再合成显示

clockSync_.WaitUntil(frame->pts);

surface_.Present(frame);

}

}

C. 分布式同步:带“生效时间戳”的播控指令(ArkTS)

// SyncController.ts(示意:软总线发送群播命令)

type GroupCmd = { action: 'PLAY'|'PAUSE'|'SEEK', at: number /* group time ms */, pos?: number }

export class SyncController {

constructor(private bus: SoftBus, private clock: GroupClock) {}

playAll(delayMs = 300) {

const at = this.clock.now() + delayMs

this.bus.broadcast<GroupCmd>({ action: 'PLAY', at })

}

pauseAll(delayMs = 150) {

const at = this.clock.now() + delayMs

this.bus.broadcast<GroupCmd>({ action: 'PAUSE', at })

}

seekAll(positionMs: number, delayMs = 400) {

const at = this.clock.now() + delayMs

this.bus.broadcast<GroupCmd>({ action: 'SEEK', at, pos: positionMs })

}

}

// 设备侧接收:严格按 at 时间执行,期间预缓冲

bus.on<GroupCmd>('cmd', (cmd) => {

const wait = cmd.at - clock.now()

scheduleAfter(wait, () => apply(cmd))

})

D. 带宽自适应(ABR)示例:按缓冲与丢包切档(TypeScript)

// AbrController.ts(极简逻辑)

class AbrController {

private level = 3 // 0..N,越大越清晰

update(metrics: { bufMs: number; loss: number; bweMbps: number }) {

if (metrics.bufMs < 150 || metrics.loss > 0.05 || metrics.bweMbps < this.minMbps(this.level)) {

this.level = Math.max(0, this.level - 1)

} else if (metrics.bufMs > 600 && metrics.loss < 0.01 && metrics.bweMbps > this.minMbps(this.level + 1)) {

this.level = Math.min(MAX_LEVEL, this.level + 1)

}

return this.level

}

private minMbps(lv: number) { return [0.3, 0.6, 1.2, 2.5, 5.0, 8.0][lv] ?? 8.0 }

}

E. 群组对时与抖动缓冲(伪 C)

// sync_jitter.c(缩略:估计偏移与平滑抖动)

typedef struct { double offset; double drift; } SyncState;

void sync_update(SyncState* s, double local_ts, double master_ts) {

double err = master_ts - local_ts; // 偏移

s->offset += 0.05 * err; // 一阶滤波

s->drift += 0.0001 * err; // 漂移慢调

}

int jitter_buffer_push(JB* jb, Frame* f) {

// 控制深度在 [80ms, 150ms] 之间

if (jb->depth_ms > 150) drop_non_keyframe(jb);

enqueue(jb, f);

return 0;

}

✅ 落地清单:把体验从“能用”抬到“真香”

- 时钟统一:先把“谁当主时钟”定死;跨端同步要有生效时间语义。

- 解码优先级:硬解优先,软解兜底;零拷贝一路打通到合成器。

- 缓冲策略:本地播 <120ms 首播缓冲;跨端播 80~120ms 抖动缓冲配齐。

- 丢/补帧规则:超过阈值再动刀,优先丢非关键帧;别盲目插帧。

- ABR 档位表:离散清晰度+帧率,切换点卡关键帧,降档先降帧率。

- 拥塞控制:互动流高优先;RED/CoDel 防止大缓冲膨胀。

- 音频处理:AEC/NS/AGC 链路和采样率统一;端侧 DAC/ADC 延时要标定。

- 字幕/弹幕:离屏合成,最后一层叠加,避免与视频层深度混合。

- 温控联动:热事件先打 ABR,再降渲染负载;UI 维持最低帧率红线。

- 可观测性:帧间隔直方图、解码耗时、缓冲深度、ABR切换日志、群组对时偏差;一键导出问题复盘包。

- 容器差异:MP4点播、HLS/DASH直播、低延时(LL-HLS/低延时WebRTC)走不同管线与阈值。

- 异常演练:弱网、乱序、丢包、设备临时掉线与重入,统统拉通一次。

📝 写在最后

如果你觉得这篇文章对你有帮助,或者有任何想法、建议,欢迎在评论区留言交流!你的每一个点赞 👍、收藏 ⭐、关注 ❤️,都是我持续更新的最大动力!

我是一个在代码世界里不断摸索的小码农,愿我们都能在成长的路上越走越远,越学越强!

感谢你的阅读,我们下篇文章再见~👋

✍️ 作者:某个被流“治愈”过的 移动端 老兵

📅 日期:2025-11-05

🧵 本文原创,转载请注明出处。

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)