从ONNX图到昇腾执行:CANN模型解析、算子映射与图优化深度揭秘

当一个ONNX算子既不能直接映射,也无法被有效地分解时(例如,它是一个全新的、算法高度特化的操作),我们就遇到了**“算子不支持(Unsupported Operator)”**的情况。最后,CANN的运行时(Runtime)会接管这张执行图,按照优化的顺序,逐一调用TBE对算子进行JIT编译,生成二进制核函数,并下发到NPU的AI Core和AI CPU上执行。算子映射,是整个转换过程的“心脏”

前言

在现代AI工作流中,我们享受着由PyTorch、TensorFlow等框架带来的开发便利。当模型训练完成,我们通常会将其导出为一个标准的、与框架无关的中间表示(Intermediate Representation, IR),以便于后续的部署和推理。在这个领域,ONNX (Open Neural Network Exchange) 已成为事实上的工业标准——它是AI模型的“通用语言(Lingua Franca)”。

然而,昇腾NPU硬件,作为最终的执行者,它听不懂ONNX。它只懂由CANN为其量身打造的“原生指令”。因此,从一个.onnx模型文件,到它能在昇腾芯片上高效运行,中间必须经历一个复杂而精密的“翻译与精炼”过程。这个过程,正是由CANN的**模型解析器(Parser)和图引擎(Graph Engine)**共同完成的。

本文将带领你深入这一核心流程。我们将解剖ONNX模型的内部结构,揭秘CANN如何进行算子映射(Operator Mapping)——包括直接映射、复合映射,以及为何需要自定义算子。最后,我们将探讨CANN如何实施图级优化(Graph-Level Optimization),将一张原始的计算图,淬炼成一个为昇腾硬件深度优化的执行计划。理解这一全链路,是诊断性能问题、进行高级优化的前提。

第一章:ONNX的解剖学 —— AI模型的“蓝图”

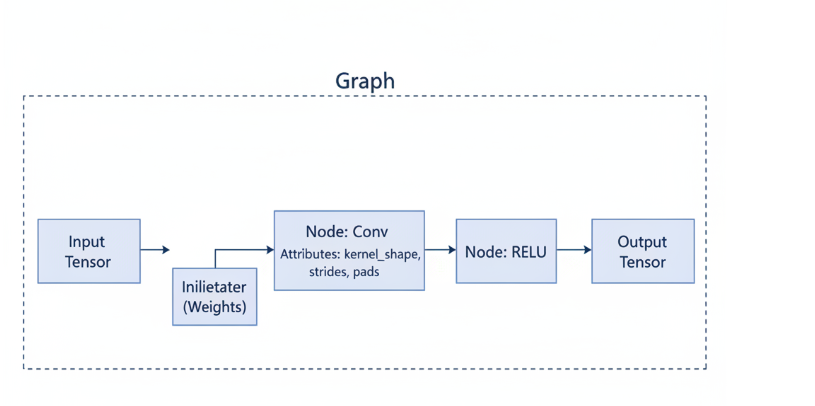

在“翻译”之前,我们必须先读懂“原文”。一个.onnx文件,本质上是一个使用Google Protobuf序列化的数据结构,它描述了一张计算图(Graph)。这张图由以下几个核心元素构成:

- 图(Graph): 整个模型的容器,包含了模型的名称、输入、输出,以及一系列的计算节点。

- 节点(Node): 图中的基本计算单元,代表一个算子操作。每个节点都定义了其操作类型(如

Conv,Relu,MatMul)、输入张量名、输出张量名,以及一系列的属性。 - 张量(Tensor): 图中流动的数据。它有三种角色:

- 图输入(Graph Input): 模型的入口,如图像数据、文本embedding。

- 图输出(Graph Output): 模型的最终结果。

- 权重/偏置(Initializer): 模型的已训练参数,如卷积核权重、全连接层偏置等。它们作为特殊的张量,静态地存储在ONNX文件中。

- 属性(Attribute): 描述节点操作的具体方式。例如,对于一个

Conv节点,其属性会包含kernel_shape(卷积核尺寸)、strides(步长)、pads(填充)等关键信息。

第二章:CANN解析器的工作流 —— 从“.onnx”文件到CANN内部图

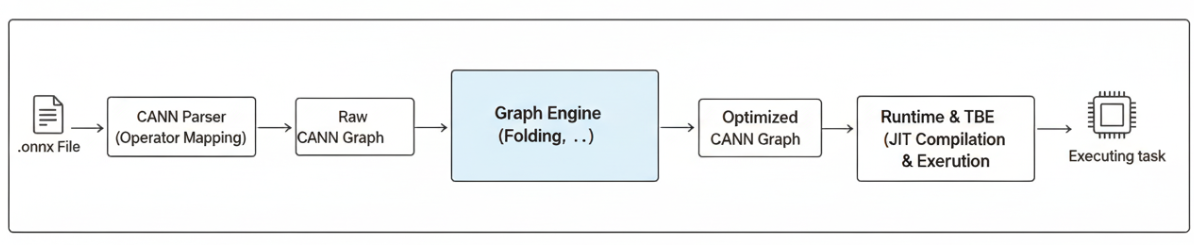

当CANN接收到一个.onnx文件时,其前端的模型解析器会执行一个标准化的流程,将这份“蓝图”转换成CANN自己能够理解和操作的内部数据结构(我们称之为CANN Graph)。

- 加载与反序列化: 使用Protobuf库,读取

.onnx文件的二进制内容,并将其反序列化成内存中的ONNX数据结构对象。 - 图的拓扑排序: 分析图中所有节点之间的依赖关系,生成一个无环的、有序的节点执行序列。这是保证后续处理按正确顺序进行的基础。

- 逐节点迭代映射: 按照拓扑顺序,遍历图中的每一个ONNX节点。对于每一个节点,执行最核心的步骤——算子映射。

第三章:算子映射的艺术 —— 三种核心策略

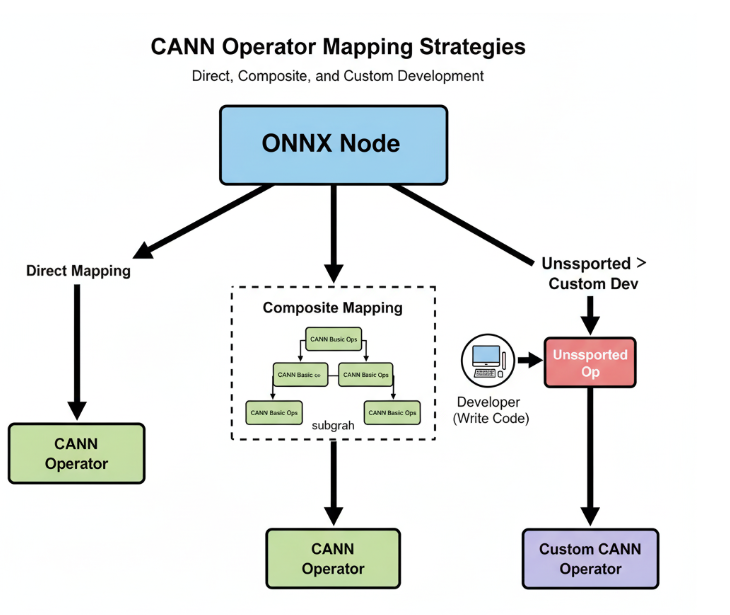

算子映射,是整个转换过程的“心脏”。CANN解析器会为每一个ONNX算子,寻找其在昇腾算子库(OPP)中的等价实现。这个过程并非总是简单的“一一对应”,而是分为三种情况:

3.1 黄金路径:直接映射(Direct Mapping)

这是最理想的情况。ONNX中的某个算子,在昇腾算子库中有功能完全相同、接口兼容的现成算子。

- 示例: ONNX的

Conv算子,可以被直接映射到CANN中高性能的Conv2DTBE算子。解析器只需读取ONNX节点的属性(如kernel_shape, strides),并将其转换为Conv2D算子所需的参数即可。

3.2 迂回之路:复合映射(Composite Mapping / Decomposition)

当昇腾算子库中没有与某个ONNX算子直接对应的实现时,CANN解析器会展现其“智能”的一面。它会尝试将这个复杂的ONNX算子,分解(Decompose)成一个由多个基础的、昇腾支持的算子构成的子图(Subgraph)。

- 经典示例:

LayerNorm

ONNX中的LayerNorm算子,在早期版本的CANN中可能没有原生的单算子实现。此时,解析器会根据LayerNorm的数学公式y = (x - mean(x)) / sqrt(variance(x) + epsilon) * gamma + beta,将其分解为:ReduceMean(计算均值)Sub(输入减去均值)Pow(计算平方)ReduceMean(计算方差)Add(加上epsilon)Sqrt(开方得到标准差)Div(除以标准差)Mul(乘以gamma)Add(加上beta)

这个过程对用户是透明的。你提供的是一个包含LayerNorm的图,CANN在内部将其巧妙地转换成了一个功能等价的基础算子组合。

3.3 必经之途:自定义算子(Custom Operator)

当一个ONNX算子既不能直接映射,也无法被有效地分解时(例如,它是一个全新的、算法高度特化的操作),我们就遇到了**“算子不支持(Unsupported Operator)”**的情况。

这,正是我们需要亲手进行算子开发的根本原因。

此时,我们就需要利用TBE或AI CPU,为这个“未知”的ONNX算子,编写一个对应的CANN算子实现。然后,我们需要提供一个映射文件(Mapping File),告诉CANN解析器:“当你再遇到名为MyCustomOp的ONNX算子时,请调用我开发的这个libmy_custom_op.so”。

第四章:从“功能对等”到“性能卓越” —— 图级优化

当所有的ONNX节点都被成功映射为CANN算子,形成一张初步的CANN Graph后,CANN的图引擎(Graph Engine)会接管过来,进行一系列的“精装修”——图级优化。

4.1 算子融合(Operator Fusion):最重要的优化

这是图优化的“王冠明珠”。GE会扫描整张CANN Graph,寻找可以合并的算子序列,将它们融合成一个单一的、更高性能的融合算子。

- 典型融合模式:

- 计算-激活融合:

Conv+ReLU->ConvReLU - 多操作融合:

Conv+BiasAdd+ReLU->ConvBiasReLU - 归一化融合:

BatchNorm+ReLU->BatchNormReLU

- 计算-激活融合:

融合的巨大优势:

- 减少内存访问: 融合前的

Conv和ReLU需要两次全局内存读写(Conv写回,ReLU再读入)。融合后,Conv的计算结果直接在高速的Local Memory中进行ReLU操作,然后再写回全局内存,节省了一次代价高昂的HBM往返。 - 降低调度开销: 启动一次融合算子的开销,远小于分别启动多个小算子。

4.2 常量折叠(Constant Folding)

如果图中的某个分支,其所有输入都是常量(如模型的权重、固定的超参数),GE会在编译期预先计算出这个分支的结果,并用这个结果(一个常量张量)替换掉整个分支。这减少了运行时的实际计算量。

第五章:从优化图到最终执行

经过GE的深度优化后,我们得到了一张最终的、为昇腾硬件量身定做的执行图(Execution Graph)。

这张图上的节点,可能已经和原始的ONNX图大相径庭——许多节点被合并,一些被替换,一些被删除。

最后,CANN的运行时(Runtime)会接管这张执行图,按照优化的顺序,逐一调用TBE对算子进行JIT编译,生成二进制核函数,并下发到NPU的AI Core和AI CPU上执行。

结论

从ONNX图到昇腾硬件的原生执行,远非一次简单的格式转换,而是一场由CANN主导的、复杂的编译与优化之旅。这个过程,与传统的编译器(如GCC/Clang)将C++代码编译成机器码的过程,在哲学上高度相似。

作为开发者,理解这一链路至关重要:

- 它让我们明白,性能的瓶颈可能出现在链路的任何一环:是某个算子无法高效映射?还是图引擎的融合策略未能生效?

- 它让我们深刻地认识到,自定义算子开发,是打通这条链路“最后一公里”的关键能力,是保证任何前沿模型都能在昇腾平台上顺畅运行的根本保障。

打通全链路的实战平台:

要真正掌握这套复杂的系统,理论学习是远远不够的。2025年昇腾CANN训练营第二季为你提供了绝佳的实践机会:

- 系统化课程: 从单个算子开发,到模型部署,为你串联起完整的知识链条。

- 官方工具链: 亲手使用Profiler等工具,去观察和验证图优化的实际效果。

- 权威技能认证: Ascend C中级认证,证明你具备了解决端到端部署问题的全栈能力。

- 丰富的实践激励: 完成任务更有机会赢取华为手机、平板、开发板等大奖。

如果你渴望从一个“模型使用者”成长为一名洞悉全局的“AI系统工程师”,那么,现在就启程吧。

报名链接: https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)