从“即看即购”到开放SDK:Rokid如何为AR眼镜构建应用生态

近期,关于Rokid与京东科技合作的新闻引起了业内关注。双方联合发布了名为“JoyGlance”的购物智能体,以实现“所见即购买”的体验。

这次合作的核心应用“JoyGlance”,本质上是对传统电商购物流程的一次重构。它将手机端复杂的步骤,尝试压缩为AR眼镜上的三步交互。

1.输入端变革

传统购物依赖手机屏幕和手指输入。而JoyGlance将交互入口转移到了眼镜的摄像头和麦克风阵列。用户通过“注视”这一动作锁定目标物品,替代了“打开App、搜索框输入”的过程。这背后是基于第一视角(FPV)的计算机视觉(CV)识别技术。当用户注视物品1-2秒,系统即触发识别和搜索。

2.核心处理

唤起应用后,系统需要理解用户的意图。JoyGlance集成了京东科技的“意图识别+智能搜品”能力。当识别出物品后,它会直接在京东的商品库中进行匹配,并将结果呈现在用户眼前的AR界面中。这标志着物理世界中的非结构化视觉信息,被成功转化为了结构化的电商数据。

3.支付安全

支付是所有商业闭环的最后一公里。在不方便拿出手机的场景下,支付的安全性至关重要。该方案采用了“语音指令+声纹识别”的多模态生物特征融合技术。用户需要说出预设的语音密码,系统会同时验证“内容”和“声纹”两个维度。相比单一的指纹或面部识别,这种方式理论上提供了更高的安全冗余,旨在满足金融级支付场景的需求。据称,该技术在防录音攻击、防声纹合成方面也进行了算法优化。

这个应用案例,可以看作是AR眼镜在C端消费场景的一次重要探索。它展示了在健身、居家等“解放双手”的特定场景下,AR眼镜作为信息中枢的实用价值。

与此同时,就在九月初,Rokid开放平台(ar.rokid.com)正式上线了面向Rokid Glasses的开发SDK。这是该公司首次为智能眼镜(非纯AR眼镜)开放完整的开发工具链。

这意味着,开发者现在可以调用AR眼镜底层的核心能力,包括:

AI接口:允许开发者集成自己的或第三方的AI算法模型,用于识别、分析等任务。

交互接口:获取眼镜的语音、视觉等交互数据,用于定义新的交互逻辑。

传感器接口:访问陀螺仪、加速度计等传感器数据,为应用开发提供更多环境感知维度。

该平台目前支持YodaOS-Master(面向AR Studio/AR Lite)和YodaOS-Sprite(面向Rokid Glasses)双操作系统,为不同硬件和场景需求提供了差异化的开发支持。

对于有兴趣的开发者,接入流程也相对标准化。以其移动端开发套件(Rokid Mobile SDK)为例,主要步骤如下:

1.注册与申请:在Rokid开放平台注册开发者账号,获取AppKey等开发凭证。

2.集成SDK:将官方提供的 Mobile SDK 集成到自己的iOS或Android项目中。该SDK封装了设备配网、指令发送、设备管理等基础能力。

3.开发与调试:利用官方文档和调试工具进行应用功能开发。

Swift:

RokidMobileSDK.shared.debug = true

4.发布上线:应用测试通过后,即可在Rokid的应用商店或其他渠道发布。

此外,官方也推出了“开发者尝鲜计划”,为早期参与的开发者提供一定的硬件支持,这表明了其推动生态建设的初步意愿。

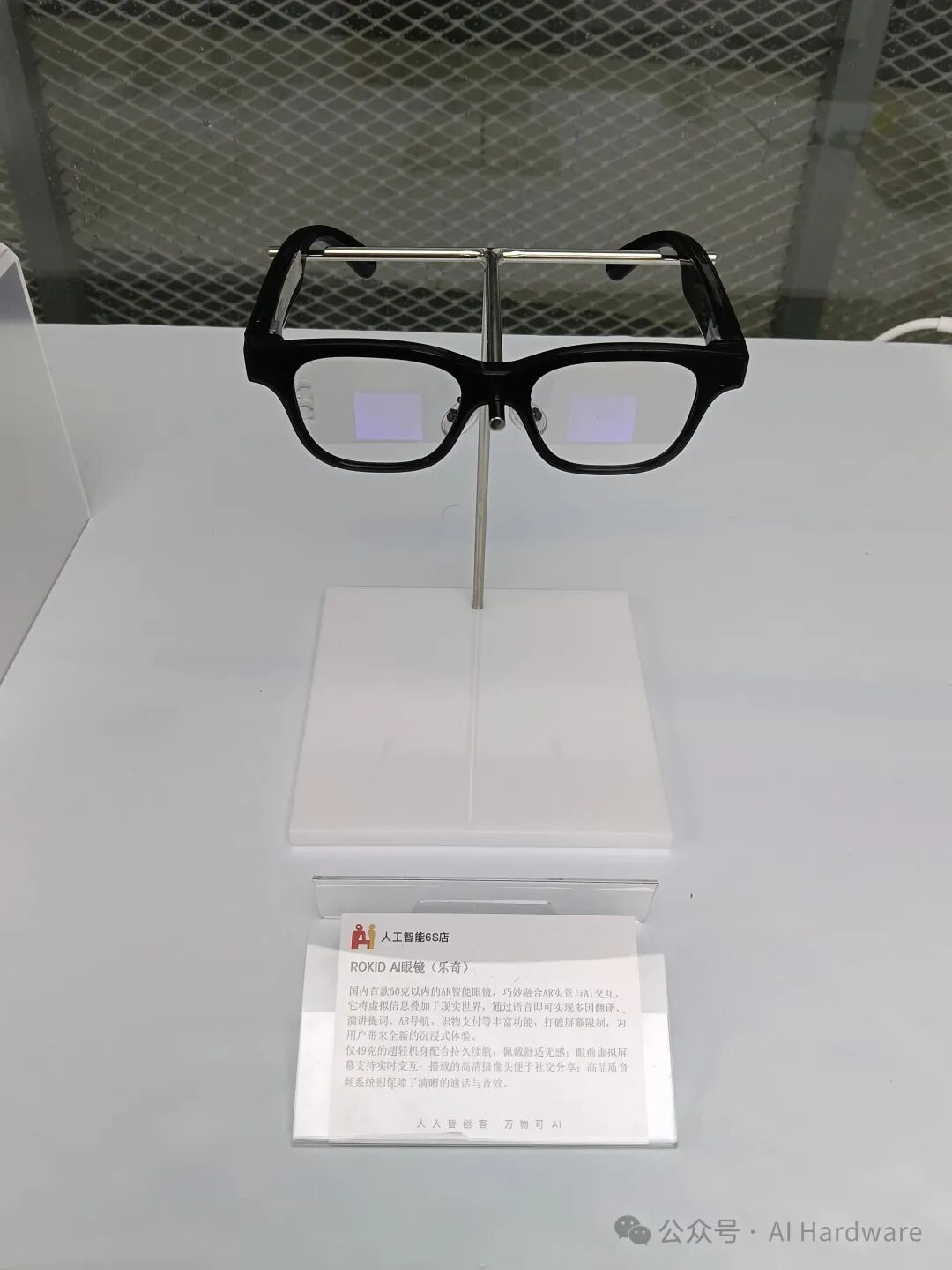

纸上得来终觉浅,一个新平台的潜力,最终要通过交互的流畅度、视觉延迟和真实场景下的稳定性来检验。欢迎所有对乐奇或是此技术感兴趣的朋友们,前来我们的人工智能6S店进行体验。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)