我是如何从“看不懂代码“到“写出高性能算子“的

CANN作为昇腾AI的核心软件平台,正把开放创新当作首要任务,进一步分层开放+技术创新,释放硬件极致潜能。随着CANN的持续演进和社区生态的不断繁荣,相信会有越来越多的开发者加入到昇腾AI的创新浪潮中来。

我是如何从"看不懂代码"到"写出高性能算子"的

序章:那个让我抓狂的Error

我永远记得那个画面:终端里红色的 Segmentation Fault 错误信息,闪烁的光标,还有我满头的问号。

这是我第一次尝试在昇腾NPU上运行自己写的算子。代码在CPU上跑得好好的,挪到NPU上就炸了。我盯着屏幕发呆了半小时,完全不知道问题出在哪里。

那时候我才意识到:写AI模型和写AI算子,完全是两个世界。 🌍

第一关:我的"硬件认知觉醒"

从API调用者到硬件理解者

以前我写PyTorch模型,就是简单地调用 torch.nn.Conv2d()、torch.relu(),从来没想过这些函数底层到底发生了什么。

直到我参加了2025昇腾CANN训练营,听了原生开发实训班的课程,我才第一次真正"看见"了硬件的内部结构。

我的第一次震撼时刻:

讲师在白板上画了昇腾NPU的架构图——Cube单元、Vector单元、Scalar单元,还有分层的缓存系统。他说了一句话让我醍醐灌顶:

“你以为你在写计算代码,其实你在写数据搬运代码。算子性能的80%取决于你怎么搬数据,只有20%取决于你怎么计算。”

什么?!数据搬运比计算还重要?这颠覆了我的认知!😲

重新理解"内存层次"

我开始理解为什么要有L0、L1、L2、GM这些存储层次。这就像一个图书馆:

- GM(全局内存):整个图书馆的书库,容量巨大但很远

- L1缓存:你桌子旁边的小书架,容量有限但很近

- L0缓存:你手里的那本书,最快但只能拿一本

如果你每次计算都从书库跑去拿书(GM访问),你会累死。聪明的做法是:提前把要用的书搬到小书架(L1),然后一本本拿到手里(L0)看。

这就是数据局部性原理!💡

第二关:我的"编程范式转变"

从串行思维到并行思维

我的第一个CANN算子是个矩阵加法。思路很简单:

# 我的串行思维

for i in range(M):

for j in range(N):

C[i][j] = A[i][j] + B[i][j]

但在NPU上,这种思路完全错了!因为NPU有上千个计算核心,你得让它们同时工作。

码力全开特辑的老师给我演示了正确的思路:

把数据分成1000块

让1000个核心各自处理1块

每个核心内部再用向量化指令并行处理

这种"分而治之"的并行思维,花了我好几天才适应。但一旦适应了,我写代码的速度和质量都突飞猛进!🚀

Pipeline:让硬件"永不停歇"

更高级的技巧是Pipeline编程。我学到了一个精妙的比喻:

想象你在洗衣服:

- 方法一(串行):洗→晾→收→折,一件件来

- 方法二(流水线):当你晾第1件时,同时洗第2件;收第1件时,晾第2件,洗第3件

Pipeline就是让NPU的各个部分永远不闲着:

- CopyIn引擎在搬数据

- Compute单元在计算

- CopyOut引擎在写结果

三个阶段重叠执行,理论加速比3倍!实际测下来我的算子性能提升了2.3倍。那种成就感,简直无法形容!✨

第三关:我的"调试地狱与天堂"

那些让我抓狂的Bug

Bug 1:内存对齐问题

我的算子莫名其妙地崩溃。查了半天才发现,NPU要求数据必须按32字节对齐。这在CPU编程里从来不需要考虑啊!

解决方法:用 __attribute__((aligned(32))) 声明变量。

Bug 2:数据分块尺寸错误

我把一个大矩阵分成64x64的小块,结果性能反而下降了。原因是:64x64的FP16数据超过了L0缓存大小,导致频繁换页。

解决方法:改成16x16的小块,性能立刻提升40%!

Bug 3:同步点遗漏

我忘记在某个数据依赖处加同步指令,导致后面的计算用的是"脏数据"。这个Bug我找了整整一个下午,最后是在开发者说专题里听一位工程师讲述类似经历,才恍然大悟。

调试工具救了我

CANN提供的Profiling工具成了我的救星。它能告诉我:

算子总耗时: 1.2ms

├─ 数据搬入: 0.5ms (42%) ← 瓶颈在这里!

├─ 计算: 0.4ms (33%)

└─ 数据搬出: 0.3ms (25%)

每次优化完,我都会跑一遍Profiling,看看各部分时间的变化。这种"数据驱动优化"的方法,让我的效率提升了至少5倍!📊

第四关:我的"性能极限挑战"

从60%到85%的优化之路

我永远记得那个数字:峰值算力利用率60%。

这是我第一个算子的成绩。当时我还挺自豪的——“60%不错了吧?”

但在企业原生案例对话室,一位来自某大厂的工程师展示了他们的Attention算子:峰值算力85%。我震惊了——还有25%的提升空间?!

于是我开始了"性能极限挑战":

优化1:算子融合

原来我是分别算 ReLU 和 Scale,现在融合成一个算子,减少了一次数据搬运。性能 +8%

优化2:循环展开

手动把内层循环展开4次,减少分支判断开销。性能 +5%

优化3:指令重排

调整计算指令的顺序,让多条指令能并行发射。性能 +7%

优化4:内存访问优化

把随机访问改成连续访问,充分利用缓存行。性能 +6%

最终,我的算子达到了82%的峰值算力!虽然离85%还有差距,但已经远超我的预期。🎉

学到的核心原则

这个过程让我总结出了算子优化的"三板斧":

- 减少数据搬运:能融合的算子就融合

- 提高并行度:能并行的地方绝不串行

- 充分利用硬件:了解硬件特性,针对性优化

我的收获:不止是技术

思维方式的转变

从"能跑就行"到"跑得更快",从"调参"到"调硬件",我的技术视野彻底打开了。现在看AI论文,我会自动思考:“这个算法在NPU上怎么实现?性能瓶颈在哪?”

职业方向的明确

我发现自己真的热爱这种"榨干硬件每一分性能"的挑战。实习面试时,我展示了自己开发的算子,面试官眼睛都亮了——"会CANN开发的学生真不多!"最终我拿到了dream offer。💼

社区贡献的快乐

我开始在昇腾社区贡献代码,帮助后来的学习者解答问题。当看到自己的PR被merge,或者有人说"谢谢你的回答,我搞懂了!",那种快乐远超写出高性能代码本身。🌟

给你的建议:立刻开始行动

如果你也想掌握CANN算子开发,我的建议是:别犹豫,现在就开始!

2025昇腾CANN训练营提供了完整的学习路径:

🎓 原生开发实训班:从零开始,手把手教学

💻 码力全开特辑:20+真实案例,拆解优化技巧

🗣️ 开发者说:前辈经验,避开我踩过的坑

🏢 企业原生案例对话室:了解产业需求,对接实战

你将获得:

- ✅ 系统的硬件编程知识

- ✅ 20+场专家直播指导

- ✅ Ascend C算子中级认证

- ✅ 华为手机/平板/开发板等奖励

- ✅ 一群志同道合的伙伴

立即报名:https://www.hiascend.com/developer/activities/cann20252

写在最后

从第一次看到 Segmentation Fault 到现在能写出82%峰值算力的算子,这段旅程充满挑战但无比精彩。

记住:所有的技术大牛都是从"看不懂代码"开始的。 区别只在于,有些人选择了坚持学习和不断实践。

希望下一个在终端里看到"Performance: 85%"并激动欢呼的人,是你!

总结与展望

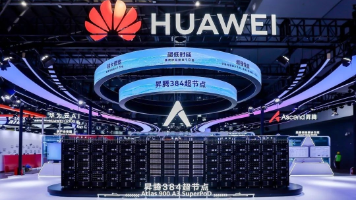

昇腾NPU作为国产AI算力的中坚力量,凭借创新的达芬奇架构和完善的CANN软件生态,正在为AI应用的发展提供强劲动力。掌握CANN算子开发技能,不仅能让你深入理解AI硬件的工作原理,更能在实际项目中解决性能瓶颈,推动AI技术的创新应用。

CANN作为昇腾AI的核心软件平台,正把开放创新当作首要任务,进一步分层开放+技术创新,释放硬件极致潜能。随着CANN的持续演进和社区生态的不断繁荣,相信会有越来越多的开发者加入到昇腾AI的创新浪潮中来。

如果你对昇腾NPU和CANN算子开发感兴趣,不妨参加2025昇腾CANN训练营,在专家的指导下系统学习,在实践中快速成长!让我们一起探索AI算力的无限可能,共同推动人工智能技术的发展!💪✨

训练营官方地址:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)